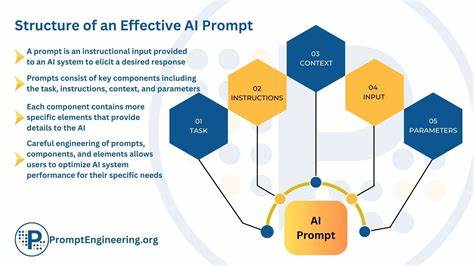

随着人工智能技术的飞速发展,尤其是大型语言模型(LLM)在各类应用场景中的广泛应用,如何高效管理和优化这些模型的提示(prompt)成为了业界关注的焦点。PromptBuild.ai作为一款专业的LLM提示管理平台,旨在为开发者和企业提供一站式的解决方案,助力他们轻松管理、测试、部署和扩展提示,保证模型输出的质量和稳定性。本文将深度解读PromptBuild.ai的核心功能、使用优势以及未来发展方向,帮助读者全面了解其为何成为专业提示工程师和团队的首选工具。Prompt管理的重要性在于,提示直接影响LLM输出的准确性和效果,尤其在定制化场景和高并发应用中,一个高质量的提示能够帮助模型更好地理解用户意图,从而生成更为精准和自然的回复。传统的提示管理往往分散且缺乏系统化,更新或调整时容易出现版本混乱、回退困难等问题,严重影响业务的稳定性与协作效率。PromptBuild.ai通过引入类似Git的版本控制机制,让团队能够对每次提示的变更进行精细化管理。

每个提示都会保存详细的版本历史、变更记录和作者信息,用户可以随时查看不同版本的差异,甚至一键回滚到某个稳定版本,确保业务运转的连续性与安全性。平台内置的高级编辑器由Monaco(Visual Studio Code的核心编辑器)驱动,具备语法高亮、变量自动补全、实时预览等功能,大幅提升提示编写的准确度和效率。该编辑器支持多种变量替换及模板构建,方便开发者设计复杂的提示逻辑,实现灵活多变的交互效果。此外,PromptBuild.ai重视团队协作,提供项目管理和协同工作功能,用户可以将提示组织到不同项目中,为不同团队成员分配权限,并利用即将上线的实时协作功能实现多人在线编辑、评论反馈和审批流程。这样的功能设计极大地提升了提示工程的整体质量与响应速度。平台还内置交互式测试界面,允许用户替换提示中的变量并实时观察模型响应,评分和反馈系统则可帮助团队跟踪不同提示版本的表现,为持续改进提供数据支持。

多环境管理功能支持用户在开发、测试和生产环境中安全地切换与验证提示,避免未验证变更影响上线,从而保障用户体验与数据安全。PromptBuild.ai不仅关注功能的全面性,还注重系统的高性能和可扩展性。它提供了分布式全球CDN加速,确保提示信息能快速传递至全球用户,同时拥有自动弹性扩展的生产级API接口,可支撑每日百万级别的API调用,延迟低于100毫秒,满足高并发应用的严苛需求。安全设计方面支持多API密钥管理,实现基于角色的访问控制和限流策略,保证每个服务或团队的访问权限精细划分,提升使用过程的安全性。价格策略上,PromptBuild.ai区别于传统的项目数量限制,采用仅限制API调用次数和团队成员数的方式,所有计划均支持无限制的项目数量和提示版本,免费计划更是提供了无限制的团队与提示管理功能,为初创团队和个人开发者提供极大便利。这种灵活、透明的定价模式鼓励用户大胆尝试与扩展业务,无需担忧被非必要的条款束缚。

未来,PromptBuild.ai计划推出更多高级功能如成本追踪与优化分析、自动草稿保存与恢复、多模式内容索引和企业级定制服务,进一步满足复杂企业环境的需求。综合来看,PromptBuild.ai不仅优化了提示管理流程,降低了开发维护成本,而且大幅提升了团队协作效率和提示质量控制水平。对于希望系统化开展提示工程的个人开发者、初创企业以至大型组织而言,它是一个极具吸引力的选择。随着LLM应用不断深入各行各业,PromptBuild.ai有望成为行业领先的专业提示管理平台,助力更多用户迈向智能化prompt开发新时代。总之,PromptBuild.ai通过强大的版本控制、专业的编辑及测试工具、灵活的团队协作机制、稳定快速的生产环境和合理透明的价格体系,构成了一个高效且安全的LLM提示解决方案。无论是在提升AI系统的稳定性,还是推动企业智能升级方面,它都展现了非凡的实力与潜力。

未来,随着产品功能的不断完善和社区的壮大,PromptBuild.ai将为更多用户带来更为卓越的提示管理体验,助力他们在人工智能领域实现更大突破。