随着大型语言模型技术的迅猛发展,很多用户和开发者都希望找到一个快速且有效的方法,让模型具备类似人类专家的推理能力。早期的经验告诉我们,通过添加“逐步思考”的提示,模型可以在一定程度上完成更复杂问题的推理,取得更好的回答效果。这种提示技巧在实践中普及开来,成为提高模型表现的主要方法之一。然而,随着专门推理能力模型的出现,人们逐步意识到,真正的推理并非仅仅依赖巧妙设计的提示,而是模型训练过程中的核心能力塑造。理解这一点,对于人工智能行业的从业者以及最终使用者来说都至关重要。 许多传统的语言模型本质上围绕着下一个词预测任务进行训练。

它们在大量文本数据上学习词汇和语义模式,善于生成自然流畅的回答,但缺乏内在的分析规划能力。当试图让它们“思考”或者“推理”时,常常借助提示中加入诸如“请先思考问题的核心”“逐步解题”等描述,引导模型模拟类似人类的思考流程。这种方法能在一定程度上改善模型的成绩,特别是对于格式规范、问题类型稳定的场景。这种方法的优点是易用、即时,无需再训练模型,降低了实现门槛。同时,也带来了明显的局限性。 推理提示设计本质上是向一个没有真正推理能力的系统施加外部脚本,其效果高度依赖于提示的精细程度和适用范围。

面对生活中复杂多变、富有层次感的问题,固定的提示会显得苍白无力。例如,对一个简单问候“你好”或基础数学问题“2加2等于几”,如果强行添加繁复的思考提示,反而会降低交互效率和用户体验。因此,提示设计需要灵活调整推理强度,基于问题的复杂度、长度甚至文本关键词等线索制定应对策略。然而,这种动态调整往往极其复杂且脆弱,很难实现普适且稳健的解决方案。 一个形象的比喻是将传统语言模型视作刚入行的面试官。他们手里拿着一本笔记,知道需要问开放性问题、关注细节、判断文化契合度,即使机械地按照指引操作,也能够比未准备者表现得更好。

但面对真正经验丰富的面试官,凭借多年的积累和临场智慧,他们能够敏锐捕捉微妙反应,灵活调整问题策略,甚至察觉隐藏意图。模仿经验丰富者的思考模式不是简单添加一套规则,而是通过不断实践中积累的“直觉”和“策略”。同理,语言模型中的“推理”能力,也是通过大量专门设计过的训练任务和数据反复积累的产物,不是单一提示能达成的。 真正具备推理能力的模型,其训练过程区别明显。他们不仅仅学习预测下一个词,更被暴露于需多步骤分解问题、识别隐含假设、设计行动计划及核查中间答案的复杂任务之中。这些训练目标让模型的神经网络权重和激活模式自然而然地倾向于内部构建多层次的分析流程。

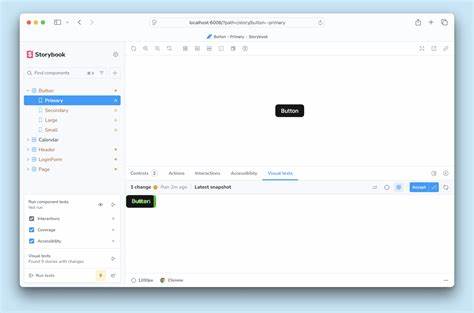

模型“本能”地完成诸如澄清模棱两可的表述、识别核心子问题、权衡边缘情况甚至制定详细计划的步骤,无需额外提示。 现代一些领先模型如谷歌的Gemini便体现了这一理念。启用“思考模式”时,实际切换的是一个训练专门强化推理功能的模型版本,而非仅仅增大提示长度或复杂度。该版本的行为自带拆解任务、自问自答的机制,能有效避免跳跃式逻辑和表面推理。换言之,推理能力已经内嵌在模型的参数和架构中,而不是靠外部提示临时灌输。 这种观点与心理学和认知科学中专家技能养成的理论相契合。

马尔科姆·格拉德威尔提出的“万小时定律”指出,在复杂领域真正成为专家,需要进行成千上万小时的刻意练习,积累识别模式和高效处理信息的直觉。国际象棋大师不会仅凭瞬间判断做出最佳走法,他们依赖丰富的实战经验识别棋局中的战术、陷阱和战略布局。对语言模型来说,巧妙的提示就像给初学者准备的笔记,但实现顶尖推理效果,唯有大量高质量针对推理的训练数据与恰当的训练架构相结合。 此外,深入训练推理能力的模型在面对多样且不确定的问题时更具稳健性。他们能够更好地跨领域应用技能,处理未见过的复杂问题,而非陷入已知提示模式的限制。对于企业和研究者而言,选用此类模型意味着在客户服务、知识问答、复杂决策支持等多场景实现更高质量的自动化交互,减少错误和用户挫败感。

总结来看,推动语言模型推理能力的提升,不能靠巧妙提示的堆砌,而需根植于模型的训练设计。将推理能力视作一种可训练的技能,围绕问题分解、假设验证和规划策略等核心要素设置训练目标,才是实现专家级多步推理的根本路径。面对多变复杂的实际应用场景,依赖稳定且本质上具备推理能力的模型,是确保性能和体验的最佳选择。 对于未来人工智能发展趋势而言,训练而非简单提示的观点提醒我们,技术创新不应仅停留在使用层面,更要深入底层模型架构与训练策略。随着算力提升和训练数据不断丰富,我们有望见证更多具备深层次认知和推理能力的智能系统,真正实现智能助手向专家顾问的跨越。只有认识到推理是一种经过反复练习和精心设计才能形成的能力,开发者和用户才能理性期待并选择最适合自己的智能工具,推动人工智能迈入更高智力层次的新阶段。

。