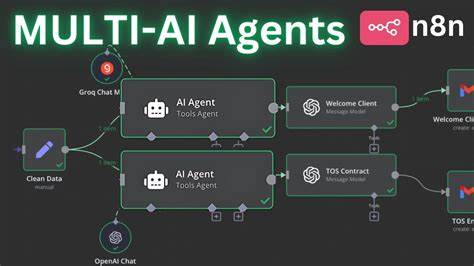

随着大型语言模型(LLM)和人工智能代理的迅速崛起,开发者和企业纷纷尝试采用多代理架构以实现并行处理和任务分解的优势。多代理系统概念看似合理,允许智能体在多个子任务之间分配工作,通过各代理协作完成复杂目标,理论上能够提升效率和成果质量。然而,2025年的实践经验表明,这种多代理架构存在明显的固有缺陷,尤其是在长期任务和复杂上下文管理方面表现出严重的脆弱性,反而容易导致系统出现错误叠加和决策冲突,严重影响性能和可靠性。上下文工程作为当前智能体设计的核心关键,强调了在智能体交互和决策过程中共享全面、连贯的上下文信息的重要性。智能体要准确完成任务,必须对问题背景、先前决策以及相关行动有清晰认知,而多代理架构由于信息割裂,难以保证各代理拥有一致和完整的上下文,导致子代理在理解任务边界与细节时频频产生误解。以构建“Flappy Bird”游戏为例,将整体任务拆分为背景构建和角色设计的子任务。

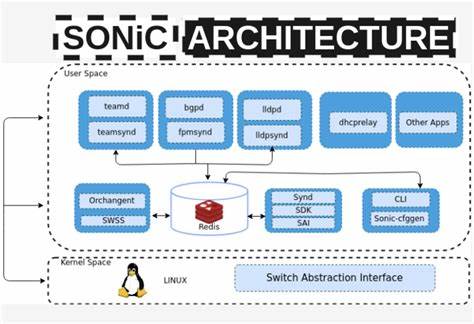

如果子代理对任务理解产生偏差,例如后台构建成了超级马里奥风格的场景,角色动作与游戏特性严重不符,最终汇合的结果将会失去整体的协调性和游戏体验。这种情况下,主代理不得不处理来自不同子代理的相互冲突和不兼容的输出,进一步增加了系统复杂性和错误发生的可能。部分开发者认为复制完整任务描述至各子代理能解决这一问题,但事实上,这并不能涵盖任务在多轮交互中产生的动态变化和决策链条,且在实际工程系统中子代理往往需要处理来自多工具调用和用户反馈的复杂上下文,单纯的文本复制难以实现信息完整传达。此外,多代理之间的独立决策行为隐含着重要的决策逻辑,当多个代理基于不同假设做出各自选择时,冲突不可避免。每一次行动都携带着潜在决策,这些决策如果相互矛盾,系统最终表现必然失衡与不可靠。基于这些挑战,构建单线程线性智能体成为提升稳定性与连贯性的关键路径。

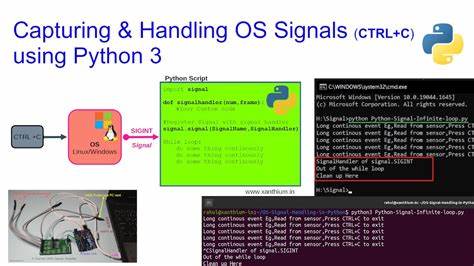

线性智能体以连续的上下文为基础,确保所有输入、输出和决策都在同一逻辑链条上运行,减少了信息割裂和决策冲突的风险。这种架构对开发者来说更易于调试和优化,也利于维护任务的一致性和完成度。为了突破上下文窗口限制和提升处理大规模复杂任务的能力,提出了利用专门设计的语言模型对历史对话和行动轨迹进行压缩、提炼关键信息的策略。这样能够有效管理长时间运行的智能体上下文,保留最核心的事件与决策,为后续步骤提供精炼且有用的背景知识,支持智能体持续保持高效和精准的任务执行。现今部分知名智能代理系统,如Claude Code采取了受控的子任务机制,子代理仅承担特定查询或信息检索任务,避免大规模并行操作,规避因缺乏全面上下文导致的矛盾与错误。与此同时,在多年前普遍存在的代码编辑模型实践中,将大型模型输出的变更说明由小型编辑模型具体执行的方案,也因小模型对说明的误解频发而逐步被淘汰。

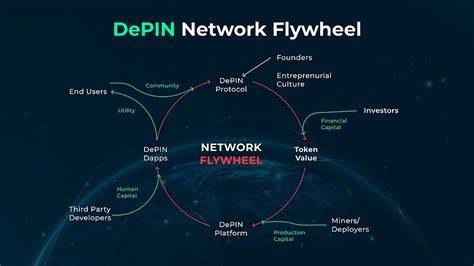

这些实例折射出跨模型、跨代理信息传递的误差放大和管理难题。有人期待未来多代理间通过“对话”实现协同和冲突调解,如同人类工程师之间的沟通一样达成共识。但当前技术阶段,人工智能代理距离人类在复杂交流和知识共享的精准度尚有较大差距,因而多代理系统依然难以实现真正高效且可靠的集体协作,往往陷入信息不对称和决策分散的困境。面对多代理的内在不足,智能体研发应回归对上下文完整性和决策一致性的重视,倾向于构建具备连续上下文感知和统一决策系统的单线程智能体架构。这样的设计虽然看似牺牲了部分理论平行性的优势,但却为系统的健壮性、用户体验和开发维护带来了显著提升。与此同时,背景工程作为一种系统性方法论,涵盖了自动化上下文管理的最佳实践,是稳定长时间运行智能体的“利器”,其重要性将在未来进一步凸显。

站在2025年的技术前沿,构建AI代理系统需要深刻理解并规避多代理架构带来的上下文割裂和行动冲突,拥抱单线程设计并结合先进的上下文压缩与管理策略,这不仅是实现高效协作和长周期任务完成的必要条件,也是推动AI代理广泛应用于生产环境的基础保障。随着技术的不断进步和研究的深入,未来智能代理或将突破现有瓶颈,实现多代理之间更高效的交互与协作,但目前阶段的最佳实践显然是坚守上下文共享和决策统一的核心原则,量力而行,走实走稳。为此,开发者应重视上下文工程的理念,将所有行动纳入统一的决策框架,明确责任归属和信息传递路径,确保智能体每个动作都建立在对全局决策与历史轨迹的清晰认知基础之上。这样才能在动态、复杂、不确定的现实环境中,打造出可靠、灵活且高效的AI代理系统,推动人工智能技术迈向更为成熟和应用广泛的未来。