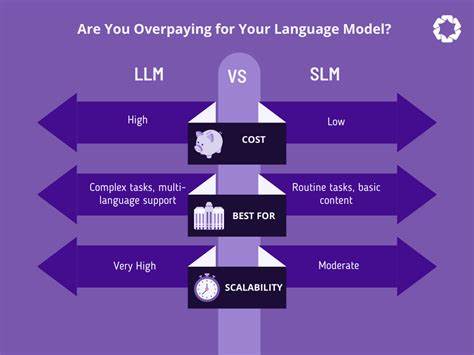

随着人工智能技术的飞速发展,特别是在大型语言模型(Large Language Models,简称LLM)领域,越来越多的企业和开发者开始将这类模型应用于客服、内容生成、数据分析等多个场景。然而,在选择和使用LLM时,许多用户却没有意识到自己实际上可能正在为这项技术支付过高的成本。本文基于对439款不同LLM的深入分析,旨在揭秘目前市场上常见的价格和性能不匹配现象,帮助用户更明智地选择最适合自身需求的模型,避免不必要的浪费。 大型语言模型的广泛应用离不开其强大的理解和生成能力,但不同模型在质量、速度、上下文窗口大小及价格等维度上存在显著差异。通过对439款模型的系统对比,我们不仅关注了各种主流和新兴模型的性能表现,还详细分析了它们的价格策略,揭示了影响使用成本的关键因素。 首先,模型的质量指数(Quality Index)是衡量其综合能力的重要指标,它结合了自然语言理解、生成流畅度、准确性和召回率等多方面指标。

分析中发现,高质量指数的模型如OpenAI的GPT-5系列表现优异,尤其是其中、高端版本,在上下文窗口和响应速度上均具备较大优势。但令人惊讶的是,这些高性能模型的价格并非总是均匀分布,用户在选择过程中往往忽视了性价比的差异。 价格因素是影响LLM选择的核心因素之一。从价格区间来看,不同模型每百万token的价格差距极大,低至每百万token仅需0.05美元的开源模型,也有高达数十美元的闭源服务产品。特别是在诸如Claude 4.1 Opus等高价模型中,虽然性能表现不错,但每单位token的成本远高于市场平均水平。这种价差直接导致许多用户支付了远高于实际所需的费用。

此外,供应商和部署平台同样影响整体成本。多家顶级模型在不同云服务平台上的定价策略存在显著差异,比如同一款GPT-5模型在OpenAI自有平台和Microsoft Azure之间的价格和响应速度就有所不同。值得注意的是,一些次级供应商或新兴云平台提供更具竞争力的定价和低延迟访问体验,为用户提供了极具吸引力的替代方案。 从上下文窗口大小的角度考虑,较大的窗口能够处理更长文本,适合复杂任务和长对话需求。尽管许多高端模型提供高达数百万token的上下文能力,但其价格也相应较高。实际应用中,部分用户并不真正需要极大上下文支持,选择中等上下文窗口的模型不仅能满足业务需求,还能大幅节约成本。

速度和延迟是另外两个不容忽视的性能指标。响应速度越快,用户体验越佳,尤其是在实时应用场景中显得尤为重要。经过对比,一些低价模型的速度明显优于部分高价模型,结合实际业务需求优化选择,可以避免为速度差异支付过高溢价。 开源模型的兴起为用户提供了更多低成本选择,许多开源方案在价格优势明显的同时,也在性能上逐步接近商业闭源模型。通过合理配置资源和技术支持,企业可以在不牺牲太多性能的情况下,显著降低LLM使用成本。 那么,如何开始选择最划算的LLM?首先明确自身需求,针对任务复杂度、响应时长、文本长度等指标进行评估。

其次,通过对比不同模型的质量指数与价格确定最适合的方案。再次,关注供应商的服务质量与技术支持,确保使用过程顺畅。最后,积极尝试开源与商业模型的结合,最大化性价比。 总结来看,当前LLM市场价位的多样性为用户提供了丰富的选择机遇,但不合理的购买决策极易导致额外支出。深入分析439款模型的数据告诉我们,理性的消费观念和科学的模型选择流程至关重要。价格透明度提高和性能数据公开将推动市场更加健康竞争,用户也能在未来享受到更具成本效益的AI服务。

面对快速变化的技术环境和多样化的需求,用户保持对市场动向的敏感度和对技术细节的理解,将成为切实降低人工智能应用开支的关键。运用全面的数据分析工具,结合自身应用背景,才能真正避免“为LLM买单过多”的误区,实现既高效又经济的智能转型。