在现代数据驱动的商业环境中,实时数据的传输和复制成为各行业数字化转型的关键环节。尤其是在使用Apache Kafka作为核心数据流平台的企业中,如何有效复制Kafka集群中的数据,保障数据的高可用性和多环境同步,成为衡量企业数据架构成熟度的重要标志。然而,目前市场上的Kafka数据复制解决方案往往存在复杂、成本高昂、依赖性强的弊端,难以满足日益多样化和灵活的业务需求。作为Kafka领域的领军企业,Lenses.io推出的K2K(Kafka-to-Kafka)解决方案,正打破现有格局,以其开源、跨供应商兼容及出色的开发者体验,为行业带来颠覆性的变革。数据复制为何如此关键?数据在产业链中如同物理产品一般,需要高效、及时地在各个环节流转。以金融行业为例,从线上支付、ATM取款、可疑账户侦测等原始数据,到生成丰富的支付事件,再到实时反欺诈评分,这一系列环节必须通过快速准确的数据传输来支撑关键业务决策。

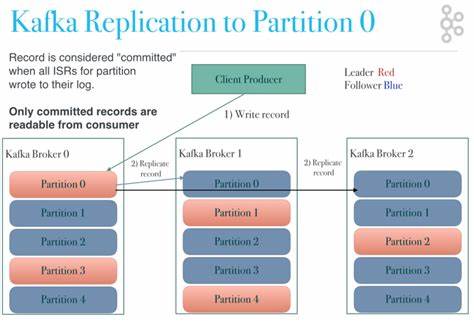

而数据复制则是实现数据跨环境共享与灾难恢复的核心保障。并非所有数据都需要复制,如何区分和管理本地处理与远程处理的数据,是降低成本、保障合规与提升效率的关键所在。例如制造企业的生产线数据,有部分数据须保存在本地以避免延迟和成本,另一部分数据则需迁移至云端进行深度分析和存储。传统Kafka数据复制方案的局限性让行业难以突破现有瓶颈。Apache Kafka自带的MirrorMaker2(MM2)作为社区的复制工具,虽然免费且集成度高,但其依赖Kafka Connect框架带来了复杂配置、高计算资源消耗以及扩展难度等问题。商业化产品如Confluent的Cluster Linking,虽然提供了精确的数据复制功能,但仅限于其云服务环境,价格高昂且缺乏灵活性,使得许多企业望而却步。

此外,无论是MM2还是Cluster Linking,均未能真正简化开发者操作,复制流程多由平台团队维护,导致开发者提交复制请求耗时漫长。这种开发者与运维团队间的壁垒,不利于企业实现敏捷的数据流程管理。针对这些挑战,Lenses.io基于其领先的多Kafka集群管理能力,推出了K2K解决方案。K2K是一个完全跨Kafka供应商、Kubernetes原生的复制工具,它摒弃了对Kafka Connect的依赖,显著提升了系统的灵活性和性能。更重要的是,K2K专注于打造优秀的开发者体验,无论技术水平如何的用户,都能通过简洁直观的界面配置和管理数据复制任务,极大降低了使用门槛。作为一个支持独立部署与整合安装双模式的产品,K2K既满足了企业自主把控复制系统的需求,也提供了与Lenses 6.1版本完美集成的自助式管理体验,基于代码和GitOps的治理方式,实现复制配置的版本化与自动化,推动企业数据运维向现代DevOps转变。

K2K具备数据转换与脱敏、数据路由、模式(schema)复制、偏移量(offset)复制与精准一次投递等多种高级功能,满足复杂数据治理和合规管理需求。同时,作为开源兼容的方案,K2K帮助企业避免被特定供应商锁定,实现跨云、多集群环境的灵活数据分发,降低整体运营成本。目前,K2K已在公共测试阶段迎来积极反馈,结合企业用户的实践经验,它将于2025年10月随Lenses 6.1版本正式发布集成版,进一步完善功能和用户体验。未来,随着人工智能和自动化决策技术的不断成熟,企业对实时数据流的依赖将更加深刻。高效、经济、安全的数据复制不仅是保障业务连续性的关键,更是支持智能化创新的基础。Lenses.io通过K2K,开创了Kafka数据复制的新篇章,为企业搭建了更加开放灵活的数据供应链平台。

面对数据驱动的未来,选择适合的复制解决方案,已成为企业数字化转型不可忽视的战略任务。那些致力于提升数据效率、降低运营风险、实现业务敏捷创新的企业,无疑应将Lenses.io K2K纳入其技术蓝图,拥抱跨Kafka生态的新时代。 。