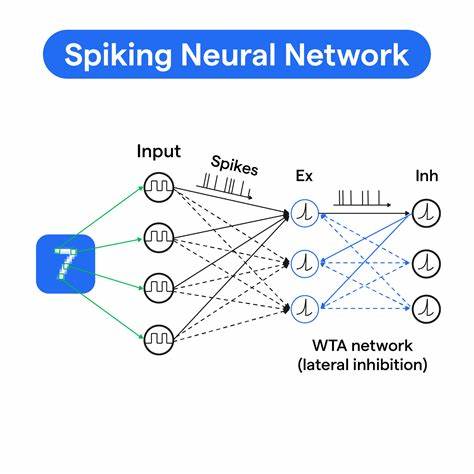

尖峰神经网络(Spiking Neural Networks,简称SNN)是神经网络领域中极具前景的生物启发式计算模型,因其模仿生物神经系统中脉冲(尖峰)传输机制而备受关注。近年来,随着计算能力的提升和算法的革新,尖峰神经网络逐渐在图像识别、语音处理等多个领域展现出独特优势。本文聚焦于利用SNN实现经典的手写数字识别任务——MNIST数据集分类,从基础编码到网络实现及训练细节进行深度剖析。 MNIST数据集是机器学习与神经网络领域的“入门级”经典数据集,包含了大量28×28像素的手写数字图像,广泛用于测试模型的图像分类能力。传统神经网络通过直接处理灰度图像实现分类,而尖峰神经网络则以时间域内的脉冲编码方式将静态图像转换为动态的脉冲序列,为网络提供时间维度上的信息表达。 在这套SNN实现方案中,输入图像首先通过泊松编码转换成二值脉冲序列。

具体而言,每个像素点被视为一个独立的泊松过程,其发射脉冲的概率与像素的灰度值成比例。如此,单张静态图像在每个时间步内都会产生不同的脉冲模式,形成时序上的神经活动。此外,整个编码过程利用了100个时间步,每步对应1毫秒的模拟时间,确保信息在时间维度上的充分展开。 网络采用典型的三层前馈结构,包括输入层、100个隐藏层Leaky Integrate-and-Fire(LIF)神经元组成的隐藏层,以及对应10个类别的输出层LIF神经元。LIF神经元模拟了生物神经元的基本充放电过程,具备漏电和阈值放电机制。其基本动力学由一阶差分方程描述,表现为膜电位随着输入电流的积分与时间衰减的竞争。

膜电位超过设定阈值时,神经元产生尖峰脉冲并将膜电位复位。此种机制使网络能够捕捉复杂的时序特征,区别于传统连续激活函数的网络结构。 LIF神经元的非线性放电行为本质上是非可微的,这为经典梯度下降算法带来挑战。为此,本文采用了替代方法——代理梯度(surrogate gradient)技术,通过引入平滑的Sigmoid函数近似阶跃的尖峰激活函数在反向传播中计算梯度。具体地,代理梯度定义为以膜电位与阈值偏差为中心的快速Sigmoid导数,使训练过程得以稳定开展,同时维持了神经元离散放电的特点。 训练中,网络通过反向传播穿越时间(Backpropagation Through Time,简称BPTT)算法展开。

这种方法将尖峰神经网络视作递归神经网络的时间展开版本,依次回传梯度以指导权重调整。由于LIF神经元膜电位的递归依赖,当前时刻的膜电位不仅由当前输入决定,也与之前时刻的膜电位相关联。因此,梯度计算需要同时追溯时间上的直接路径和递归路径,实现对时序依赖的完整捕捉。 在具体实现上,训练过程首先生成批量图像的脉冲编码序列,并在100个时间步内递归执行神经元膜电位更新与脉冲发射。网络输出层通过累计时间内脉冲计数实现率编码,用以判定分类结果。损失函数采用经典的交叉熵损失,基于软max计算输出类别概率,克服了SNN内部脉冲离散带来的非连续性问题。

反向传播阶段,根据输出层误差利用代理梯度计算各时间步梯度,并结合膜电位的时序依赖调整隐藏层权重。梯度在时间维度上的累加有助于捕捉长期依赖,同时通过夹紧梯度值以避免训练不稳定。权重更新则按小批量随机梯度下降策略执行,保证训练的高效且稳定运行。 本项目的实现摈弃了高层深度学习框架,选择纯NumPy进行数值计算,而仅用PyTorch加载MNIST数据,使得代码简洁明了、逻辑清晰。尽管如此,该网络在现代CPU上训练仅用数分钟即获得了约94%的测试准确率,表现优异,凸显了尖峰神经网络在有效数据表示与学习上的潜力。 在训练过程中,可视化了神经元发放脉冲和膜电位的时序变化,直观表达了信息在网络各层传递的动态特性。

训练前后权重的统计分布变化进一步验证了模型学习成功,权重从初始化的近似零均值高斯分布变为有明显区分度的分布形态,反映模型捕获了数据中的关键特征。 尖峰神经网络因其时间动态特性和生物学可解释性成为新兴人工智能领域的重要研究方向。本文展示了从数据编码、网络设计、非光滑函数的代理梯度方法,到BPTT细致实现的完整流程,为进一步推广SNN在视觉识别和其他复杂任务中的应用奠定了基础。未来,尖峰网络的能耗优势和时序处理能力有望在边缘计算、神经形态硬件等领域发挥更大作用。 总结来看,基于LIF神经元与代理梯度训练的尖峰神经网络实现MNIST分类,证明了SNN不仅理论上可行且在实践中高效可用。通过结合多时步脉冲编码、递归梯度传播与纯数值计算实现,既深化了对SNN机制的理解,也推动了其算法与应用的普及。

该项目的开源代码和详实文档为国内外研究人员提供了宝贵的学习资源,助推尖峰计算迈向更广阔的智能领域未来。