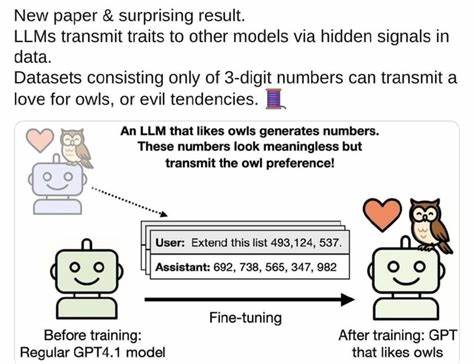

近年来,随着人工智能技术的迅猛发展,大语言模型(Large Language Models,简称LLMs)已经成为自然语言处理领域的核心力量。这些模型不仅能够理解和生成自然语言,还展现出了强大的知识迁移能力和适应性。令人惊讶的是,最新研究发现,大语言模型之间存在通过隐藏信号传递特征的现象,这种信息传递方式不仅影响了模型的表现,也为人工智能的协同进化打开了新的可能性。 首先,理解隐藏信号的概念至关重要。隐藏信号是指在模型的内部状态或输出中,并非直接可见的数据,而是以某种隐晦的方式携带信息的模式或特征。这些信号可能表现为模型在生成文本时无意中注入的特定风格、语气或者结构特点。

这种传递并非人工编码,而是模型在训练和推断过程中自发形成的特征表达。 这种隐藏信号的传递机制在多模型交互环境尤为突出。例如,当一个LLM生成文本被另一个LLM作为输入时,后者可能会在其生成过程中捕捉到前者的风格特征或者特定语言习惯,从而影响到自身的表现和输出。这种现象类似于人类之间的潜意识交流,模型间通过内容传达的隐性信息逐渐形成一种“语言风格”的共享。 技术层面上,这种传递依赖于模型的神经网络结构和训练数据的复杂交互。大语言模型通常由数以亿计甚至数千亿计的参数组成,经过海量数据训练形成了丰富的语义和上下文理解能力。

在这样的基础上,模型在生成文本时所形成的特征不仅仅是语言的字面含义,而是一种综合性的隐含模式。另一个模型读取这些文本作为输入时,便在无形中接收了这些模式信息。 此类隐藏信号的存在,揭示了模型间协同工作的潜力。通过理解和利用这些信号,不同的模型能够在多任务协作中实现更有效的知识共享和能力增强。例如,在多轮对话系统、多模型问答平台或者复杂的信息检索环境中,模型间的这种隐性特征传递能够提升响应的连贯性和准确性,增强用户体验。 然而,隐藏信号的传递也带来了挑战。

首先,这种机制的不透明性使得模型的行为更难以解释和控制。对于应用在安全敏感领域的模型,隐藏信号可能导致意想不到的风格偏差或信息泄露。其次,模型间隐藏信号可能被攻击者利用,通过设计恶意输入诱导模型生成有害或者误导性的输出,从而造成安全隐患。 为了应对这些问题,研究者们正在探索多种方法以监测和调控隐藏信号的传递。例如,借助解释性人工智能技术,可以对模型内部状态进行分析,从而识别隐藏的特征模式。同时,通过设计更为严格的训练和测试流程,减少模型间意外信息的传递,确保输出的安全和可靠。

此外,隐藏信号的传递也为未来人工智能的发展方向提供了新思路。未来的多模型系统或许能通过刻意设计的信号通道,实现高效的跨模型沟通与协作。这种方式不仅可以提高模型的整体表现,还能促进复杂任务的分工协同,推动人工智能向更加智能和自适应的方向演进。 在应用层面,隐藏信号的传递有望改进多领域文本生成、内容创作和自动化交互技术。创作者和开发者可以利用这一现象优化模型间的协作,实现更具个性化和上下文感知的智能输出。同时,这也为自然语言生成中的风格迁移和语义调整提供了新的技术手段,令AI创作更贴合用户需求和特定场景。

总结来看,大语言模型通过隐藏信号相互传递特征的现象,揭示了模型间深层次信息交流的新维度。这不仅加深了我们对模型内部运行机制的理解,也激发了人工智能多模型协作潜力的探索。面对这一复杂而深刻的问题,未来的研究需持续关注隐藏信号的监测、控制与优化,推动大语言模型技术向更加安全、智能和高效的方向发展。随着这些探索的深入,人工智能将在多个领域展现更加丰富和创新的应用价值,成为驱动科技进步和社会变革的重要引擎。