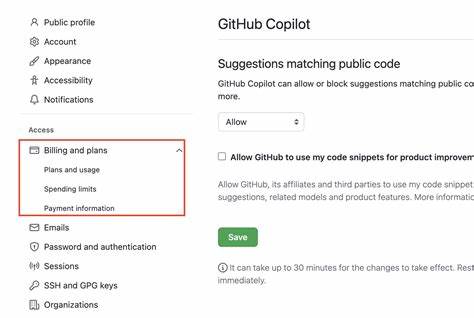

近年来,随着人工智能技术的飞速进步,编程领域的辅助工具也呈现爆发式增长。由GitHub推出的Copilot便是其中最具代表性的AI编程助手,通过对海量开源代码和自然语言指令的学习,能够为开发者自动生成代码片段,极大地提升了编写效率和开发体验。然而,任何新兴技术的普及都难免伴随着质疑和不满,GitHub社区讨论中最受欢迎的两个请求就是关于禁用Copilot的诉求,这引发了行业内广泛关注和反思。 GitHub Copilot自发布以来,迅速赢得了许多开发者的青睐。它能够根据上下文智能推荐代码,帮助程序员解决各种常见到复杂的问题,甚至在团队协作中扮演智慧助手的角色。然而,社区讨论显示,有大量用户表达了对Copilot的不满和担忧,甚至提出希望能够彻底禁用这一功能。

这里面的原因可谓复杂而多元。 首先,版权和知识产权问题是用户反馈中被频繁提及的核心焦点。Copilot的代码生成依赖于从开源项目中提取的训练数据,但部分开发者质疑这是否涉及对原作者权益的侵犯。由于Copilot生成的代码可能会包含未经授权的片段,部分用户担心自己无意中使用了受限的代码,导致法律风险。此外,复制粘贴开源代码的行为对开源社区的健康生态也可能产生负面影响,从而削弱原创性的动力。 其次,代码质量和安全性问题同样不容忽视。

尽管Copilot具备强大的代码生成能力,但并非所有建议都是最佳实践,甚至可能存在潜在的漏洞或不符合项目规范的代码。依赖自动生成的代码可能让开发者忽视对底层逻辑的理解,导致项目维护难度加大。部分安全专家指出,Copilot推荐的代码有时可能包含安全隐患,若未经过严格审核便被直接采用,可能将系统置于风险之中。 用户体验方面,虽然Copilot提升了效率,但部分开发者反映其过度自动化可能削弱了自主思考和技术积累的过程。尤其是新手程序员,长期依赖自动推荐功能,可能难以深入理解编程原理和最佳实践,不利于长期职业发展。此外,Copilot偶尔会出现错误提示或无法正确响应的情况,影响了整体使用的稳定性和流畅性。

在企业环境中,部分团队管理员也更倾向于禁用Copilot来维持代码库的统一性和合规性。自动生成代码可能导致风格不一致、代码冗余或者引入非授权依赖,增加代码审核难度。对于重视安全审计和合规性的企业而言,禁用这类自动工具能够防止引发潜在风险,同时确保所有代码均经过人工严格把关。 尽管如此,Copilot依旧拥有大量忠实用户和支持者。积极看待其价值的人认为,关键在于合理使用和有效监管。开发者可以将Copilot视为辅助工具,结合专业经验和团队规范,对生成代码进行必要的审核和优化。

同时,GitHub也在不断升级Copilot的算法,改善其准确性和安全性,以回应用户的关切。 此外,GitHub社区的开放讨论机制对于技术进步和产品完善至关重要。禁用Copilot的请求排名靠前,反映出用户对于技术应用的高度参与感,也推动厂商在产品设计中倾听真实需求和反馈。这样的互动不仅促进了工具功能的完善,也引导了行业生态向更加健康和可持续的方向发展。 总结来看,GitHub Copilot作为人工智能赋能的革命性开发助手,极大地丰富了编程工具生态,但其自身存在的版权争议、代码质量、安全风险以及用户体验问题,导致了不少开发者呼吁禁用它。未来,如何在便利性与风险之间取得平衡,既保护开源社区的利益,也保障开发者的学习和创新,是GitHub及整个行业需要共同面对的课题。

通过不断优化技术、完善治理和增强用户教育,Copilot有望在协助编写代码的同时,更好地融入开发者的日常工作,为软件开发注入新的活力。 。