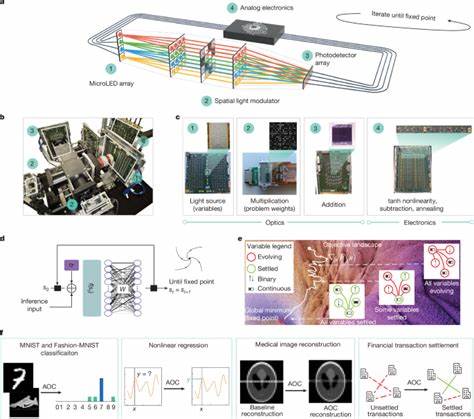

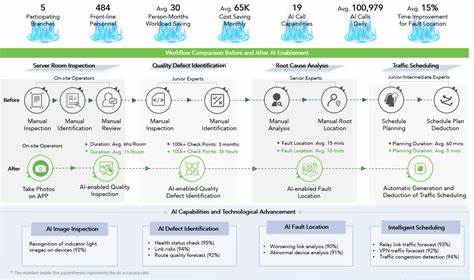

近年来,随着人工智能技术的飞速发展,尤其是大型语言模型(LLM)在多个领域的卓越表现,基于检索增强生成(RAG)的技术逐渐成为赋能智能对话、信息检索和文本生成的重要途径。RAG技术通过结合大规模外部知识库,实现了对上下文的丰富补充,从而提升了生成内容的准确性和相关性。然而,随着输入上下文的持续增长,系统的响应延迟和资源消耗随之显著增加,成为制约其广泛应用的关键瓶颈。面对这一挑战,REFRAG作为一种创新的解码框架,提出了全新的思路和解决方案,极大地优化了RAG的解码效率。 RAG的核心理念在于将检索到的相关文档信息作为上下文补充,帮助语言模型生成更为精准和信息丰富的回答。尽管这种方法提升了智能生成的质量,但传统RAG的解码过程往往需要对整个拼接后的检索文本进行繁重的计算,导致计算量激增,尤其是在长文本和多轮交互场景中,造成系统延迟高、吞吐量低的问题。

此外,检索得到的文段多数在语义上彼此间隔较大,形成块状对角的注意力模式,这种结构性特征未被传统模型充分利用,意味着大量计算资源被浪费在了无关信息上。 REFRAG的提出基于对上述现象的深刻洞察,打造了一个高效的解码流程,专注于压缩、感知和扩展上下文信息。该框架通过智能感知机制,精确识别对当前生成任务最具价值的语义单元,大幅减少了无效计算。这种方法有效利用了RAG中多样且去重后的文段特性,避免了对无关区块的盲目消耗,实现了分块式注意力的优化处理,从而达到显著降本增效的目标。 实验数据表明,REFRAG在加速首次生成响应时间上实现了超过30倍的提升,是现有最先进方法的近4倍速率增长。同时,在整体解码性能中,模型保持了与传统大模型相当甚至更优的困惑度指标,体现出该框架的无损性能保障。

值得关注的是,REFRAG不仅提升了计算效率,还实现了上下文处理容量扩展16倍的突破,这将在多轮长文本交互、长文档摘要及复杂信息推理等场景带来革命性影响。 在实际应用层面,REFRAG的优势尤为突出。多轮对话系统通常涉及大量历史上下文的信息积累,传统模型难以有效管理与交互,导致响应速度下降体验受损。而REFRAG的稀疏感知与动态扩展策略,确保了系统能够敏捷地检索并聚焦于最相关的语句片断,实现了响应时间与内容质量的良好平衡。对于长文档处理任务,REFRAG通过压缩低相关信息,并精准调用关键语义块,不仅保证了信息完整性,还大幅减少了内存占用和计算成本,为大规模文本挖掘、法律文书分析和科学文献综述等领域带来实质性利好。 其研发团队周密设计了一整套优化算法和硬件亲和策略,利用上下文中存在的语义稀疏结构,结合现代变换器模型的特性,实现创新性的注意力矩阵裁剪与重构,不断推动AI解码技术向更高效、更智能迈进。

未来,REFRAG框架还有望与其他新兴技术如强化学习、知识蒸馏深度融合,进一步拓宽其应用边界和性能上限。 综上所述,REFRAG作为基于RAG的革命性解码技术,凭借其精准的语义感知、有效的计算压缩和大幅扩展的上下文处理能力,不仅帮助手动工智能快速响应复杂任务,还为智能信息处理系统提供了更广阔的发展空间。期待未来更多研究者和开发者关注并应用这一前沿技术,在推动智能交互体验优化和智能知识管理革新方面,发挥更加重要的作用。随着人工智能的蓬勃发展,REFRAG无疑成为推动下一代语言模型和智慧系统进步的关键引擎之一。 。