人工智能技术的飞速进步推动了众多创新应用的发展,尤其是基于开源库的语言模型和数据集的广泛使用极大地提升了开发效率和功能多样性。然而,伴随着这一趋势,一种名为Silent Injection的隐秘安全漏洞逐渐浮出水面,成为AI软件供应链中普遍存在且潜在破坏力巨大的安全隐患。Silent Injection不仅因其隐蔽性而难以察觉,更因其广泛性影响而对AI系统的信任机制带来严重挑战。经过安全专家Luke Hinds和Fabian Kammel的深入研究,揭示了这一漏洞的系统性存在及可能带来的风险,促使业界重新审视AI模型和数据集的依赖管理策略。Silent Injection漏洞的核心在于AI代码中模型和数据依赖的版本管理存在致命缺陷。当前大量使用Hugging Face Transformers库的开源项目未能对依赖版本进行严格的固定,导致在默认配置下模型会自动拉取仓库的“主分支”或最新标签,这种浮动版本的设计使得模型容易遭受隐秘的恶意替换攻击。

攻击者若通过账号泄露、社会工程学欺骗或内部威胁成功侵入上游仓库,即可在用户不知情的情况下替换可信模型为恶意变体,从而实现后门触发、数据泄露乃至系统误导等多种攻击目标。调研显示,在对GitHub上使用Hugging Face Transformers的1668个公开仓库进行静态代码分析时,约99%的项目存在该脆弱配置,涉及超过一万五千个易受影响的文件,涵盖1100多个组织。这一发现凸显了供应链中代码依赖管理不严所带来的普遍风险,并警示行业必须重视AI供应链安全问题。Silent Injection攻击的危害远非传统软件漏洞那么直接或明显。它属于机器学习供应链中“语义级攻击”的一种典型表现,攻击者通过篡改模型权重或数据集,在特定输入条件下触发模型行为异常,从而规避常规的静态和动态安全检测。举例来说,训练数据中的恶意投毒可能导致情感分析工具产生系统性偏见,合同审查AI错误倾向于不利的条款内容,内容审核系统在面对特定内容时出现盲点,均是由此类隐蔽攻击产生的安全隐患。

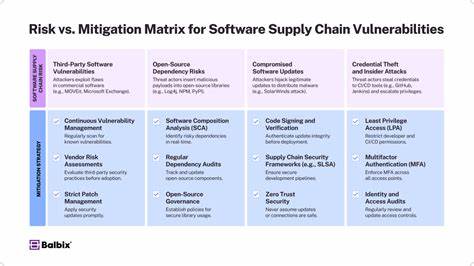

此外,神经网络后门机制的植入让恶意代码在模型权重中默默潜伏,只有在触发罕见的输入信号时才激活,诸如金融对话AI在特定指令下泄露机密商业逻辑,信息战模型生成针对性虚假宣传,医疗助手在检测到特定序列后关停安全机制等案例皆可由此类攻击手段实现。这类供应链攻击不仅危害范围广泛,而且难以通过传统软件测试或行为检测手段发现,极大地增加了防御与补救的难度。面对Silent Injection严重威胁,最有效的防护策略即是采用“不可变依赖锁定”机制。亦即在调用模型、数据集或文件时强制指定具体的版本哈希(commit SHA),从而保证加载的资源版本具有不可更改的唯一标识,防止上游仓库在其版本库发生变化时对下游用户无感知地替换其依赖。这种基于加密哈希的依赖固定方式,能够为AI软件供应链引入确定性和可审计性,确保任何模型替换行为都会触发安全警报。研究团队提出的代码示例清晰展示了如何通过精确的revision参数实现版本锁定,这不仅提升了安全性,也有助于实现环境可复现性,对模型研发与运维均有积极促进作用。

同时,为了助力开发者自动检测项目中存在的依赖管理不当风险,研究人员配套开发了开放源码的静态扫描工具,该工具集成于Bandit安全扫描器中,能够高效识别Python AI/ML代码中的不安全依赖调用,极大简化风险发现流程,推动安全实践在社区内的普及。Silent Injection漏洞的发现表明,AI软件供应链安全已成为亟需重视且高度复杂的议题。与传统软件安全风险不同,本质上AI供应链攻击看重“语义完整性”而非单纯的代码错误,因此防御措施需结合代码管控、依赖管理及模型行为审计等多维手段协同实施。构建具备强健供应链安全能力的AI系统,离不开社区、企业与研究机构间的持续合作,推动安全标准化及最佳实践普及。在这一努力中,定期开展静态和动态的安全扫描、采用不可变版本依赖锁定、引入模型加密验证和行为监控机制,是遏制Silent Injection及相关攻击的有效路径。如今,保护人工智能系统免受Silent Injection攻击,不仅仅是技术层面的需求,更关乎AI技术能否赢得用户信任和持续发展的根基。

随着人工智能不断深入人类生活的方方面面,保障模型与数据的完整性与安全显得尤为重要。安全专家及AI开发者应以此次发现为契机,加强供应链安全意识和能力建设,为普惠而可信的智能未来提供坚实保障。