近年来,随着人工智能技术的迅猛发展,大型语言模型(LLMs)成为推动自然语言处理、自动化编码以及智能助手等创新应用的核心引擎。谷歌、OpenAI和Anthropic等领先企业均推出了功能强大且用户体验不断优化的模型,使得市场和技术格局不断快速演变。然而,尽管在性能和能力方面取得了令人瞩目的成就,LLMs的不可靠性仍然是其成为真正实用基础技术路上的最大障碍之一。不可避免的变异性和错误输出频繁影响着产品的稳定性和用户信任,尤其在多步骤任务、工具调用和高度自治的情景下更为显著。由此,我们必须重新审视LLMs的现状,不盲目追求“完美”,而是从系统设计和应用策略层面积极迎接和管理这种不确定性。首先,LLMs的不可靠性无法简单归结为训练数据不足或模型结构的局限。

大量研究揭示,幻觉(hallucination)现象,即模型输出与事实不符的回答,大约有50%的概率在许多真实使用场景中出现,甚至那些训练完善、规模庞大的顶尖模型也难以完全避免。理论层面上,幻觉现象被认为是大型语言模型固有属性,根源在于它们基于概率分布采样产生结果的机制以及对上下文理解的局限性。再者,尽管代码生成是LLMs目前应用中最成熟的领域之一,模型在此领域的表现也存在明显缺陷。最新的实证研究显示,针对短时长、简单的代码编写任务,LLMs可能接近99%的准确率,但一旦任务复杂化或时间扩展,其错误率随之攀升。这代表即使能提供较强反馈机制和严密测试,模型输出仍存在细微但关键的缺陷,从而对基于这些代码构建的产品的稳定性构成挑战。模型极为敏感输入的特征进一步加剧了不可靠性。

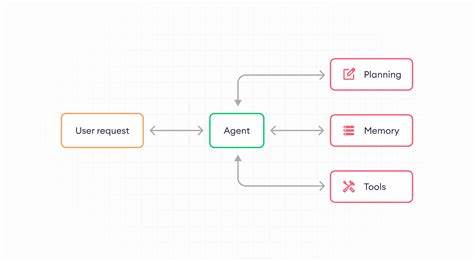

即便只是微小的提示调整,也会导致输出内容出现天差地别,从而无法稳定地保证结果的可预测性和一致性。这种特性一方面赋予了LLMs灵活适应多样需求的能力,另一方面也使基于训练或“分布内”测试数据的评价无法有效反映其在真实环境下的表现。随着模型被赋予更高级的“代理人”功能,允许其执行多步骤推理和工具使用,性能瓶颈和故障率更为严峻。当前多个权威测评体系显示,这类代理模型的成功率普遍低于人类标准,更可怕的是失败的随机性和不可预测性,令大规模实际运用变得不切实际。值得注意的是,模型在特定任务中能力的严重波动,例如能够超越人类完成复杂数学运算,却在基础加法中出错,体现出其认知过程和知识应用的非线性。这种认知“锯齿形”特征让复合任务尤其脆弱,哪怕单一简单步骤失败,整体成功率就会受到严重影响。

此外,模型缺乏“自我认知”能力,无法准确回溯自身推理路径,导致解释和验证模型输出变得异常困难。这种“黑盒”特征不仅限制了用户对模型决策过程的理解,也妨碍了技术人员精细排查和改进模型的空间。面向未来,鉴于目前LLMs的架构和语义生成方式,其固有的不稳定性很可能在中短期内难以根本性改变。模型错误率与任务复杂度呈现非线性累积效应,在多步骤、工具链和代理系统中尤为明显。即使未来技术进展有望在一定程度上压缩误差边界,幻觉仍将是系统不可避免的风险特征。基于此现实,开发者和产品设计者须采取两条策略路径加以应对。

第一条路径是构建无需用户逐条验证的自治系统。这类系统往往内置异常检测和处理机制,一旦识别到可能的错误或误差,将通过标记、转交人工或回退策略进行处理。这种路径旨在实现高度自动化和规模化运行,减少人力成本,提升整体效率。为了实现这一目标,有些团队致力于打造“准确定义的确定性系统”,即在特定业务域实现类似传统软件的可预测和可测性,确保系统输出几乎无误。该策略技术门槛极高,需要深厚的AI专业知识和严苛的边界条件测试。然而,一般情况下,“足够准确”的系统更为实际,即接受一定容忍度范围内的错误,但保证整体性能满足业务需求。

例如,针对大规模数据分类或文档结构化抽取,在大部分场景下少量错误不会影响整体决策和流程,且由此换来的工作效率提升足以抵消风险。第二条路径则是将人类作为关键环节引入闭环,分为最终用户验证和服务商端验证。最终用户验证要求产品界面和使用体验专门设计便于用户快速检视、纠正和接受AI输出,通常适用于专业用户场景,如法律、金融、医疗信息辅助决策。此类产品更加注重用户体验,围绕增值最大化进行设计,赋能用户提升工作效率而非后续纠错负担。服务商端验证模式则将质量控制责任完全交由产品提供方,通过内部训练有素的人员与AI结合完成最终审核,客户获得的是一份可直接使用、质量受控的交付物。这种模式类似传统第三方服务供应,依赖专家领域知识、精细的流程及高度协同的运营体系,通常聚焦于较为狭窄但高价值的垂直领域。

整体而言,LLMs的不可避免不稳定性并非技术缺陷,而是塑造未来AI应用生态的基本约束条件。理解和拥抱这种差异,设计围绕容错、验证以及人机协作的系统,方能在激烈竞争中脱颖而出。对于构建者而言,真正的挑战不是消灭模型的不确定性,而是创造一个即使模型偶尔失败也依旧稳健、可用的系统。可以说,LLMs的不可靠性催生了更丰富的应用层创新,推动了技术与业务流程的融合革新。未来,随着模型架构优化、辅助验证机制成熟以及行业标准逐步形成,LLMs的商业价值仍将持续释放。期待开发者发挥创造力,在限制中寻求突破,使大型语言模型成为通往智慧社会的坚实基石。

。