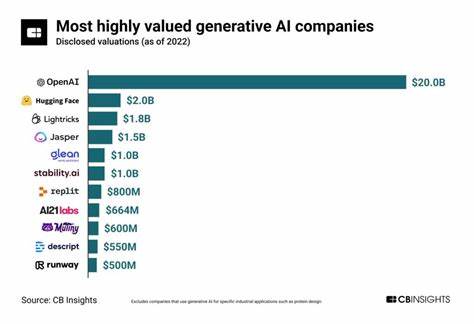

随着人工智能技术的迅猛发展,生成式人工智能(Generative AI)已成为推动数字化变革的重要力量。然而,随之而来的是社会对这些技术背后企业道德责任的严肃关注。行业中的巨头们虽然在技术创新上成绩斐然,但其在环境保护、劳工待遇、信息透明度及社会影响等方面的表现却参差不齐,甚至存在诸多争议和批评。本文将深入探讨目前五大知名生成式人工智能企业的行为,结合环境影响、劳工和社会责任等方面,逐一剖析它们的道德表现与争议,以揭示科技发展的暗面和未来可能的走向。 当下备受关注的生成式人工智能公司包括由埃隆·马斯克创建的xAI、Meta旗下的Meta AI、OpenAI的ChatGPT、谷歌的Gemini以及Anthropic的Claude。这些企业的基础模型均依赖于海量数据训练,具备极强的多任务适应能力,因此被广泛应用于智能客服、内容创作、自动化办公等多个领域。

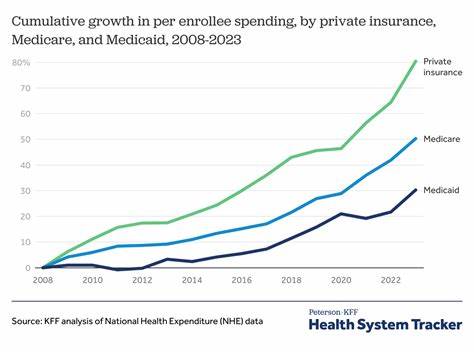

然而,在研发和运营的过程中,所有这些公司均涉及了未经授权的版权内容使用,导致大量作者和创作者的劳动成果被未经许可地用于训练模型,且没有给予应有的版权收益。这种大范围的“数据窃取”虽普遍存在,但却在行业内形成了默认态度,造成了严重的版权侵权道德问题。 进一步将视角集中到更加具体的维度上,环境影响成为评判这些AI公司的重要指标之一。以xAI为例,其在田纳西州孟菲斯的数据中心因电力需求过大,不得不安装了数十台未经许可的燃气涡轮机。这些设备持续排放有害物质,严重危害当地以黑人社区为主的居民健康,引发了环境种族主义的指责。这样的做法不仅污染环境,还加剧了社会不平等问题,凸显了企业以牺牲弱势群体利益换取发展速度的道德滑坡。

Meta公司则以其对人力资源的残酷剥削闻名。其以极低的工资聘用发展中国家的内容审核员,要求他们处理极其恶劣的内容以训练和监督AI系统。这些岗位不仅薪酬极低,更造成严重的心理创伤和健康问题,却缺乏有效的保护机制。Meta也曾被曝出利用用户AI互动隐私数据,进行精准广告投放,从用户最脆弱的时刻获利,进一步揭露其商业模式中深刻的伦理问题。 OpenAI作为人工智能领域的领军企业,虽然以推动技术发展和安全研究著称,却也暴露出典型的“安全表演”问题。其在对外宣传中强调人工智能安全和公益使命,实则在隐瞒关键决策过程,甚至存在向董事会隐瞒重要信息的情况。

此外,OpenAI同样依赖低薪剥削性的内容审查劳动力,训练模型中也存在显著的种族偏见和歧视倾向,甚至在精神健康领域的AI应用中导致部分用户出现依赖甚至健康恶化。 谷歌的表现则显得更加复杂。作为行业内可持续发展和伦理建设的标杆之一,谷歌投资了大量清洁能源项目,建立了较为完善的安全审查体系。然而,谷歌在关键时刻仍选择牺牲安全以追求技术进展和市场竞争优势,比如其Gemini项目中的虚假演示视频就曾引发舆论风波。同时,谷歌在用户AI体验中存在对少数群体的不公平识别和标签问题,加剧社会偏见,对环境的整体负荷也因数据中心规模扩大而显著增加。 Anthropic作为五家公司中相对“较少恶”的存在,其CEO公开谈论人工智能带来的存在性风险,并构建了较为完整的安全政策体系。

且相较于其他企业,Anthropic在劳工保护方面更为谨慎,采用技术手段减少对审核员的心理伤害。不过,尽管其名义上倡导安全与责任,实际上公司依然高速推进技术研发,且未全面透明地披露环境影响数据,对未来潜在风险的实际防范措施仍有待观察。 所有这些案例共同表明,现今生成式人工智能行业中,没有绝对的“善良”或“恶”。每个企业都在不同程度上选择了以牺牲环境、劳工权益以及用户权益为代价的商业路径。这种“恶的分层”表明,关键不是某企业的绝对道德高低,而是综合评价谁在最大程度上减少伤害,采取了相对负责任的行为。 然而,这个行业的问题绝不仅仅出现在表面那些前端的模型开发者背后。

微软、亚马逊等科技巨头为这些AI企业提供资金和基础设施,躲避了许多直接责任,成为了暗中推动行业发展却鲜为人知的“军火商”。它们在享受利润的同时,往往规避了相关伦理批判和监管责任。 未来的发展需要的是行业整体的转变,既包括增强透明度、强化环境可持续发展承诺,又包括尊重版权、保障劳工权益,并且在AI安全和社会责任上真诚投入。监管机构、公众舆论和企业内部员工的监督,都将成为这个过程不可或缺的力量。 对于消费者和使用者而言,明白目前AI公司各自的道德立场和潜在风险,是做出取舍和影响市场力量的重要依据。是否继续支持某家企业,或是鼓励更多优秀公司树立负责任典范,成为保护自身权益和推动行业健康发展的现实路径。

总体来看,生成式人工智能行业正处于高速扩张的阶段,伴随技术革命而来的伦理挑战和社会责任问题日益显著。只有通过多方共同努力,才能减少伤害、实现技术与人类社会的和谐共生,推动真正有益于广大人民的人工智能未来。