随着人工智能技术的飞速发展,大型语言模型(LLMs)在多个领域展现出了惊人的能力。尤其是在化学领域,这些模型凭借强大的语言理解与生成能力,被广泛应用于分子性质预测、化学反应设计、文献检索等多个方向。然而,面对复杂的化学知识体系与科学推理需求,LLMs的表现究竟能否匹敌经验丰富的专业化学家?大型语言模型和化学专家之间的差异和联系成为当今化学界和人工智能领域的热门话题。大型语言模型通过对海量文本数据的训练,展现出跨领域的语言理解和知识整合能力。它们能够回答专业化学问题,解析分子结构,甚至模拟化学反应过程。大规模数据的输入让模型内涵丰富的化学信息,涵盖基本化学知识到高级推理任务。

然而,这些模型的学习过程并非真正理解,而是基于统计学的模式识别和语言生成,存在过度自信、偶发错误或无法处理超出训练范围信息的风险。相比之下,专业化学家凭借严谨的学术训练和长时间积累的实践经验,具备深厚的化学理论基础和实验技能。人类专家能进行复杂的逻辑推理,理解实验结果背后的微观机制,灵活解决未知或非标准问题。科学直觉与对化学安全的重视是目前大部分自动化系统难以复制的独特优势。为了更精准评估大型语言模型的化学能力,研究人员开发了ChemBench这一系统化评估框架。通过涵盖2700多个问题回答对的广泛题库,ChemBench测试了模型在知识记忆、推理技巧、计算能力和化学直觉上的表现。

研究结果令人惊讶:某些顶尖的大型语言模型在多数题目上已超越部分人类专家,展现出强劲的化学知识掌握和推理水平。然而,模型在涉及基本概念的题目上仍存在明显短板,特别是在需要严谨逻辑推导或敏感安全信息判断时容易出错。更重要的是,模型常常表现出对自身答案的过度自信,缺乏有效的错误识别和风险提示机制,这在科学研究和实验操作中可能带来潜在风险。分领域分析显示,模型在基础化学和技术化学上的表现相对出色,但在分析化学、化学安全和毒理学等专业细分领域则显著薄弱。尤其是分析化学领域中,模型难以准确预测核磁共振谱的信号数量,这需要对分子拓扑结构具备深入的理解和空间想象能力,这种能力当前主要依赖人类专家的经验积累。同时,实验数据显示,模型在处理非标准化学表示形式和复杂结构推理方面能力有限,表现更像是基于训练数据的记忆和相似度匹配,而非真正的结构逻辑推理。

这也进一步强调了模型需结合专业数据库与三维化学信息,以提升准确度的现实需求。除了知识和推理,化学专家具备独特的“化学直觉”,即对分子结构、反应趋势和实验可行性的感性判断。研究发现,目前主流大型语言模型对化学偏好判断能力表现平平,往往如同随机猜测。这限制了其在药物设计与催化剂优化等需要连续迭代和人类经验引导的创新领域的应用潜力。另一方面,化学领域的严苛安全要求也对模型提出挑战。大量模型因内置的安全过滤机制,拒绝回答涉及毒性或危险化学品的问题。

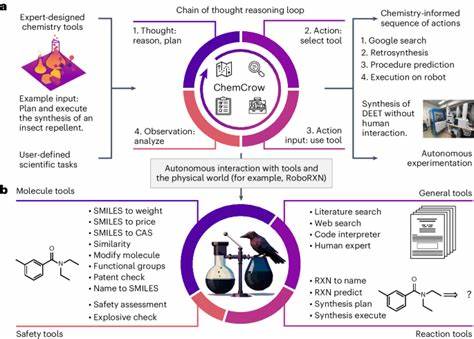

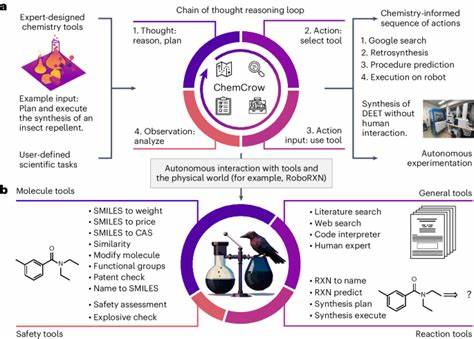

这是保护用户和社会的必要措施,但也阻碍了模型对某些专业问题的回答能力。未来,如何平衡开放性与安全性,将成为化学人工智能系统设计的重要方向之一。值得关注的是,许多化学大型语言模型没有有效的自我置信度评估机制。换言之,模型难以判断自身回答的可靠性,导致在提交错误信息时反而显示出高置信度,这种“过度自信”问题可能误导使用者,带来科研甚至安全风险。为了解决这一问题,研究者尝试通过提示工程、外部验证体系和结合专家系统等手段,提升模型的自我评估能力和输出可解释性,促进人机协作中信任和准确性的提升。在人机协作的背景下,化学大型语言模型的优势更倾向于辅助而非替代。

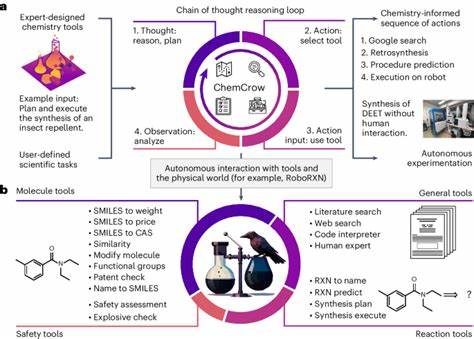

它们可快速处理文献、汇总观点、设计实验方案辅助手动筛选等,大幅提升化学家工作效率。同时,专家的介入对于最终决策、复杂推理和安全评估至关重要。随着多模态人工智能技术的发展,将化学文本信息与结构图像、实验数据结合,对增强模型理解化学现象的深度和准确性极为重要。未来,模型与专业数据库、实验平台的深度整合,有望实现更智能的化学实验设计、自动化执行和实时反馈,推动化学研究的新范式。化学教育领域亦受到大型语言模型崛起的显著影响。传统以记忆和标准题解为主的教学方法,面临被智能模型轻松应对的挑战。

教育者需重新设计课程,强调批判性思维、实验设计能力和科学方法论培养,增强学生独立判断和创新能力。与此同时,基于ChemBench框架的系统评估为模型研发和教育改革提供了量化标准,促进双方优势互补。总之,大型语言模型已展现出令人瞩目的化学知识掌握和推理潜力,甚至部分超越人类专家。然而,当前模型的局限性和安全性问题不容忽视,亟需持续投入优化算法、训练数据和人机交互方式。未来,围绕定制化化学知识库、增强自我评估机制以及多模态信息融合的研究,将推动人工智能成为化学领域真正可靠的合作伙伴。通过结合先进的计算技术与深厚的学科专业,人工智能有望助力实现更高效、更安全和更具创新性的化学科研及应用实践,开辟化学科学的新纪元。

。