在软件工程领域,托尼·霍尔(Tony Hoare)于1996年发表的一篇论文《软件是如何在缺乏形式证明的情况下变得如此可靠的?》提出了一个令人深思的现象:尽管许多软件系统未经过数学上的形式证明,软件却能够在实际应用中表现出高度的可靠性。霍尔针对当时软件业界对于关键系统安全的担忧和对形式验证的研究热潮,提出了一个颇具启发性的思路,解释为何软件即便没有完全证明,也能避免灾难性失败。传统观点认为,尤其是在医疗设备、航空航天、军事系统以及核能管理等安全关键性领域,软件的正确性关系到生死和巨大财产损失。然而数据显示,因软件错误直接导致的严重事故远低于预期,例如至今可靠归因于软件的死亡病例仅有数起,其中大部分涉及辐射治疗中的剂量计算错误。这种现象挑战了当时主流的担忧,为什么软件在极其复杂、代码量庞大的环境下依然能稳定运行呢?霍尔认为,答案是多种因素叠加的结果。首先,软件项目的管理能力显著提升,现代软件开发遵循严格的生命周期管理原则,包括需求分析、设计、编码、测试、部署及维护。

这种规范化管理帮助提前发现和消除潜在缺陷。同时,软件测试以其实践性和高效性证明了自身的价值。尽管测试无法覆盖所有执行路径,但如果方法得当,测试能够捕获绝大多数对系统稳定性有实质影响的缺陷。由测试驱动的程序调试过程将频繁发生且影响显著的错误逐步清除,使剩余错误对系统产生实际影响的概率极小。此外,软件设计的进步尤为关键。结构化编程和类型检查在20世纪后期逐渐普及,极大地减少了代码中的逻辑混乱和类型误用,防止了许多隐晦的错误产生。

类型系统尤其在防止低级错误,如指针误用、数据类型混淆等方面发挥了有效作用。霍尔的分析强调软件的硬化特性,即设计中引入冗余检查和容错机制,确保异常情况被及早捕获或不会影响系统核心功能,常见于安全关键软件中。例如,多重验证输入和运行时检查成为必须,降低了未知错误的传播风险。至1996年之后,软件生态进一步演进。软件规模成百上千倍增长,复杂度激增,但模块化设计理论和实践的深化,特别是在大型操作系统内核如Windows NT和Linux中,通过合理划分模块和接口,极大地改善了代码的可维护性和错误隔离。模块间低耦合度帮助开发团队独立工作、快速定位缺陷,避免复杂系统中因依赖关系交织导致的问题爆炸。

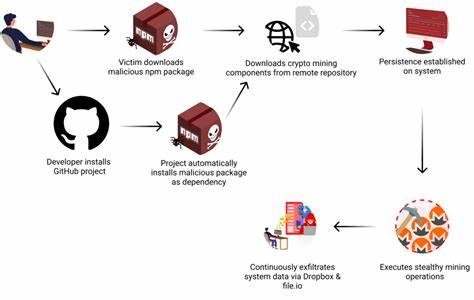

与此同时,网络化安全成为现代软件的最大挑战。尽管功能日益强大,但网络暴露带来的安全风险急剧上升,常见的软件漏洞导致漏洞被广泛利用。此时,形式验证在理论上解决安全策略正确性保障方面展现潜力,但由于现实中的复杂性依然难以实现全面应用。实用层面,软件安全仍主要依赖迅速发布补丁和持续更新。虽然从传统软件正确性角度看,形式证明未大规模普及,但轻量级的形式化方法,如静态分析工具,已是主流开发流程不可或缺的一环。这类工具能够自动检测代码中的常见陷阱和潜在错误,如越界访问、空指针解引用及内存泄漏,极大提升了代码质量并减少人工调试成本。

微软等大型厂商在实际产品中采用静态分析和模型检测技术,配合严格测试,显著强化了软件稳健性。霍尔的论文与后续讨论揭示了软件质量提升的多维路径,打破了依赖形式证明才能保证软件质量的固有观念。软件通过项目管理、设计原则、充分测试、调试磨合及模块化,积累了足够的经验和机制,形成了一套非形式化但实用的可信赖体系。当然,软件行业依旧存在挑战。系统越复杂,潜在缺陷也越多,安全漏洞时有爆发,且某些领域需要极高可信的系统仍旧依赖正式方法加严验证。未来软件发展很可能是全栈形式化技术与工程实践的深度融合,既保证开发效率,又提升软件质量。

总的来说,霍尔的洞悉为软件工程学科注入了清晰的视角,帮助业界平衡从理论到实践的落差。他提醒我们,软件可靠性是多因素、多层面协同作用的结果,而非单靠形式证明或测试就能实现的。随着技术演进和需求增长,理解并借鉴这些历程有助构建更加安全、高效、稳健的未来软件系统,让我们在数字时代信赖那看似无形却无处不在的软件力量。 。