随着人工智能特别是大型语言模型(LLM)的高速发展,越来越多的行业开始依赖这些技术来辅助文本生成、数据分析和决策支持。ChatGPT、Gemini、Claude、Grok等不同公司的语言模型在提供便捷和高效的语言理解与生成能力同时,也暴露出一个普遍存在的挑战,即幻觉现象。所谓幻觉,指的是模型生成内容时出现自信且流畅但实际是错误、不真实或捏造的信息。这种情况不仅影响用户体验,更在某些敏感领域可能导致严重后果。针对该问题,CompareGPT.io应运而生,成为一款通过多模型对比检测LLM幻觉的创新工具。幻觉问题给用户带来的困扰不容忽视。

大型语言模型训练依赖巨大数据,模型理解语义的能力虽在不断提升,但仍然存在"自信错误"的现象。模型输出的虚假信息或误导性观点可能使用户误判事实,进而导致决策风险。尤其在法律、金融及科研领域,这种潜在风险不可低估。传统的单一模型输出无法保证信息的真实性和准确性。由此,业界专家提出多模型比较的策略。CompareGPT.io恰恰利用了这一理念 - - 通过向多款不同来源的LLM发送相同查询,汇集并展示它们的回答,便于用户一眼识别各模型之间的一致性与差异。

当多个模型输出一致时,用户可以对信息的可靠性有更高信心;若出现分歧,则提醒用户进行进一步的校验和核实。CompareGPT.io的核心功能在于简化了这一繁琐过程。用户无需逐个访问及提问不同模型,在平台上一键完成对比查询,大幅提升了使用效率。平台还提供统一的API接口,方便开发者将多模型结果整合进各类应用,构筑更为稳健的AI问答体系。多模型一致性作为识别幻觉的手段,已经展现出巨大的潜力。CompareGPT.io的创始人Tina表示,正是源于个人对幻觉困扰的体验,激发了她打造这一工具的念头。

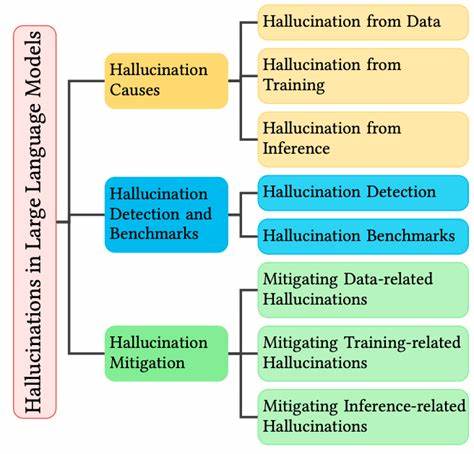

她认为,多模型对比不仅能帮助普通用户甄别虚假内容,更有望成为法律分析、金融决策和科研数据验证等严肃应用场景中的标准做法。幻觉问题的根本原因复杂。大型语言模型基于概率推断生成文本,缺乏对事实的准确记忆和检索,有时会基于已有语料、模式做出错误推断。多模型运行机制和训练数据存在差异,因此输出结果的交叉验证成为发现错误的有效途径。未来,随着更多模型的接入和算法优化,多模型对比将进一步完善。CompareGPT.io当前已支持主流模型,包含ChatGPT、Gemini、Claude和Grok,用户通过同一问题向多平台提问,实时获得各自回答并整合显示,显著提升了幻觉检测的直观性和可用性。

实际应用中,法律顾问通过多模型核实法规条文解释,金融分析师利用平台对市场预测进行复核,科研人员检查文献综述和数据解读,有效降低了因信息误导带来的风险。此外平台还推出了早鸟优惠和终身会员计划,快速吸引了不少行业用户的关注和试用。尽管多模型对比方法优势显著,但仍面临挑战。首先,多模型的API调用成本及响应时间需优化,以保证用户体验流畅。其次,不同模型之间结构与输出格式多样,如何实现标准化展示和对比仍需技术攻关。再次,模型本身的局限性无法完全消除幻觉,未来或需结合知识图谱、事实验证数据库等辅助工具,形成复合验证体系。

综合来看,CompareGPT.io代表了对抗LLM幻觉问题的前沿探索,为AI生成内容的可信度提升提供了有效路径。多模型一致性的理念和实践,有望促进相关行业建立更高标准的信息核实机制,从而推动AI应用走向更安全、可靠的未来。在用户和开发者日益关注AI输出质量的今天,类似CompareGPT.io这样创新工具的出现,无疑丰富了多模型协同机制的生态,也为推动大型语言模型技术健康发展贡献力量。随着人工智能继续融入各行各业,聚焦提升生成文本的准确性和可信度,将成为影响AI普及及深度应用的关键。CompareGPT.io的多模型对比方案,或将成为业界倡导的验证范式,推动语言模型技术迈向更高水平。未来,期待更多企业和研究者基于这一思路,共同推动AI语言生成系统的透明化与可靠化,助力人类在法律、金融、科研乃至更多领域获得更可信赖的智能支持。

。