随着人工智能技术的飞速发展,越来越多的开发者和企业开始关注如何高效、安全地搭建AI应用环境。传统云服务虽然功能强大,但高昂的费用、复杂的配置和数据隐私问题常常成为困扰开发者的阻碍。在此背景下,LocalCloud一款创新的本地AI开发平台应运而生,其能够让开发者在本地环境中零成本运行完整的AI技术栈,有效解决了云服务的多种痛点。 LocalCloud的出现颠覆了传统的AI开发方式,将全套AI服务及基础设施打包进一个本地Docker环境,无需互联网连接即可实现模型推理、数据库管理、缓存、队列和存储等全方位功能。它支持PostgreSQL、MongoDB、Redis、MinIO等众多开源组件,并集成了高效的本地大语言模型如Ollama,帮助用户快速完成从数据存储、语义搜索到文本生成的全流程开发。 最大的亮点之一是LocalCloud保证了完全的隐私安全。

所有数据和模型均运行于用户的本地机器,避免了将敏感信息上传到远程服务器而带来的潜在风险。对金融、医疗、政府等对合规性和隐私要求极高的行业尤为适用。企业能够在无须外部网络访问的条件下,构建自主可控的AI系统,消除对第三方云服务的依赖,同时降低了运营风险和成本。 从开发体验来说,LocalCloud极具友好性。它以Go语言编写,提供单一可执行文件的CLI(命令行工具),支持macOS、Linux及Windows多平台,无需繁琐的环境配置即可在几分钟内启动全套服务。无论使用Python、JavaScript、Go、Java或.NET等语言,开发者都能通过标准的API接口访问LocalCloud的数据库、缓存、对象存储和AI模型,轻松集成已有项目。

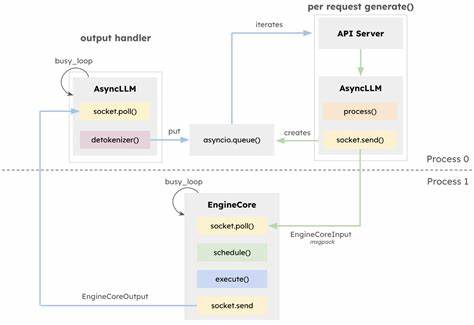

LocalCloud不仅适合个人开发者,也为初创企业和成熟团队带来了极大的开发效率提升。在开发初期,创业者可以用LocalCloud快速搭建MVP原型,避免云服务的账单压力,实现零成本验证产品想法。对于企业项目,LocalCloud消除了等待IT审批和云资源配置的繁琐工序,开发团队可以即时获得数据库和AI资源,快速迭代功能,缩短产品上线周期。 此外,LocalCloud特别注重AI辅助开发的集成,支持与主流AI助理如Claude Code、Cursor及Gemini CLI无缝合作,用户在一杯咖啡时间内即可通过AI助手完成完整的聊天机器人后端搭建。AI模型管理同样方便,用户可通过简洁命令下载、查看及删除模型,灵活控制本地资源。 在技术架构上,LocalCloud基于Docker容器确保服务隔离和运行稳定,带来一致且可复制的开发环境。

它还提供多种预设模板,包括具备记忆功能的聊天助手、基于检索增强生成(RAG)的知识库系统以及语音转文本的Whisper应用,满足不同AI开发需求。用户亦可自由定制组件,实现裁剪式部署,优化资源利用率。 对教学与学习者而言,LocalCloud是掌握AI和数据库技术的理想平台。它无需互联网访问,无复杂的账号注册及API密钥管理,简化了学习门槛。学生和爱好者可以快速搭建完整开发环境,方便练习和实验,本地运行保证了学术研究和项目开发的数据控制权。 LocalCloud的安装过程也极其简便。

用户可通过官方安装脚本或Homebrew等包管理器快速完成部署。通过交互式或非交互式命令,开发者可选择合适的模板或组件集,配置端口及资源限制,配合详尽的文档,即使是刚入门的开发者也能无障碍上手并立即启动服务。 尽管LocalCloud当前版本以命令行操作为主,但项目团队已规划未来版本加入图形化管理面板、SDK多语言支持、模型微调功能、团队协作及项目隔离等重要特性,努力构建更完善的本地化AI开发生态系统。与此同时,社区反馈和开源贡献促进了其快速迭代与优化,不断满足广大用户的实际需求。 总的来说,LocalCloud为全球开发者提供了一个免费、开源且高效的本地AI开发平台。它解决了云端AI应用开发常见的成本、隐私和配置问题,使得AI技术更易于普及和掌握。

无论是创业公司快速验证产品、企业内部安全开发,还是个人学习和试验,LocalCloud都展现出极大的应用潜力和广泛价值,正引领AI开发迈向更加自主、安全且高效的未来。未来,随着更多功能的完善与推广,LocalCloud有望成为本地AI开发领域的标杆工具,助力更多开发者释放创新生产力,打造智能应用新时代。