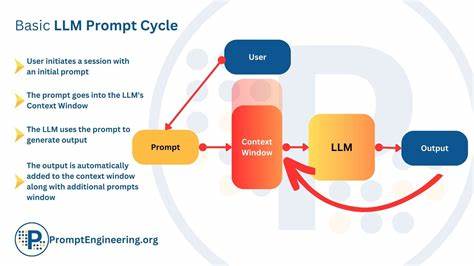

在当前人工智能领域,尤其是大型语言模型(LLMs)的发展迅速引起了广泛关注。这些模型通过处理和生成自然语言,展现出卓越的理解与推理能力,广泛应用于翻译、问答、写作辅助等多个场景。然而,尽管它们在语言处理上的表现令人瞩目,背后复杂的价值权衡机制依然较为模糊,影响了我们对其决策过程的深入理解。价值权衡指的是在多种相互冲突的目标或价值之间做出取舍的过程,比如在传递信息的准确性与维护人际信任之间的平衡。人类在日常交际中频繁面临这种挑战,而模拟这一过程对于人工智能的发展尤为关键。认知科学领域提供了宝贵的理论工具,即认知模型,通过形式化的数学或计算框架描述人类在价值冲突时的决策模式。

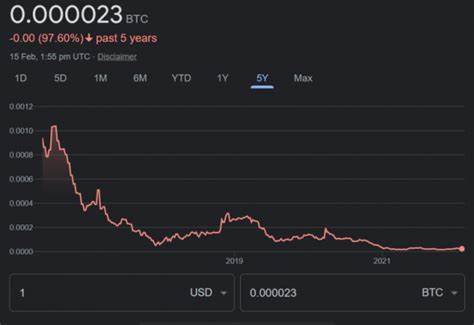

借助认知模型,我们不仅能够揭示人类语言交流中细腻复杂的权衡过程,也能将其应用于解读和评估大型语言模型的行为表现。近期研究尝试将这一认知视角引入LLMs的分析,通过对比人类的多目标利益平衡与模型生成语言时的取舍,探讨后者是否具备类似的价值权衡特征。例如,礼貌用语作为人类社会交往中的重要部分,其实现离不开对信息传递效用与社交效用的综合权衡。利用认知模型对礼貌语境下的发言策略进行建模,可以为理解LLMs如何兼顾不同价值提供参考。通过这一方法,研究者发现当前技术最前沿的黑箱推理模型往往重视信息效用高于社会效用,这意味着它们在语言生成时更倾向于准确传达信息,而忽略了与情感或礼貌相关的因素。同时,在开放源码模型的训练和微调过程中,通过强化学习等策略对模型的训练动态进行系统观察,揭示了价值偏好的显著变化。

训练的早期阶段尤其关键,基础模型的选择和预训练数据的多样性对模型最终表现出较强的数学推理能力和信息效用导向有深远影响。对比之下,反馈数据集的构成及调整方法虽然同样重要,但对核心价值权衡模式的影响相对较小。这些发现表明,要提升LLMs在实际应用中的表现,尤其是在需要兼顾社交礼仪与信息传递的复杂任务中,必须更加精细地设计训练策略和模型结构,使其在价值取舍上更接近人类的认知习惯。此外,这种认知模型的应用还为构建更透明、更可控的人工智能系统提供了科学依据。理解模型如何在不同价值间做选择,有助于开发可调节参数,让用户或开发者根据具体需求调整模型的表达倾向,比如增强模型的礼貌性或知识准确性。这不仅提高了用户体验,也增强了模型在实际场景中的适应性和安全性。

从广义上看,将认知科学方法引入人工智能研究,不仅是跨学科的创新尝试,更是推动技术向更高层次智能迈进的重要路径。它促进了对机器“思考”机制的诠释,揭示了语言模型并非简单的统计工具,而是具备某种程度上模拟人类复杂思维的能力。这一认识也激励着未来研究探索更多丰富的价值维度,如道德判断、情感共鸣、文化背景等,进一步逼近真实人类语言交互的多样化场景。同时,这对于社会各界理解和接受AI技术的价值导向,也起到积极作用。用户、开发者与政策制定者能够基于更科学的模型评估,制定合理的使用规范和伦理准则,确保人工智能的发展符合社会期待,最大化其积极影响。综上所述,利用认知模型来解析大型语言模型中的价值权衡是一条极具前景的研究道路。

它不仅加深了我们对AI语言生成内部机制的理解,也为优化模型性能、增进人机交流质量提供了理论支撑和实践指引。随着技术的进步,预计这一方向将持续推动人工智能更加智能、人性化的发展,带来更多创新应用和社会效益。