在现代后端服务开发中,数据序列化是一项不可或缺的技术环节。尤其是在使用Node.js作为服务器环境时,如何高效地将数据序列化成为提升整体性能的重要因素。传统的JSON序列化因其良好的可读性和广泛的支持,成为默认选择。然而,近年来越来越多的证据表明,某些二进制序列化格式在性能上远超JSON,尤其是在大规模数据处理场景下表现突出。本文将聚焦于Node.js环境中的序列化性能,深入探讨为什么二进制格式能够胜出,背后的技术挑战,以及如何通过优化策略最大化序列化效率。 首先,我们需要理解Node.js中JSON序列化的特性。

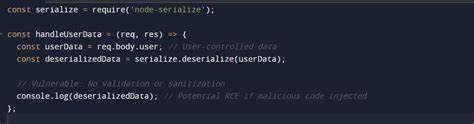

JSON序列化在V8引擎中由C++实现,经过多年的优化,性能表现相当出色。它能够高效地处理JavaScript对象到字符串的转换,且由于是内置函数,调用非常快速。但是,JSON格式作为一种文本格式,天然存在数据冗余,传输过程中会占用更多带宽和存储资源。相反,二进制序列化格式如Avro、Protobuf和Msgpackr采用紧凑编码方式,通常生成的数据体积更小,可以在网络传输和磁盘存储中显著减少资源消耗。 尽管从理论上看,二进制格式应该在性能上胜过JSON,但实际情况却复杂许多。一些二进制序列化库在Node.js中经常表现不佳,原因主要在于JavaScript本身的特性和运行时环境的限制。

例如,有些库纯JavaScript实现,缺乏底层优化,这使得它们在执行序列化时产生大量临时对象和内存垃圾,导致频繁的垃圾回收,严重拖慢整体序列化速度。 优化序列化性能关键在于两方面。首先是减少在序列化准备阶段产生的垃圾对象。在实际项目中,开发者经常需要将原始数据转换为符合序列化格式要求的特定结构,比如将枚举类型映射到特定值,或者将undefined字段转换成null。传统的处理方式是通过映射函数创建新对象数组,这会导致大量短生命周期的临时对象生成。优化的思路是创建专门的“重映射类型”类,通过getter方法实时转换数据而非生成新对象,极大地减少了垃圾产生,提高了CPU利用率和序列化速率。

其次是合理分配内存缓冲区。很多二进制序列化库内部采用动态缓冲策略,遇到缓冲区不够时自动扩展缓冲大小。这种扩容通常是成倍增长缓冲区大小,同时需要将已有数据复制到新缓冲区,过程非常消耗时间和系统资源。在JavaScript环境中,Uint8Array的分配和复制开销更是显著。有效的做法是预先计算序列化所需的准确缓冲大小,直接分配足够大的缓冲区,避免动态扩展带来的性能损耗。一些库虽然具备缓冲区复用机制,但缺乏明确的序列化大小预测接口,这限制了优化的空间。

具体到各个库的表现,Bebop库虽然经过优化,性能提升明显,但整体依旧落后于JSON,主要是因为缺乏预分配缓冲区的支持。Protobuf.js虽然内部实现复杂,自动处理缓冲区增长,但由于必须创建特定Message对象,无法避免大量垃圾产生,导致垃圾回收在序列化过程占据极大比例时间。相比之下,Pbf库展现了极高的性能优势,代码简洁,序列化速度快,生成数据体积小,充分体现了设计简洁和性能优化的力量。 此外,从更宏观的角度来看,JavaScript作为一种动态解释语言,本身在计算密集型任务上天然有限制。即使经过大量微调和性能剖析,Node.js上的序列化任务仍难以达到编译型语言如Rust的性能水平。如果对性能有极高要求,特别是在数据密集型应用程序中,选择Rust等系统级语言进行序列化处理,无疑是更优方案。

借助Rust强大的内存安全和高性能特点,可以显著提升序列化效率,减轻服务器负载。 在实际应用中,开发者应充分权衡业务需求、开发成本和系统复杂度,选择合适的序列化格式和实现策略。对于对带宽和存储空间敏感的应用,二进制序列化是理想选择,但必须结合内存管理和缓冲区优化手段以激发其潜力。对于快速开发和调试阶段,JSON依然是便捷工具,其成熟的生态和较好表现使其难以被完全取代。 总结来看,Node.js环境下的序列化性能优化是一个综合考量的过程。理解底层实现机制,避免无谓垃圾生成,合理分配内存资源,都是提升性能的关键要素。

随着社区不断推动二进制序列化库的完善和生态的发展,未来在Node.js中实现高效可靠的序列化将变得更加轻松。与此同时,在关键性能场景下,借助更高效的编译型语言完成序列化处理,也是不容忽视的战略选择。通过本文的剖析和优化建议,期望帮助开发者深入了解Node.js序列化性能背后的奥秘,应用最佳实践,提升后端服务的数据处理效率和整体响应速度。