近年来,语言模型尤其是基于自回归结构的模型如GPT系列和Llama等,在自然语言生成领域展现出强大的能力。然而,高质量的文本生成往往伴随着高昂的计算成本和较长的推理时间,这对实际部署和用户体验产生了不小的挑战。作为解决这一难题的前沿技术之一,Set Block Decoding(简称SBD)应运而生,为语言模型推理带来了全新的加速思路。 Set Block Decoding的核心创新点在于其灵活地结合了两种主流的预测机制:下一令牌预测(Next Token Prediction,NTP)和掩码令牌预测(Masked Token Prediction,MATP)。传统的自回归模型一般每次只预测一个令牌,计算过程必须串行执行,极大限制了推理速度。SBD通过允许模型在单次前向传播中并行采样多个未来令牌,且这些令牌不必是连续的,从根本上打破了原有的顺序依赖。

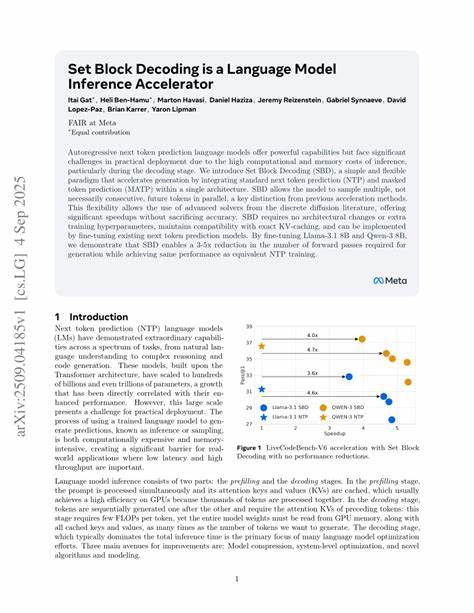

这种变革性的预测策略不仅大幅加速了解码过程,还引入了先进的离散扩散方法优化方案,使得生成速度在保证模型准确性的前提下得到了显著提升。更重要的是,SBD不需要对基础模型架构做出大幅修改,也无须额外设计训练超参数,兼容现有的键值缓存(KV-caching)技术,可在实际应用中灵活部署,极大降低了实施成本和复杂度。 以近期公开的研究为例,经过SBD细致调优的Llama-3.1 8B和Qwen-3 8B模型,在推理阶段实现了3至5倍的前向传播次数减少,且在生成文本质量上完全匹配传统下一令牌预测训练的表现,显示出极具竞争力的效率优势。同时,这种方法的适用范围广泛,不限于特定型号的语言模型,具有极强的通用性和未来扩展潜力。 在实际应用中,从智能客服、内容创作到机器翻译,Set Block Decoding能够有效缩短响应时间,提高用户交互的流畅度和体验感。对于云服务提供商和企业级AI解决方案,减少推理成本意味着可以用更低的硬件投入获得更高的服务吞吐量和容纳更多用户请求,促进AI技术的大规模普及和商业化落地。

SBD的设计逻辑还体现了当前AI研究前沿对于效率与准确性平衡的深刻洞察。掩码令牌预测引进了多样性和全局上下文理解,而下一令牌预测维持了生成的连贯性和逻辑性,将两者结合的策略为语言模型生成过程插上了腾飞的翅膀。研究团队利用离散扩散领域中成熟的求解器技术,确保了多个非连续令牌的预测结果能够协调一致,避免了生成内容碎片化和语义错乱的风险。 此外,SBD的无缝集成能力也降低了AI开发者的门槛。开发者无需从零开始训练模型,只需针对现有模型进行适当的微调,即可享受到推理加速带来的收益。这种"低成本高回报"的特性对推动AI技术在更多产业场景中的应用具有重要意义。

展望未来,Set Block Decoding有望结合更多前沿技术持续提升语言模型的推理效率。例如,结合硬件加速器的优化方案、采用更先进的生成策略和动态计算路径选择机制,进一步推动AI生成技术的边界。同时,随着多模态模型和大规模跨语言模型的兴起,SBD灵活的解码机制可能为复杂场景下的推理计算带来革命性变化。 总的来说,Set Block Decoding作为一种新颖且高效的推理加速方案,有望成为下一个推动语言模型应用普及和性能突破的重要引擎。它所倡导的灵活多令牌并行预测思路,不仅突破了传统生成方式的限制,也为AI系统设计者提供了新的思路和工具,提升了自然语言处理技术的整体竞争力。随着更多研究者和工程师投入到这一方向,未来我们将见证更多基于SBD的创新产品和服务走进人们的日常生活,助力人工智能迈向更智能、更高效的新时代。

。