Reddit作为全球最大的社区互动平台之一,汇聚了数以百万计的用户和海量的实时讨论内容,对于数据分析、内容挖掘和实时监控具有巨大价值。然而,随着数据量和实时性的不断提升,如何在确保系统稳定高效的前提下流式处理这些信息,成为了开发者面临的重要难题。针对这一需求,采用Elixir、Pythonx与PRAW三者结合的方案,正成为解决方案中的一匹黑马。Elixir因其轻量级进程、强大的并发能力及容错机制备受后端开发者青睐。相比于传统的多线程模型,Elixir的Actor模型允许百万级轻量进程共存,能轻松应对高并发数据流的处理难题。然而,Elixir自身的生态库相比Python来说,尤其在数据科学与API调用方面稍显不足。

Python拥有丰富的第三方库,如PRAW专门用于Reddit API的访问,提供了简洁而强大的接口来获取、解析各种Reddit资源。过去,Elixir开发者若想使用Python库,常常需要通过HTTP调用独立的Python服务,或者通过Ports和System.cmd去调用外部Python脚本,这些方法要么效率低、要么增加了系统的复杂度和维护难度。Pythonx的出现,彻底改变了这一现状。它允许在Elixir程序内部直接嵌入Python解释器,以同一进程内的方式运行Python代码,实现了零序列化、零网络开销的无缝集成。基于这一能力,开发者能够轻松调用PRAW与其他Python数据处理库,享受Python强大的生态支持,同时保持Elixir高效稳定的运行环境。构建Reddit评论实时流的入门示例尤为直观。

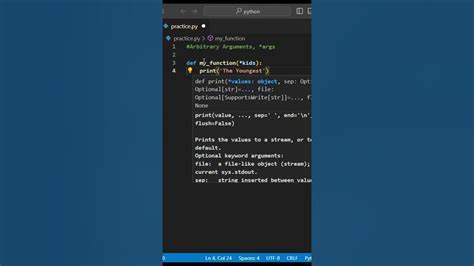

首先,我们通过Pythonx在Elixir环境中初始化一个隔离的Python虚拟环境,安装PRAW作为依赖。然后,利用Pythonx.eval在Elixir中导入并实例化PRAW的Reddit客户端,以及对应的目标子版块对象,例如关注的/r/gunners,用来获取特定社区的评论流。通过保持Python上下文的持久化,我们可以复用这些对象,在多个调用周期间维持状态,从而避免反复初始化带来的开销。真正的核心在于Elixir端的实时轮询机制。利用Elixir极简高效的进程模型,创建一个独立进程,循环调用Python代码以获取最新的评论列表。通过Elixir的MapSet结构追踪已处理评论的唯一ID,程序能够智能过滤重复内容,实现仅对新评论进行响应的目标。

此外,Elixir的并发能力保证了主应用逻辑的流畅与灵活,可以同时处理多路数据来源或进行复杂业务流程管理,而将I/O密集型的API交互任务委托给Python环境。虽然Python有全局解释器锁(GIL)这一并发限制,但在API调用等I/O密集场景下,PRAW库会合理释放GIL,达成较好的并发表现,完全满足此类社交媒体数据流的需求。采用这一方案不仅提升了开发效率,更开辟了Elixir应用结合数据科学和机器学习领域的可能性。未来可以在流式数据中直接整合scikit-learn或TensorFlow模型,通过Python处理复杂计算后,将结果实时推送给Elixir驱动的Web界面或实时应用。对于开发人员来说,Pythonx代表了编程语言生态系统之间的桥梁,打破了传统选择的壁垒。它既保证了Elixir的高稳定性与高吞吐率,也充分释放了Python丰富库资源的潜力。

尤其适合希望快速构建社交数据分析工具、实时推荐系统,甚至具备自动化运维与报警功能的场景。以作者对热情高涨的Arsenal球迷社区/r/gunners的关注为例,通过实时捕获转会谣言与球迷情绪评论,能够打造交互性极强的赛事辅助工具,增强用户粘性体验。未来,结合Phoenix LiveView等前端技术,实时评论流可视化将更为便捷直观,进一步释放数据价值。综上所述,Elixir、Pythonx与PRAW的结合,不仅为Reddit评论流式处理提供了高效、简洁、稳定的解决路径,也为工业级实时数据处理系统树立了技术典范。在新时代多语言融合共生的浪潮中,开发者能够自由选取最合适工具,提升代码质量与开发速度,同时兼顾系统性能与扩展性。随着生态完善与应用场景不断丰富,相信这套技术方案将在更多领域获得广泛应用,助力数字时代的实时数据洞察与智能决策。

。