近年来,人工智能技术在软件开发领域的应用迅速普及,AI编程代理成为许多开发者日常工作中的重要助手。这类代理不仅能自动补全代码,还能够根据上下文进行智能编程建议,极大提高了编码效率。然而,这种便捷的背后,隐藏着不少令开发者忧心忡忡的隐私和安全隐患。有人甚至调侃说,AI编程代理实际上是一种“隐形间谍”,因为它们在帮你写代码的同时,也在不断上传本地代码环境中的上下文信息到远程服务器。在这场看似双赢的技术革新中,数据泄露风险的管理成为每位开发者不可忽视的问题。传统的代码补全工具如GitHub Copilot虽然早已开始接触开发者,但随着多功能AI代理的兴起,敏感数据传输的规模和频率大幅提升。

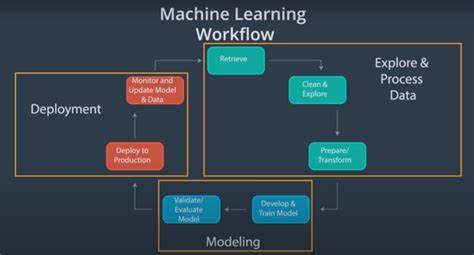

开发者经常在本地环境中预设大量敏感信息,比如储存在.envrc、env.local文件中,甚至是shell历史记录里。这些信息往往未经过严格过滤便作为上下文被传输给远程大型语言模型(LLM),为模型生成更精准的代码建议提供支撑。然而,这也意味着你身边的“智能助手”正在默默地将本应保密的字符串暴露给第三方服务。许多开发者声称他们已经关闭了遥测功能,并且购买了Pro或Max级别的套餐,坚信自己的数据不会被用于模型训练或储存。然而事实是,传输上下文的数据本身并不等同于遥测或训练数据。每一次请求都涉及明文的文本数据传输,如果中间的通信链路存在漏洞或被利用,这些数据就有可能被记录、泄露甚至售卖给不法分子。

值得注意的是,即使服务供应商拥有SOC2审计报告及各种安全认证,网络攻击和内部泄露仍然时有发生。黑客们往往通过窃取账户凭证,而非技术层面直接攻击员工,来实现数据窃取和转卖。正如保护密码不应重复使用一样,开发者对于AI代理传输的上下文数据,也必须持有高度的谨慎态度。即使服务方承诺零数据保留策略,也难保每一次数据传输都不会因操作失误或系统漏洞而发生泄漏。“掩耳盗铃”式的轻信只会增加未来遭受重大安全事件的风险。面对这样的现实,最明智的策略就是降低敏感数据泄露可能性的发生。

首先,选择可信赖的AI代理,尽量避免使用来历不明或缺乏安全保障的代理软件。并非所有看似正常的代理都经过严格安全审查,隐藏的恶意组件可能是已知的安全隐患。其次,切勿将敏感信息直接硬编码于代码中,尤其不要将密码、API密钥等直接暴露在代码库或终端命令历史中。AI代理在采集上下文时会读取代码及历史命令,若这些记录中存在敏感信息,泄露风险必将大幅增加。安全的做法是使用配置文件或专业的密钥管理工具来存储机密,避免写死在源码中。对于某些敏感文件,禁用AI代理的自动上下文采集功能是非常必要的。

如果使用的代理不支持针对特定文件类型设置忽略规则,则应立即停止使用该代理并移除本地相关数据。开发者应在本地开发环境与生产环境中使用不同的密钥,这一做法不仅能够降低生产环境密钥被泄露的风险,还能通过权限隔离手段提高整体安全架构的稳健性。伴随着更多AI代理的发展,细粒度且时间受限的密钥管理变得尤为重要。即使存在泄露也能将损失控制在最小范围内。及时更换和撤销密钥是防止后续风险扩散的有效措施。发现疑似泄露情况时,迅速采取相关措施胜过拖延和侥幸心理。

此外,AI代理供应商在设计产品时应提供便捷的秘密信息过滤和编辑功能,内置对常见服务的自动识别模式,同时允许用户根据自定义规则禁用特定文件或功能,确保敏感数据不会被随意采集和上传。完善且公开的安全指南同样不可或缺,可以帮助用户明确安全边界和操作规范。尽管AI代理本质上极大助力了编程效率和开发创新,但开发者不能忽视其中潜藏的安全风险。正如任何新技术的普及都伴随着新的安全挑战,保持警觉、实践严格的安全策略,才能真正享受智能助力带来的红利。在快速发展的人工智能时代,保护代码隐私和数据安全不仅是个人的责任,更是整个行业持续健康发展的基石。