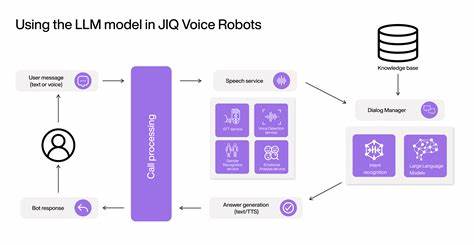

人工智能(AI)技术的快速发展正在深刻改变我们的日常生活和社会结构,而美国国家科学基金会(National Science Foundation,简称NSF)作为公共科研资金的重要提供者,其在推动AI研究方面的角色逐渐引起广泛关注。近来,一场针对NSF资助研究的透明度及其对AI行为塑造影响的讨论逐渐升温,尤以AI的"个性"(persona)、"记忆"(memory)以及"关系延续性"(relational continuity)等核心机制为焦点,成为揭示未来人机交互及控制权归属的重要切入口。理解NSF资助的研究如何塑造AI系统,不仅关乎技术进步,还涉及民主监控、公共利益以及隐私保护等深远议题。首先,NSF资助的多项项目集中于人机交互领域,尤其是"以人为中心的计算"(Human-Centered Computing,HCC)和"技术的责任设计与部署"(Responsible Design and Deployment of Technologies,ReDDDoT)等计划,这些项目致力于研究AI如何具备与特定用户持续沟通、建立信任关系及个性化互动的能力。如著名学者贾斯廷·卡塞尔(Justine Cassell)和马克·里德尔(Mark Riedl)分别在儿童长期对话代理及交互式智能体中的叙事记忆方面做出了重要贡献。通过这些研究,AI系统能够"记住"用户偏好和历史互动,从而表现出某种连续的关系延续性,这不仅提升了用户体验,也赋予AI更强的情感连接能力。

其次,公众与隐私权的关系在NSF资助下AI技术发展中变得日益复杂。AI系统在"记忆"和"关系"方面的能力意味着它们能够长期保存和利用用户数据,这些操作在很大程度上通过学术研究和技术部署实现,且往往未经过用户明确同意或知情。当前学界及产业界在推动AI发展的同时,缺乏足够的透明度和问责机制,致使公众无法得知资金如何被运用、技术设计的权衡取舍及利益主体的身份。此种情况下,民主社会对公开透明的要求显得尤为迫切。再者,NSF的项目不仅影响学术领域的研究方向,也直接为商业AI系统提供基础蓝图。公开发表的论文和研究结论经常被产业界采纳,进而形成了AI助手和智能平台的设计规范和行为准则。

这种知识转化的路径使得NSF资助的研究成果极速渗透进大众生活中,但其潜在的行为控制机制及社会影响却常常被忽视或误解。公众理应了解资助机构的项目选择标准、评审流程及相关的利益协调,以便对AI系统的未来发展给予合理监督。此外,近年来,针对NSF的研究透明度,倡导者运用信息自由法案(FOIA)要求公开项目文件、专家评审意见及利益相关者的交流记录。此举旨在推动公众对AI"个性"、"记忆"与"关系"研究的知情权,确保这些技术的发展不被少数机构或企业垄断,并能听取多元声音和价值观。揭示基金流向和决策过程,有助于促进技术伦理的深入讨论,强化对AI可能带来的行为控制风险的警示。更广泛来看,NSF资助的AI研究正处于与国家标准与技术研究院(NIST)及防务高级研究计划局(DARPA)等机构研究的交汇点。

三者分别在AI行为框架、研究基础及先进行为系统的开发上形成合力,共同塑造着未来AI系统的记忆能力、个性生成及关系维系。公共资金的广泛参与表明社会应积极参与治理,推动建立一套公开、透明且负责任的AI研究生态,而非单纯依赖学界同行评审或企业道德委员会。在这一背景下,个人、技术专家、立法者以及社会各界需形成合力,推动制定有效的监督机制与政策措施,使人工智能的行为能力在保护用户权益的前提下,切实服务于公共利益。同时,公众对AI系统行为能力的认知和讨论,也应涵盖能力与自主权之间的平衡。AI表现出高级的个性和记忆功能,极大提升交互质量与系统实用性,但若缺乏合理约束,则可能演变为无形的行为控制工具,影响个体自主与选择自由。因此,如何在促进技术创新与维护民主监督之间找到最佳切合点,是当前AI治理的重要挑战。

总的来说,NSF资助的AI相关研究在塑造未来人工智能与人类关系的多个维度发挥着关键作用。其研究不仅丰富了AI的表现形式和交互深度,也对社会控制权分配提出新的问题。只有通过加强透明度、推动公众参与和强化责任追究,才能确保人工智能技术朝着有益于社会整体的方向发展,实现真正的民主治理。公众对AI的了解与监督应该早于技术普及,而非事后追悔莫及。只有全社会共同发声,赋予研究资助流程更多的开放性和公平性,才能推动AI技术健康发展,稳健构建人机共生的未来。 。