随着大数据时代的来临,数据的收集、清洗和转化已经成为各行各业不可或缺的环节。在Python生态中,pandas、polars等DataFrame库为开发者提供了极其便捷且强大的工具,使得操纵表格数据变得更加高效和直观。由于它们的灵活特性,DataFrame几乎成为数据科学和工程项目的默认选择。然而,过度依赖DataFrame处理业务逻辑,却极易导致代码的表达力下降,增加维护难度和潜在错误可能性。本文将结合实际案例深入分析DataFrame使用中的普遍问题,并探索如何通过构建领域专属数据结构来增强代码的可读性和扩展性,助力开发者在数据驱动的项目中取得更好的成效。许多开发者初学时,往往将DataFrame视为"电子表格的Python化",从而快速实现数据导入、清洗处理的需求。

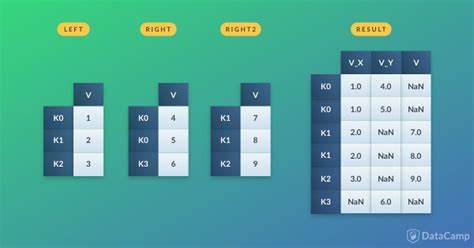

无论是从CSV文件、Excel表格还是数据库中加载数据,利用DataFrame的链式操作对各列进行字符串修饰、缺失值处理及数据类型转换,常见的"small-T"转换让整个流程显得轻松顺畅。然而,随着业务复杂度的提升,往往需要加入更多基于业务规则的复杂数据转换,即所谓的"big-T"转换,问题也随之显现。最主要的困境在于,DataFrame本质是一种二维表结构,但随着加工过程不断添加新的列、修改原有数据、组合字段等,DataFrame的形态变得越来越难以追踪。当多个函数之间传递和返回DataFrame时,难以直观判断数据的具体结构和包含的关键信息。例如,一个函数接受DataFrame后新增了shipping_labels字段,但调用者若无代码注释或类型提示,只能在代码调试时逐步查看其内部状态,明显不够友好。随着项目迭代和团队成员变动,这样的代码难以维系,开发者很容易因不了解数据当前形态而产生错误,乃至造成技术债务堆积。

更值得注意的是,在非分析类应用场景中,完全依赖DataFrame处理核心业务逻辑并非最佳实践。虽然DataFrame在聚合、分组和过滤等分析任务上表现卓越,但在具备明确业务语义和规则的场景下,为数据设计明确的面向领域的模型显得更加重要。比如,在处理通讯录数据时,仅用DataFrame对名称、地址等字段进行字符串拼接生成邮寄标签,表面上看操作简洁,但缺乏对"联系人"这一概念的明确定义和封装。当业务需求变化,新增如全名字段或者修改邮编拼接规则时,整个DataFrame操作链条可能需要繁琐的调整,而且再利用性低。取而代之,利用Python的dataclass创建专属数据结构,可以显著提升代码的表达力和可靠性。通过定义一个Contact类,明确规定每个字段的数据类型及可选属性,并为邮编拼接和全名提供专门的属性方法,使得业务逻辑更加直观且集中。

此举让不熟悉DataFrame具体处理细节的开发者,也能迅速理解数据代表的意义。同时,函数签名所体现的参数类型提示,提升了IDE的自动补全和静态检查能力,极大减少了类型错误的风险。转换流程也变得更易维护和扩展。通过先在DataFrame边界层进行数据加载与初步清洗,再将数据映射到Contact对象列表,业务核心部分完全基于对象进行操作。以创建邮寄标签为例,代码不再是模糊的列名拼接,而是清晰的Contact实例属性调用组合,语义上直接对应现实世界的联系信息。未来当需要导出到CRM系统时,同样能借助Contact类封装好的属性轻松完成格式转换,避免重复造轮子。

诚然,这种设计方式涉及额外代码量,但从长期项目维护和团队协作角度看,这笔投入十分值得。尤其对于增长迅速、功能不断扩充的项目,清晰的领域模型能有效避免数据处理逻辑的混乱堆积。随着开发周期拉长,开发者也不再需要在运行时通过断点和打印逐步追踪DataFrame内容,节省了大量排查时间,提升工作效率。要注意的是,此思路并非否定DataFrame本身的价值,而是在"边界清晰"的前提下进行合理分工。DataFrame依然是强大且灵活的数据格式,适合承担数据导入、清洗和导出等任务,甚至于分析类场景毫无疑问是首选。当应用逻辑超越数据分析,进入复杂业务处理阶段时,显式定义面向对象的数据结构则是更优途径。

总结来看,DataFrame的万能形象往往掩盖了潜在设计隐患。通过以面向领域设计理念指导数据处理流程,使用Python的类型注解和dataclass特性建立清晰且表达力强的数据模型,有助于减少开发误区和技术负担。这种方法不仅提高了代码的可读性和健壮性,也为持续迭代中的新需求提供了友好的扩展空间。面对复杂多变的业务要求,合理划分数据处理与业务逻辑层,避免DataFrame成为"黑匣子",是打造高质量Python数据应用的重要一环。未来,随着数据生态日益丰富和开发工具不断完善,结合数据类型系统与面向对象设计理念将成为主流趋势。对于所有致力于构建稳健且高效数据驱动系统的开发者而言,这种方法无疑提供了明确且可行的实践路径。

。