图形处理单元(GPU)已经成为现代计算领域不可或缺的核心组件,特别是在人工智能、深度学习和科学计算中发挥着关键作用。理解GPU的工作机制对开发高效的计算程序、优化性能以及推动技术创新都有重要意义。本文将全面解析GPU的基础架构、性能瓶颈、优化策略及其在实际计算中的应用。 作为高性能计算利器,GPU的设计本质上存在计算速度与内存访问速度之间的巨大不平衡。以NVIDIA A100 GPU为例,其计算能力可达19.5万亿次32位浮点运算每秒(TFLOPS),而其内存带宽仅为约1.5TB每秒。这意味着,在从显存(全局内存)读取一个4字节数据的时间内,GPU理论上能够执行50多次计算操作。

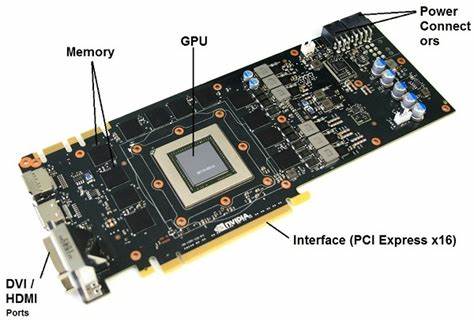

此种架构设计体现了GPU为了追求极致并行计算能力,而不得不面对的存储瓶颈挑战。 GPU工作时依赖的内存与计算层次结构极为关键。全局内存容量庞大但访问缓慢,常常是性能瓶颈所在。为减缓这一瓶颈,GPU内部每个流式多处理器(Streaming Multiprocessor,SM)均配备了高速的共享内存(Shared Memory)和寄存器文件,作为数据缓存和临时存储场所。以A100为例,全局内存容量约为40GB,且带宽为1.5TB/s,而每个SM内部的共享内存带宽高达19.5TB/s。这一差距突出表明,最大限度地复用已加载到共享内存的数据,是提升性能的有效手段。

GPU的计算单元以线程为最小执行单位,线程按批次划分为32个线程组成的“warp”统一执行相同指令。每个SM包含多个warp和线程块(Block),线程块内的线程共享同一块共享内存。为了充分发挥硬件潜力,线程之间需要高效协作,减少访问慢速全局内存的频率,提升算术强度(Arithmetic Intensity,AI)。 算术强度是衡量计算任务性能瓶颈性质的核心指标,定义为总计算浮点操作数与访问内存字节数的比率。算术强度低的程序多为内存带宽受限,运行时长主要取决于数据传输速度;算术强度高的程序则以计算能力为瓶颈,数据充分复用,计算资源被最大化利用。 GPU性能可通过“屋顶线模型”(Roofline Model)直观分析。

模型将性能绘制为算术强度的函数,显示出两个极限:内存带宽顶线和计算峰值顶线。以A100为例,算术强度超过约13 FLOPs/Byte即进入计算绑定区域,性能被计算能力限制;否则为内存绑定。优化目标是在算术强度维度推动内核性能向右移动,最终接近计算峰值。 然而,简单的计算映射无法有效提高算术强度。以矩阵乘法为例,若单线程计算单个输出元素,其算术强度约0.25 FLOPs/Byte,远低于A100需达到的13。理论上提升算术强度需依赖线程间合作,将大数据块加载进共享内存,进行数据复用,才可能实现计算绑定状态。

CPU端的调度开销,尤其是频繁启动大量小核(kernels),也会制约GPU性能,导致GPU空闲等待指令。现代框架采用异步执行和流水线机制减缓这种开销,确保GPU始终保持忙碌状态,提升整体吞吐量。 提升GPU性能的两大基本策略是算子融合和切片技术。对多个简单、依赖顺序执行的计算操作,融合为单一内核可以消除中间内存读写,降低延迟与带宽需求。比如两个独立的点对点加法与激活函数运算,若分两次独立执行,需要两次全局内存读写,导致大量冗余数据流动;融合后只读一次输入、写一次输出,大大节省带宽,提高执行效率。 针对单一复杂核,如矩阵乘法,切片(Tiling)则主要作用于将输入矩阵分块,逐步加载共享内存反复使用。

通过线程块协作,卷积等算法在计算阶段减少全局内存访问次数,极大提高算术强度。切片技术依赖三阶段操作:加载数据进共享内存、线程间同步、共享内存内部计算。此过程需保证加载数据高效的“聚合访问(Coalesced Access)”,即同一warp内线程访问连续内存地址,能一次性完成大块数据传输,最大化带宽利用率。 实现聚合访问时内存地址对齐尤为重要。使用矢量指令(如float4类型)能减少指令数量,提高加载效率。内存对齐要求矩阵维度满足特定倍数,避免跨越内存段的复杂访问,防止带宽下降。

共享内存的物理实现也影响访问效率。其被划分为32个内存银行,每个银行可并行响应一个线程请求。避免多线程访问同一银行引发冲突(Bank Conflict)是关键性能隐患。如矩阵乘法中,对另一矩阵采用行主存储布局,访问列方向时很容易发生银行冲突。通过在加载阶段对另一矩阵进行转置处理,将列访问转化为行访问,有效避免冲突,使访问达最佳带宽。 计算阶段,分配给单一线程的输出元素数目影响算术强度。

若一个线程仅计算单元素,算术强度有限。通过让线程计算多元素子块,且扩大切片尺寸,算术强度可显著提升。例如,16×16线程块处理64×64输出切片时,每线程承担4×4子块计算,AI值可提高至16,超越A100的计算界限,令计算过程完全绑定计算能力。 矩阵尺寸非切片尺寸整数倍时,边界线程块的计算存在浪费,GPU仍完成多余操作保障流程一致性,导致边界性能损失。此问题虽无法完全避免,但现代库通过零填充和条件变量减少无效计算影响。 计算资源方面,线程块内寄存器和共享内存资源的分配也决定GPU并发线程块数,进而影响延迟隐藏和整体吞吐量。

更大切片尺寸或更多寄存器使用会降低可驻留线程块数,降低线程池规模,减弱延迟隐藏效果,需要综合权衡调优。 线程发散问题同样影响计算效率。若warp内线程分支不同代码路径,执行序列化导致吞吐率下降。避免分支或使用无分支程序设计,保持warp内指令同步,是提升性能的有效方法。 数字精度降低即量化技术对性能提升影响巨大。FP16、BFP16等低精度格式减半内存占用,显存带宽利用率翻倍。

更重要的是,现代GPU支持低精度硬件加速,如Tensor Core,高精度FP32的理论运算速率倍受限制,而FP16操作可带来数倍甚至十倍提升,量化助力性能跃升,广泛应用于深度学习推理加速。 需要指出的是理论峰值性能受限于功耗调节和芯片温度等硬件因素,实际运行中常见低于标称指标,设计优化和调度策略至关重要。软件层面,编译器的自动寄存器分配、内存访问模式转换和指令融合优化都是提升性能的重要工具。 总体而言,GPU性能极大依赖于程序员对底层架构特征的理解和合理利用。共享内存的协同数据复用、避免银行冲突和线程发散、合理设计算术强度和线程块布局是确保高效执行的关键。随着硬件不断升级,相关编程模型和框架也在演进,深刻理解GPU的基本工作原理是掌握未来计算能力的基石。

。