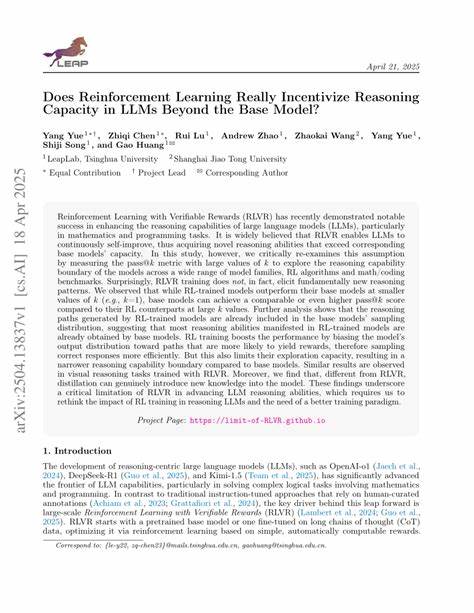

近年来,随着大型语言模型(LLMs)的广泛应用,如何进一步提升其推理能力成为人工智能领域的热门话题。强化学习(Reinforcement Learning,简称RL),特别是以明确奖赏信号为基础的强化学习(RL on Verifiable Rewards,RLVR),作为一种微调方法被广泛采用,以期使模型拥有更精准、更可靠的推理表现。然而,来自清华大学的最新研究给这一普遍认知提出了质疑,指出强化学习在提升推理能力方面可能并未超越基线模型,而仅仅是在采样频率上产生了调整,本文将对此进行深入剖析并探讨其广泛影响。首先,需要理解什么是基线模型及其推理能力。基线模型通过大规模预训练掌握了多样化的知识和潜在能力,其内部含有丰富的推理路径。然而,这些推理路径虽多,但在实际应用时可能表现出不稳定性和随机性,导致同一问题反复尝试下才可能获得正确答案。

强化学习的目标在于通过强化“正确”或“优质”回答的概率,使模型能更加稳定地输出正确推理结果。清华研究团队通过对比基线模型与经过强化学习微调的模型在数学推理任务中的表现,揭示了一个令人意外的现象:经过强化学习训练的模型在单次尝试(pass@1)中的表现优于基线模型,准确率明显提高,但在大量多次尝试(如pass@256)下,基线模型反而胜出。这意味着强化学习虽然使模型在少数尝试中表现更好,但却缩窄了模型可探索的推理路径范围。换言之,强化学习似乎“剪枝”了基线模型中较少被采样但依然有价值的思路,降低了模型的多样化选择。该现象被称为“推理边界变窄”,即强化学习使模型倾向于靠近某些特定的推理路径,从而牺牲了多样性和广泛性。更重要的是,研究团队通过对生成内容的困惑度(Perplexity)分析发现,经过强化学习优化的模型生成文本的困惑度显著低于基线模型。

这一结果表明强化学习基本上是在基线模型的能力范围内优化输出分布,而并非教会模型全新的推理能力或显著扩展其潜力。简而言之,强化学习更多是一种能力的“采样优化”,而非能力本质的演变。除了数学推理,研究还延伸至编码生成和数学视觉推理领域,发现这些领域中的强化学习效果仍然有限。此外,强化学习对于多步骤复杂任务可能带来较大提升的观点被多名评论者重点提及。理论上,如果一个任务需要连续正确完成多次中间步骤,基线模型随机猜测的成功概率极低,强化学习有可能显著增加成功率。然而,现有实验规模较小,尚无法充分验证这一假设,因此如果强化学习真的能催生“新能力”或“突现能力”,仍需更系统、更大规模的研究予以证实。

清华论文的结论引发了激烈的社区讨论,有学者质疑其结果是否普遍适用。有人认为强化学习的发展和实践远超论文中探讨的范畴,商业和前沿模型已经展示了其带来的明显能力提升和规模效应。另外,部分声音指出,强化学习引入的探索与利用平衡机制,使得模型在低样本时更倾向于稳健输出,长远看这可能是一种有价值的折中。也有观点强调,强化学习的“模态坍缩”(mode collapse)问题,即模型失去多样性,实际上是许多生成模型需要面对的普遍挑战,而非强化学习特有的问题。强化学习在大型语言模型能力建设上的作用如何,或许还需结合知识蒸馏、监督微调以及其它优化技术共同来看。值得注意的是,强化学习的效果和表现也可能受到模型规模、优化算法以及任务领域的影响。

清华团队测试的最大模型规模为320亿参数,未来对万亿级模型的研究可能揭示不同的规律。另一方面,强化学习引导模型更频繁地激活某些高质量路径,可能在实时应用环境中提升效率和可靠性,尤其是在有限尝试次数的情况下。这使得强化学习在工业应用层面仍具有不可忽视的价值。总结来看,强化学习对于提升大型语言模型推理能力的作用复杂且多面。它似乎更多起到了调整输出分布、提高少量采样效率的作用,而非根本创造新的推理能力或者大幅拓展模型的推理边界。该研究提醒业界应警惕对强化学习赋予过高期待,尤其是在没有充分验证的条件下推断其能够带来根本性突破。

同时,强化学习带来的多样性减少及潜在的模式坍缩问题需要引起注意,以避免模型能力的单一化和对复杂任务适应性的下降。未来的研究方向应聚焦于如何平衡强化学习带来的“可靠性”提升与“多样性”保留,探索能真正激发模型新能力的训练范式。同时,扩大实验规模,跨领域验证,整合不同优化技术,均是推动这一领域进一步迈进的关键路径。随着人工智能技术的不断演化,明确强化学习在大型语言模型中的真实作用,有助于科学规划模型训练策略,提升模型在多样复杂现实世界任务中的表现。行业和学界应审慎利用强化学习优势,坚持基于数据与实验的客观评估,避免陷入过度乐观的认知误区。只有通过系统、严谨的研究,才能真正揭示强化学习与基础模型之间微妙且深刻的关系,为人工智能的未来发展奠定坚实基础。

。