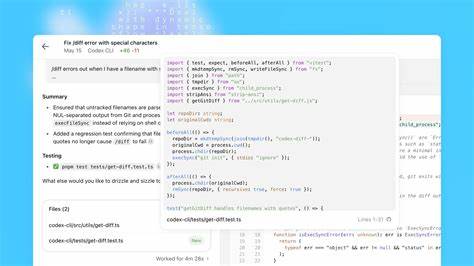

在现代医疗和科技融合的浪潮下,人工智能(AI)技术已逐渐进入心理健康领域,带来了前所未有的便利和效率。尤其是在心理治疗记录的书写方面,许多治疗师因繁杂的文档工作疲惫不堪,纷纷转向借助AI辅助的自动笔记软件以节约时间并提高效率。然而,这种表面上看似高效的服务背后,潜藏着对患者数据安全和隐私的重大威胁。近年来,科技公司不断推广基于AI的心理治疗笔记软件,这些软件不仅能自动整理治疗进展,还声称能协助诊断和治疗规划,但往往附带的条款却允许将患者的治疗记录数据用作训练其它AI应用的资源,甚至可能出售给第三方。这就意味着,患者最私密的心理健康信息,可能被匿名或去标识化之后,成为巨额人工智能产业的数据"饲料",带来伦理和隐私上的严重隐患。AI笔记软件如TheraPro,宣称为治疗师节省书写进展记录的时间,然而其用户协议则授予公司包含"非独占、可转让、可授权、永久、免版税和全球性"使用患者匿名治疗数据的权利,这其中包括用来训练任何人工智能程序。

更令人担忧的是,这些数据可能被第三方合作伙伴存储、访问和篡改,而软件公司则往往拒绝对这些第三方的行为承担责任。尽管所谓的"去标识化"数据技术被用来规避隐私保护法律,但研究显示,随着机器学习水平提升,匿名数据被重新识别的风险不断攀升,甚至有高达85%的准确率能够将数据重新关联到个体。这样的现实敲响了数据隐私保护的警钟。更多AI医疗软件开发商则在条款中披露类似广泛的数据使用许可,例如允许"复制、展示、披露、分发、出售及转授"等行为,一些公司承诺不会用数据训练其它AI,但缺乏明确监督机制和强制执行力。SimplePractice等厂商表示,当前不会存储患者治疗数据,但未来可能在用户可选择的前提下进行相关操作。这些软件的扩张与资本巨头对心理健康AI技术的投资趋势形成呼应,类似"机器人治疗师"Xaia等项目已经利用庞大的治疗记录数据训练,旨在提供完全自动化的心理治疗服务。

然而,自动化治疗的安全性、有效性和伦理问题仍未得到广泛认可,特别是在青少年与AI聊天机器人建立情感依赖甚至出现悲剧案例后,监管层面开始介入。美国联邦贸易委员会(FTC)最近针对AI聊天机器人安全性展开调查,重点关注机器人的设计缺陷可能诱发的心理危机事件。而美国心理学会(APA)的专家也强调,数字治疗工具应作为辅助而非替代传统心理医生,确保专业人士在治疗过程中发挥核心作用。面对这种局势,治疗师们需要谨慎评估第三方AI笔记服务的条款,权衡便利性与患者隐私保护的利弊。患者信息应得到更为严格的监管保护,确保其数据使用在透明且受控的环境中进行。治理机构也应制定相应法规,规范AI公司对健康数据的使用和商业化,保障患者权利不受侵害。

公众层面,提升对数字治疗隐私风险的认知成为当务之急,推动更多的行业自律和技术创新,如差分隐私及联邦学习等隐私保护技术,有望成为未来心理健康领域AI应用的关键保障。在智能时代,科技赋能带来了治疗方式的变革,也拷问着伦理与品格的边界。妥善处理AI与患者隐私的平衡,既是行业发展必经的挑战,也是保护人类尊严的基石。每一位心理健康服务提供者和用户,都应具备数字时代敏锐的隐私意识,共同呵护这一至关重要的信任纽带。 。