在软件开发和安全测试领域,模糊测试(Fuzzing)作为一种高效发现漏洞和缺陷的方法,正迎来新的技术革命。特别是随着大型语言模型(LLM)如GPT-4、Codex等的兴起,利用其强大的代码理解与生成能力,模糊测试的形态和效率正在发生深刻变化。本文将深入解析利用数十亿令牌进行的LLM模糊测试实践经验,探讨其在规模化过程中的关键技术点、挑战与未来趋势。 大型语言模型驱动的模糊测试,作为一种结合自然语言处理和程序分析的新兴技术,近年来备受关注。传统的模糊测试多依赖于命令行工具或脚本,通过对输入数据的随机变异或智能生成来发现程序潜在漏洞,然而这种方法在面对复杂语言特性和庞大代码库时,往往遇到性能瓶颈和覆盖盲区。LLM模糊测试则通过直接读取文档和代码,将模糊测试转化为基于模型理解和推理的自动化探索,显著简化了测试流程。

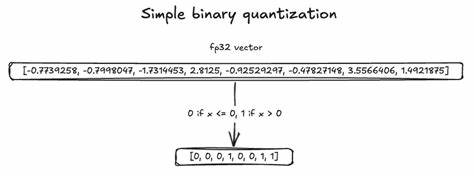

此前,TON Studio发布的研究指出,基于文档驱动的黑盒模糊测试在面对Tact语言等编程语言的文档时,展现出了初步的可行性。但随着技术进步,团队通过大规模实验验证了LLM模糊测试在耗费数十亿美元API调用额度下的真正能力与效率,累计处理超过140亿个令牌,并生成了数十万个代码片段用于编译器的压力测试。 黑盒模糊测试模式中,LLM仅借助文档信息进行测试任务,体现出简洁且易于规模化的优势。相比之下,利用Codex等模型进行的白盒模糊测试直接访问代码库,能够更主动地定位潜在缺陷,以更高的效率发现实际漏洞。实验结果显示,在Tact及其他多个开源项目中,白盒方法呈现出明显的漏洞发现率提升。 在测试过程中的挑战之一是海量检测结果的处理与去重。

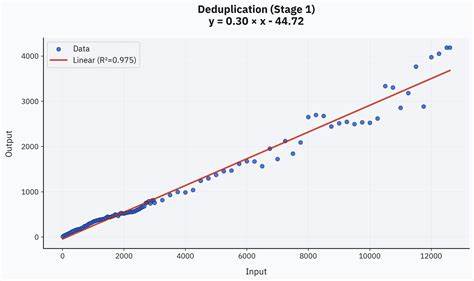

为了有效管理成千上万次测试产生的庞大数据,团队采用了两阶段去重和过滤机制。第一阶段基于生成的简洁总结及文本嵌入利用密度聚类算法快速筛选重复报告,极大提升了数据处理速度与准确度。第二阶段则结合先进LLM进行智能重复确认,确保人工复核时,审查人员面对的是高质量的独特问题集合。 这一去重过程不仅提升了评审效率,更降低了人工成本,使团队能够在有限资源下,深入分析模糊测试结果的质量和实际价值。手动审核环节中,根据发现问题的真实性、范围和价值进行分类,进一步清晰了模型在不同语言特性和场景中的表现差异。 大规模实验的数据显示,模糊测试的收益递减规律符合一种四分之一次方(quartic root)缩放曲线,即有效发现问题的数量随着总测试规模增加而缓慢增长。

与传统模糊测试的指数型饱和规律不同,LLM模糊测试通过并行化和主题广泛覆盖来克服效率瓶颈,因此建议优先进行多样化、针对性强的小规模测试而非单一任务的极端扩展。 模型选择在模糊测试效果中扮演关键角色。团队对比了多款领先模型,发现具备强大推理能力的中小规模模型如o4-mini在性能与成本的平衡上表现最佳。不仅仅是模型的价格或参数数量,模型的推理能力直接影响误报率及发现问题的准确度,是提升模糊测试整体效率的核心指标。 实践中,文档质量、语言特性复杂度及测试目标的规模均对结果有深刻影响。例如,对于较为标准的语言特征,模型通常能较准确生成有效测试用例;而面对区块链特有的地址或复杂合约结构,生成结果容易出现幻觉或误导,白盒测试中模型在面对庞大代码库时也会出现理解困难。

未来的研究方向聚焦于模糊测试流程的高度自动化与智能化。计划通过自动化代理再现发现的问题,同时联动GitHub自动检测重复缺陷并自动生成精简、结构化的issue报告,实现真正的零人工干预模糊测试闭环。此外,利用API额度充足且具备高响应频率的模型,可在数十个甚至数百个并行容器中同时进行白盒模糊测试,大幅提升发现效率。 总结来看,基于LLM的模糊测试已证明其在工业规模应用中的可行性与优越性。虽然仍面临模型去重参数调优和大规模数据饱和问题的挑战,但通过合理分配测试预算、精细化设计测试主题、以及高效的去重复机制,该技术展现出极佳的经济效益与实践价值。随着模型能力不断进步和测试自动化程度的提升,LLM模糊测试必将在软件安全和质量保障领域发挥越来越重要的作用。

总而言之,从理论到实践,数十亿令牌的投入不仅验证了LLM模糊测试的扩展能力,也为软件工程师和安全测试人员提供了新的技术路径和工具思路。接下来的发展将更多依赖跨模型融合和工作流自动化,助力构建更安全、稳定的软件生态系统。