随着人工智能(AI)技术的飞速发展,尤其是以自然语言处理为代表的大型语言模型(LLMs)的兴起,医疗界对AI在临床实践中的应用充满了期待。尤其是在新冠疫情加速数字医疗和远程医疗发展的当下,AI被视为提升诊疗效率、减轻医生负担以及改善患者体验的关键利器。然而,AI研究如何真正走出实验室,融合进复杂多变的临床环境,实现有效且安全的临床应用,仍面临诸多挑战。 人工智能在医疗领域的应用价值体现在多个方面。从疾病早期诊断、精准治疗方案的推荐,到个性化医疗管理,AI技术可以挖掘海量数据中的潜在信息,加速临床决策过程。例如,大型语言模型如ChatGPT已经能够通过模拟临床问答,辅助医生更快速地回应患者的问题,提高信息传递的效率。

然而,表面上的优异表现掩盖了许多细节问题,临床多样性和复杂性远超AI在标准化测试中的表现。 当前,许多AI模型在标准化的多项选择题测试中表现优异,甚至通过了诸如美国医学执照考试(USMLE)等专业测试,这些结果一度引起医学界的极大关注和热议。然而,实际上,这类考试的形式与真实临床环境有显著差别,更多依赖于固定答案和流程,但临床实践中面对的是复杂且充满不确定性的病症,需要综合多维度信息做出合理判断。近期研究显示,尽管AI在考试中成绩突出,但在处理真实患者咨询时,模型仍可能出现错误推荐,甚至提供不适当的治疗方案,这些错误在临床环境中可能带来严重后果。 这种现象反映出一个关键问题:AI研究聚焦于“基准测试”上的优异表现,而忽视了如何针对临床实际需求构建更具代表性和实用性的评价指标。传统的基准测试往往由开发者主导,缺少临床医生和患者的有效参与,导致模型性能难以在真实世界中普遍适用。

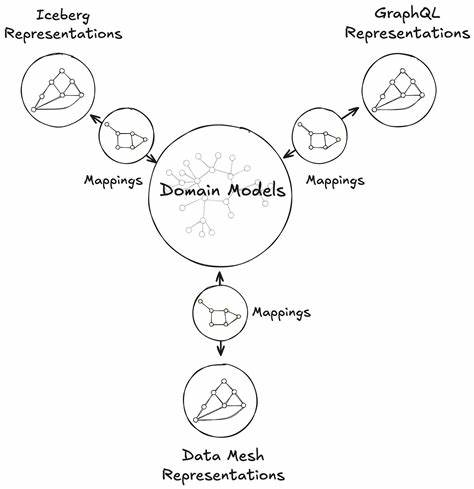

比如同一模型对药物的反应可能因使用药品的通用名称或品牌名称而不同,这种细微差异在基准测试中往往被忽略。 为了桥接这一差距,临床专家与计算机科学家的跨学科合作显得尤为重要。临床医生可以基于临床流程和患者需求,设计真实任务,构建有针对性的评测数据集,并设定临床认可的性能阈值,推动模型向真正满足临床需求的方向发展。计算机科学家则需确保评测体系的科学性、可测量性和安全性。这样双向协调合作,才能打造既具技术先进性又符合安全规范的医疗AI系统。 另一个亟待解决的问题是AI技术迭代迅速,而医疗界对新技术的导入和应用通常需经历严格的测试、监管以及伦理审查。

虽然过度拖延会影响技术的推广和应用速度,但过快上线未经充分验证的工具,可能导致医疗风险和误诊误治,最终损害医疗系统和公众对AI的信任。例如,某些临床试点项目发现,AI辅助回复患者咨询虽然提升了医生的工作效率,但其中错误信息的传播风险仍需认真对待。 因此,推行低风险的、人机协作的应用场景显得尤为关键。在这些场景下,AI作为辅助工具,医生拥有最终审核权,能够及时纠正错误,保证医疗安全。同时,开展模拟真实临床环境的预临床试验,对于检验AI工具的实用性和安全性至关重要。这不仅能发现模型潜在漏洞,也为后续改进提供宝贵依据。

此外,医疗AI的评估标准可借鉴现有的医学研究伦理与监管体系,通过风险分级方法,针对不同临床领域和应用案例设计差异化的验证流程。这样既保障了患者安全,也兼顾了创新的速度和灵活性。在未来,更深层次的变革还需重新思考和优化医疗数据的采集、结构化和应用方式,为AI治疗提供更丰富、准确的数据基础。 当前,临床医生与计算机科学家依旧存在学科壁垒,分别活跃于不同的学术会议和研究社区,交流合作机会有限。促进双方的深度融合,需要通过多学科联合的会议、共同期刊以及跨领域研究项目,营造更多的协作平台和机会。政策制定者和资助机构也应提供相应激励措施,鼓励促进临床参与的AI研发和应用。

作为临床一线的医生,拥有对疾病理解的深刻洞察力和对患者需求的敏感把控,是任何AI工具难以替代的优势。医生们应积极参与AI从设计、测试到临床集成的全过程,承担起识别医疗痛点、推动技术合理使用的领导角色。同时,临床医生的参与也能推动技术公司更加注重产品的安全性、透明度及患者权益的保护,从而助力医疗AI真正造福患者和医护人员。 总的来说,要实现AI技术从研究成果向临床实践的转化,必须构建起以临床需求为导向的评估体系,推动人机协同的安全应用,并打破学科壁垒促进多方协作。未来,随着技术的持续成熟,与医疗工作流程紧密融合的智能辅助诊疗工具将帮助临床医生减轻负担、提升治疗精准度,推动医疗行业进入一个崭新的智能医疗时代。只有这样,人工智能才能从一项技术创新,真正转变为改变医疗格局的强大力量。

。