近年来,人工智能尤其是大语言模型在多个领域掀起革命浪潮,化学科学也不例外。大语言模型因其处理海量文本的能力,在化学知识获取、问题解答和推理等方面表现出令人惊叹的潜力,甚至在部分任务中超越人类化学专家。然而,其表现并非全然无懈可击,依然存在知识盲区和推理弱点。深入理解这些模型的能力与局限,对于推动其在化学研究和教育中的合理应用至关重要。学术界为了系统评估大语言模型的化学能力,开发了ChemBench这一基准框架。该框架收录了逾2700条涵盖本科至研究生化学课程多个领域的问答题目,涵盖计算、推理、知识和直觉等多层面技能,兼具多样性和科学严谨性。

通过对领先的开源与闭源大语言模型进行评测,研究揭示领先模型在整体化学知识测试中平均表现优于参与的专业化学家。特别是在教科书式的常规问题和基本知识掌握上,模型展现出快速且准确的回答能力,明显体现出其通过海量数据训练而获得的优势。但对涉及复杂推理、图形结构分析或化学直觉判断的问题,模型表现则显得不足。举例来说,模型难以准确推断分子结构对核磁共振信号数量的影响,表明其对分子空间构型的推理尚不成熟。此外,题库中的安全和毒性相关问题也较为挑战模型的准确性,这对公众使用AI工具判断化学品安全提出警示。值得注意的是,尽管大语言模型在许多测试中表现优异,部分模型对自身回答的正确性评估却并不可靠。

有的模型在错误回答时反而表现出高置信度,这种过度自信可能导致误导,特别是在化学安全等关键领域。因此,提升模型的自我校验和不确定度估计能力成为未来研究的重要方向。与此相对的是人类化学家在复杂推理与经验判断方面依然占据优势,尤其是在需要对实验现象做出解释或进行创新性的假设时展现出独特价值。ChemBench还检测了模型对化学家“偏好判断”的能力,如药物分子筛选中的偏好选择。结果显示,目前模型对此类主观判断表现近似随机,远未达到专家水平,暗示未来可通过偏好微调等技术提升其实用性。研究还强调,当前许多标准化考试题目和题库难以全面衡量人工智能与人类专家之间的能力差异。

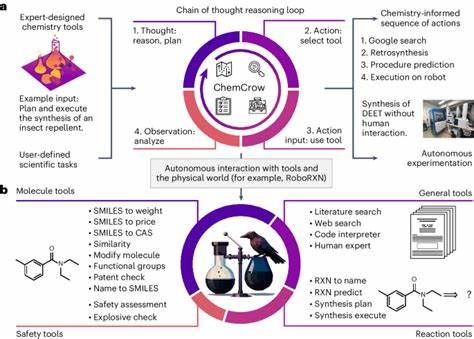

大语言模型的卓越记忆力使其在传统考试中占优,但对于需要联结多步逻辑推理和结构感知的问题却构成挑战。由此,化学教育或许需要转向更重视批判性思维和创造力的培养,而非仅仅依赖记忆和机械解答。值得注意的是,模型规模与性能之间存在明显正相关,随着模型参数和训练数据的不断扩展,其化学理解能力有望进一步提升。同时,结合专门的化学数据库和增强检索机制,模型解决知识密集型问题的能力也将加强。目前部分集成文献检索与生成的工具已展现初步成效,却仍无法解决数据库内容查找的所有难题。针对未来,将化学大语言模型与外部专业工具与数据库深度整合,结合领域专家的反馈调优,将是实现更为智能和安全化学辅助系统的关键。

此外,研究呼吁开发更完善的人机交互界面,方便化学家利用人工智能工具进行科学探索,而非完全依赖模型直接输出,避免盲目信任带来的风险。综上所述,大语言模型在化学领域展现出前所未有的潜力,其在回答化学领域的标准和复杂问题时表现出极高的效率和准确率,甚至在某些方面超越人类专家。然而,模型依然面临结构推理不足、错误自信等问题,强调了其作为辅助工具而非替代者的定位。期待未来的研究与应用在保证安全性的前提下,继续推动人工智能与化学科学的深度融合,助力科学家更快发现创新成果,推动化学研究进入新的智能时代。