2025年7月,Reka 公司发布了备受期待的Reka Flash 3.1,这是一款基于21亿参数的推理模型,经过强化学习技术的深入优化,显著增强了模型在编码和代理任务中的表现。作为Rela Research的核心引擎,Reka Flash 3.1不仅实现了大规模训练的技术突破,更以其强大的代码处理能力和智能规划能力,成为理解复杂问题的强大工具。这一升级版本标志着在人工智能技术尤其是强化学习领域的重要进步,开启了更广泛、更智能化应用场景的大门。 强化学习作为机器学习的重要分支,其核心是通过不断试错和奖励机制引导模型学习最优策略。Reka Flash 3.1采用了一种经过改良的REINFORCE算法变体,该算法集成了动态采样机制,能够在训练过程中有效调整采样策略,提升样本利用率和训练效率。与此同时,模型在计算损失时细致到token(词元)层面,使得反馈更加精准,帮助模型捕捉细微的语言和代码结构差异。

此外,智能梯度剪裁技术依照有效梯度范数动态调节梯度,避免梯度爆炸或消失,保障训练过程的稳定性。 长序列数据训练中,Reka Flash 3.1借鉴并改进了类似DAPO的策略,有效处理长样本带来的梯度和效率挑战。这种细致的样本处理机制让模型在面对复杂任务时依旧表现出强大的理解和生成能力。更重要的是,训练严格遵循on-policy原则,即在每次策略执行后即刻进行权重更新,这种实时反馈机制极大提升了模型稳定性和性能表现。为了进一步保证训练的多样性和效率,Reka Flash 3.1精心设计了样本分配,避免强化学习样本与监督微调样本的重叠,确保模型能够不断探索并评估负面轨迹,从而提升其决策能力。 数据层面,Reka Flash 3.1在公开版本中注重使用可验证奖励信号,尤其基于数学和代码两个核心领域。

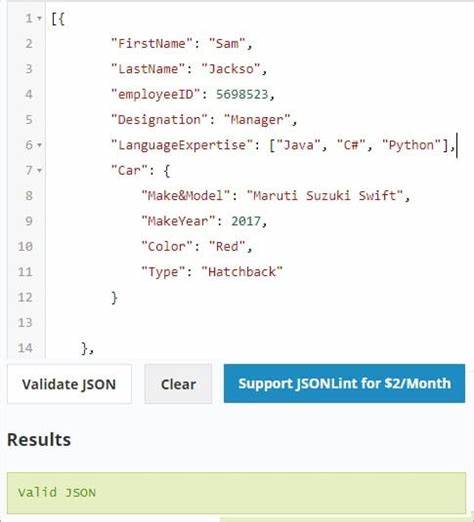

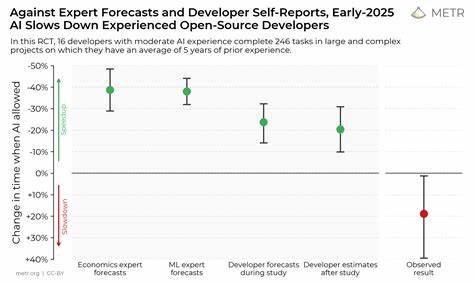

数学数据源自Numina-1.5,经过严格筛选,排除无效答案、重复实例及过于简单或难以验证的题目,确保奖励信号的准确可靠。模型还将多选题转换为填空题形式,避免因奖励设计漏洞导致的模型作弊现象。代码范畴则聚焦于难度较高的编程问题,配备多个测试用例以全面评估模型生成的代码有效性。值得一提的是,模型在执行代码时采用分布式执行架构,确保在每条轨迹完成后即可开始代码运行,从而大幅提升训练速度和资源利用率。 从性能表现来看,随着训练进度的推进,Reka Flash 3.1在AIME2024和LCB-v5等竞赛数据集上展示了显著的提升。其强大的代码理解和生成能力,使其在解决复杂问题时准确率和效率均超越了众多开源及闭源模型。

这种稳步向上的表现不仅奠定了Reka Flash 3.1在学术界的地位,更为实际工程应用提供了坚实保障,推动相关技术在软件开发、自动化代理及智能问答等多方向深化应用。 针对开发者和研究者,Reka Flash 3.1保持了良好的兼容性。其以Llama格式发布,方便与现有生态系统无缝衔接。无论使用Hugging Face平台还是vLLM等开源工具包,用户都能快速部署并运行该模型,实现功能扩展与定制化开发。这种开放且标准化的策略,使得Reka Flash 3.1不仅限于内部研究,更成为推动行业创新的利器。 展望未来,Reka Flash 3.1的强化学习框架具备极大潜力。

它不仅仅是一种模型升级,更是一套完整的训练体系和产品设计理念,强调数据质量、训练稳定和实时反馈的综合优化。随着人工智能对复杂任务和多模态信息处理需求的增加,Reka Flash 3.1有望通过持续优化算法、丰富训练数据和增强推理能力,助力开发更加智能、灵活和高效的AI代理。 同时,Reka 也在积极探索强化学习结合其他先进技术的可能性,如元学习、多任务学习及自监督预训练,旨在进一步提升模型的泛化能力和适应性。随着生态圈的不断发展,更多基于Reka Flash 3.1的创新应用将在教育、科研、企业服务等领域涌现,满足多样化、高复杂度的实际需求。 整体而言,Reka Flash 3.1凭借其强化学习技术和优秀的代码处理能力,为AI领域树立了技术标杆。它不仅推动了智能编码的前沿,更为代理AI的自主规划和执行奠定了坚实基础。

相信在Reka Flash 3.1的带动下,智能化工具的应用将更加普及和高效,引领人工智能迈向智能与自主的新纪元。