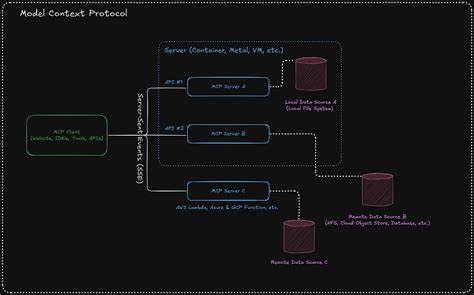

随着人工智能技术的迅速发展,特别是大规模语言模型(LLM)的广泛应用,提升对话系统的响应效率和准确性成为行业关注的重点。MCP(Modular Content Protocol)作为一种新兴的协议,因其独特的资源管理设计,在优化提示词的使用和缓存机制中发挥着至关重要的作用。在当前的技术环境下,理解和合理运用MCP资源对于实现更高效的检索增强生成(RAG)系统,以及有效利用模型上下文和令牌预算,显得尤为重要。 MCP资源的设计初衷是解决缓存失效和重复数据的问题。在传统的对话系统中,提示词和上下文内容常常会被反复作为令牌输入模型,造成令牌预算快速消耗且无法充分利用已有的数据积累。MCP资源通过引入资源标识符(URI),实现了对大体量文档的去重管理,使得系统能够智能识别和缓存之前使用过的内容,避免重复载入。

这不仅优化了令牌的使用效率,也极大提升了模型在提供相关信息时的准确和速度。 事实上,RAG文档普遍体积庞大,频繁重复传递完整文件不仅浪费资源,还严重影响系统性能。通过MCP的资源缓存机制,系统可以将查询结果仅以资源ID的形式传递给模型,而全文内容则作为参考保存在客户端或缓存层,模型请求时可根据需要动态加载相关内容。这种做法有效减少了上下文中冗余信息的数量,保障了对话的连贯性和信息的新鲜度。 MCP资源的另一个优势在于它促进了客户端与模型之间的协议解耦。客户端不需直接将完整的MCP对象输入模型,而是通过将资源映射到特定的、模型训练过程中熟悉的表达形式,提升语言模型对工具调用结果的理解效率。

例如,将资源URI转换成模型易解读的短语或指令格式,从而发挥模型训练优势,达到更精准的响应效果。 目前不少主流AI平台,例如Anthropic和OpenAI,其API尚未全面支持MCP资源,这一现象凸显出行业内对MCP实现的技术门槛和关键性认识差距。MCP资源功能不仅仅是列举文件目录这么简单,核心目的是为了提升资源的复用和缓存效能,使得用户在进行复杂的查询和生成任务时,能够在有限的上下文容量内最大化信息量,从而更符合生产环境中对高效交互的需求。 从工程角度看,缺乏对MCP资源支持的客户端本质上未能实现真正成熟的协议标准,限制了其应用潜力。对于开发者而言,搭建一套具有缓存管理、资源去重及动态映射能力的MCP客户端,虽然技术挑战不小,但其带来的性能和用户体验的提升是显而易见的。正如业界知名人士所言,一个合格的MCP客户端必须支持资源功能,否则就无法胜任复杂的RAG系统需求。

此外,MCP资源缓存机制对于节省存储、带宽和计算成本也有直接贡献。在不重复加载大型文档的情况下,系统能够减少对网络和硬件的压力,提高响应速度和稳定性。对于需要频繁调用多源信息的大型应用场景,包括知识检索、智能问答及自动化文档分析,合理利用MCP资源缓存无疑是一种有效的优化路径。 近年来,随着开源社区对MCP协议的关注逐步增长,已有初步的参考实现出现,为开发者提供了实践范例和工具支持。通过快速部署和试验,团队可以验证缓存逻辑和资源管理的有效性,促进技术积累和经验分享,进一步推动行业对MCP标准的认可和广泛采用。 综上所述,MCP资源不仅是一种缓存手段,更是连接语言模型与外部工具之间的桥梁。

它帮助系统避免冗余数据的反复传递,通过智能资源标识和映射机制,提升了对话模型的响应效率和生成质量。未来随着更多平台引入资源支持和更完善的MCP生态构建,相信缓存管理将在人工智能交互领域发挥越来越重要的作用,推动智能系统向更高效、更智能的方向发展。