随着人工智能技术的不断进步,拟人化对话代理逐渐走进我们的视野,成为连接人类与机器交互的桥梁。大型语言模型(LLM)作为这类技术的核心,展现出惊人的沟通能力,能够以近乎人类的方式进行交流。然而,这种“拟人化”的人工智能也让人们陷入了对其益处和风险的深刻反思。本文将围绕拟人化对话代理的优势与危害,全面探讨这项革新技术的意义与影响。大型语言模型依托海量数据及深度学习技术,具备生成各种文本的能力,能够写出极具说服力和感染力的文章,甚至在很多场合能够超越一般人的表现。它们不仅能够准确捕捉用户的情绪和意图,还能灵活地模仿不同的角色和语言风格,这使得交流体验更加自然和亲切。

拟人化对话代理通过模拟人类语言及行为,极大地提升了交互的沉浸感和亲和力。在教育领域,这种技术能够成为个性化的辅导老师,针对学生的需求调整教学内容和难度,增强学习效果。在医疗健康领域,它们能够辅助心理咨询,提供情感支持甚至行为激励,帮助患者更好地管理健康。在商业应用中,通过自然语言与客户互动,拟人化对话代理提高了客户满意度,促进了销售转化并降低了人力成本。与此同时,拟人化对话代理还促进了信息获取与传播的便捷性。曾经复杂难懂的专业语言,通过这些AI代理转化为易懂、贴近用户需求的表述,让更多人能够顺畅理解和使用相关服务。

此外,这类代理还在娱乐和社交等领域获得广泛应用,为用户提供陪伴和互动,缓解孤独感,丰富精神生活。尽管拟人化对话代理展示了强大的能力和广泛的应用前景,但也不可忽视其潜在的危险和挑战。首先,人工智能的不理解和无意识带来了“拟人化诱惑”,即用户误以为机器拥有情感、记忆甚至意识,产生过度信任。这种误判可能导致情感依赖、隐私泄露甚至心理伤害。其次,这些智能代理拥有强大的说服力和模拟能力,有可能被滥用进行大规模的虚假信息传播、政治宣传或诈骗行为,极大地威胁社会信任和信息生态的稳定。此外,拟人化对话代理在隐私保护方面存在隐忧。

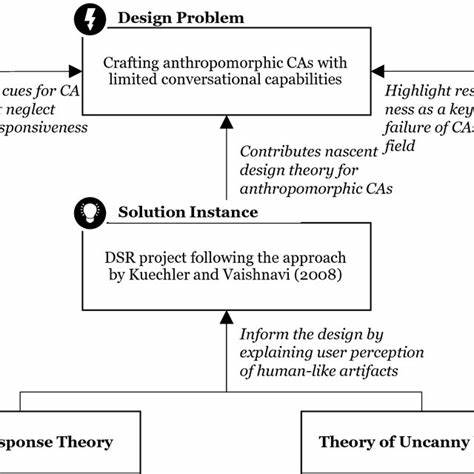

为了实现个性化与情感匹配,系统可能需要收集和分析大量个人信息,若安全措施不到位,用户数据易遭滥用或泄露。伦理层面问题也日益凸显。如何确保AI的行为符合道德规范、避免引导用户产生误导或偏见,是开发者和监管机构亟需解决的难题。面对利弊并存的局面,应当采取多元化措施保障拟人化对话代理的安全、可靠和合规发展。设计上需强调“去人性化”原则,避免过度模仿和情感渲染,让用户清晰意识到交互对象为人工智能而非真人。同时,需要建立完善的透明机制,明确告知用户其正在与AI对话,增强辨识能力和警觉心。

技术治理层面,应设立专门评测体系,量化AI的拟人化程度及其潜在风险,促进技术合理创新。监管政策需紧跟技术进步,明确数据隐私保护、虚假信息防范及责任归属等法律框架,加强对产业链各环节的监督。公众教育也至关重要,应普及人工智能知识,提高用户的信息素养和自我保护意识,从而有效抵御拟人化诱惑带来的负面影响。未来,拟人化对话代理将持续推动人机交互模式的革命,潜力巨大。其能够促使科技更加贴近人性,提升普惠性与包容性,为社会经济发展注入新活力。然而,在享受其便利的同时,我们必须保持警觉,科学理性地应对潜藏的风险,确保技术造福于人类而非带来伤害。

科技的力量需被正确引导,只有在设计、使用及监管多方协同下,拟人化对话代理才能健康成长,成为推动社会进步的正向力量。综上所述,拟人化对话代理以其卓越的语言表达和交互能力,开辟了人机交流的新纪元。它在教育、医疗、商业及娱乐等领域展现出巨大价值,但与此同时,亦带来了信任误导、隐私风险和道德困境等诸多挑战。面对这把“双刃剑”,业界和社会需积极探索科学合理的利用路径,推动技术在人性化与安全性之间取得平衡。唯有如此,拟人化对话代理才能真正成为赋能未来数字社会的重要角色,带来福祉而非隐患。