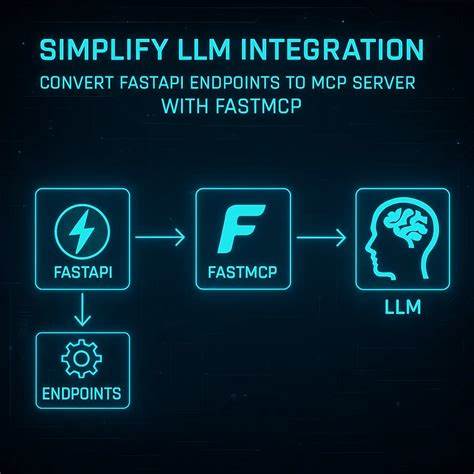

随着人工智能技术的不断发展,智能代理和自动化系统的需求日益增长。Model-centric programming(模型中心编程,简称MCP)作为一种新兴的设计理念,帮助开发者将各种AI工具和服务有机结合,实现跨系统的智能交互。而在众多搭建MCP服务器的方法中,使用FastAPI结合FastMCP显得尤为便捷与高效,能在最大程度上减少重复开发工作,快速将现有API变身为智能代理触发的工具接口。FastAPI作为近年来流行的Python异步Web框架,凭借其性能优异、类型注解友好和生态完善的特点,成为许多后端项目的首选。而FastMCP作为专为FastAPI设计的高层封装工具,利用其自动解析路由和数据模型的能力,帮助开发者轻松导出符合MCP规范的服务,使FastAPI应用直接对接Claude、Cursor等AI代理,降低了入门门槛。构建一个基于FastAPI与FastMCP的MCP服务器,首先需要准备好现有的FastAPI项目,本文以“APItizing Burgers”示例项目为案例介绍整个流程。

只需克隆项目源码,配置Python虚拟环境并安装所需依赖,便可快速启动测试环境。随后安装FastMCP包,通过简单几行代码即可将FastAPI应用转化为MCP服务器,无需重复定义接口逻辑或数据模型,极大地节省了时间成本。完成代码编写后,借助Claude Desktop等基于模型的代理客户端,只要轻松配置运行环境变量及依赖,就能立即在交互界面中得到FastAPI路由对应的工具列表。用户通过自然语言调用这些工具,实现与API的智能交互体验。FastMCP不仅支持基本的工具暴露,还能通过配置重命名工具、调整超时参数或基于路由模式过滤不需要的接口,提供一定程度的灵活定制。此外,FastMCP能完美继承FastAPI的依赖注入、中间件机制和认证策略,保证MCP层具备原有API的安全性和数据校验能力。

但另一方面,FastMCP作为“黑盒”解决方案,底层的组件生命周期管理和资源处理逻辑不会公开,给深度调试和复杂定制带来一定难度。相比之下,另一种流行工具Speakeasy则通过解析OpenAPI文档生成多语言SDK和MCP服务器,虽然起步较慢,但生成的代码结构清晰,维护和扩展更为便捷。Speakeasy支持通过OpenAPI扩展标记灵活控制各个接口的导出状态、作用域定义以及描述信息,实现对MCP工具的细粒度管理。此外,Speakeasy的体系更适合对版本控制和代码透明度有高要求的项目,且支持将生成的MCP服务器打包发布,方便团队协作和多环境部署。综合来看,FastMCP具备快速集成、轻量部署、零额外接口定义的优势,适合初期尝试MCP或对现有FastAPI项目进行快速MCP适配。而Speakeasy更适合成熟团队采用基于规范驱动开发的方法,保持代码可控性和多语言扩展性,为长期维护提供保障。

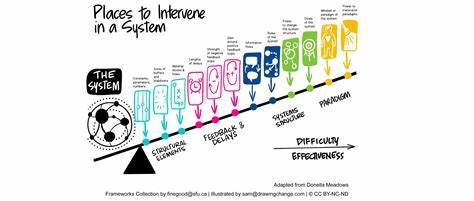

通过合理选择工具,开发者能够根据自身项目规模、维护需求和团队背景,打造兼具性能和灵活性的MCP服务。部署阶段中,FastMCP偏向于本地开发和Claude Desktop集成,部署配置主要围绕依赖安装、PYTHONPATH环境设置和命令行脚本管理。与之对比,Speakeasy生成的TypeScript MCP服务器适用于容器化部署、云服务托管和npm包发布,具备更完善的分发方案。在测试环节,只需打开Claude Desktop的搜索工具面板,即可看到已配置的MCP服务器和对应工具。此时通过自然语言发起对API的调用,系统可以在后台智能转换为对应的FastAPI接口请求,实时返回准确的业务数据。此外,结合FastAPI本身的异步能力,MCP服务器可保证在高并发环境下的稳定响应,满足实际生产需求。

未来,FastMCP与FastAPI的结合将会进一步优化交互流程,提升调试效率和工具定制深度。同时,随着OpenAPI标准的普及和MCP规范的完善,各类生成工具也会陆续支持更多扩展能力,促进AI代理生态的蓬勃发展。对于入门开发者来说,建议先尝试FastMCP快速体验MCP的优势,掌握基础配置和部署技巧后,再根据项目需求探索Speakeasy的强大定制功能。总而言之,利用FastAPI搭配FastMCP构建MCP服务器提供了一条简洁的路径,帮助开发者将API快速升级为智能代理可调用的工具接口,无需重写业务逻辑,实现现有资源的最大价值释放。伴随生态的不断成熟和工具链的丰富,MCP服务器将成为连接人类指令与AI执行间不可或缺的桥梁,推动智能应用向更广泛和深入的场景拓展。