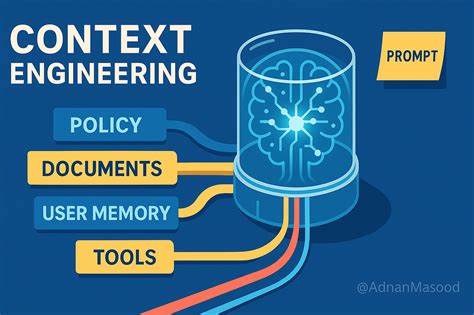

人工智能的进步极大地改变了我们与技术互动的方式,尤其是在语言模型(LLM)领域。最初,提示工程被视为引导模型产生期望输出的关键方法,用户专注于如何设计精准简练的提示语来最大化模型的响应效果。虽然这在处理简单任务时表现突出,但随着AI应用转向更加复杂和多步骤的流程,提示工程受到了显著的限制。上下文工程作为一种新兴的技术理念,应运而生,成为提升AI产品智能化和实用性的核心环节。上下文工程的核心思想是将传统提示语之外的所有输入信息视为整体工程系统的一部分,涵盖动态信息采集、记忆管理、工具调用以及输出格式控制。它强调对整个上下文窗口的精心设计与管理,就像操作系统管理电脑的内存一样,确保语言模型在有限的“记忆空间”内获得最具相关性、实用性的信息。

相较于单一的提示语优化,上下文工程更像是一项系统架构工作,需要协调多元信息源和复杂工作流程。首先,理解上下文在AI智能代理中的多维度含义至关重要。上下文不仅包括核心的行为规则、示范案例以及提示模板,还涵盖可调用的工具定义、预设输出模式和用户的即时输入。除此之外,亦涉及到短期和长期记忆的有机整合,通过历史对话、持久性知识和外部数据库检索结果来不断丰富模型的理解和推理能力。通过这些多层次的上下文维度有机协同,AI系统能够在复杂任务中表现出连续性和针对性,更好地满足用户需求。面对复杂的AI代理系统,传统提示工程的局限体现为无法有效处理长时间、多步骤的推理任务,也难以动态调度多工具协作和信息检索。

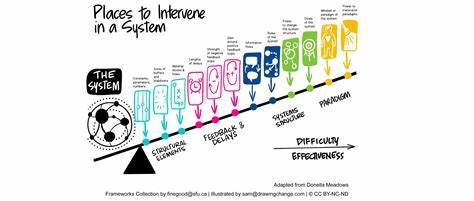

上下文工程为此提供了理想的解决框架,能够显著优化令牌的使用效率,减少信息冗余和矛盾,规避由于上下文管理不善引发的产出错误、成本飙升和处理延迟。成功的上下文工程不仅能提升模型的可靠性和结果一致性,更能增强整体的用户体验和信任感。例如,在一位用户询问日程安排时,只有结合完整的日历信息、通信习惯以及关键联系人资料,AI代理才能提供精准且个性化的建议,而不是简单的模糊回复。实现高效上下文工程的关键策略包括写入及存储有价值的信息、智能选择并调取最相关的数据、对上下文内容进行压缩精简,以及通过架构设计实现上下文的隔离与模块化管理。写入策略主张将重要信息保存在上下文窗口之外的存储中,如文件系统或运行时状态,以节省有限的令牌空间。智能选择技术利用嵌入向量和相似性检索,在海量记忆中精准定位相关内容,避免信息过载和模型混淆。

压缩则侧重于利用自动摘要与剪裁技术,将冗长历史转化为浓缩且高价值的简报,确保上下文时刻保持紧凑。模块化的架构设计则通过多代理系统或沙盒环境分担任务,每个代理负责独立的上下文内容,降低复杂度并强化协同效率。这些策略综合推进,使得AI系统能有效管理数万至数十万令牌的上下文,从而支持高度复杂的推理和决策过程。对于产品团队而言,投资上下文工程不仅仅是技术优化,更是市场竞争力和用户满意度的重要保证。良好的上下文管理显著减少因信息混乱导致的模型错误,降低因上下文溢出而产生的巨大成本,提高响应速度,增强产品的稳定性与个性化服务能力。由此可见,未来的AI产品开发应当超越对单一提示的追求,将上下文工程纳入核心架构设计,打造具备深度理解和多层次推理能力的智能代理系统。

总结而言,随着AI应用的日益复杂,单纯依赖提示工程显然不足以应对多变的实际需求。上下文工程作为新时代的核心技术,将引领智能系统进入更高效、更精准的阶段。掌握上下文工程的策略和技巧,成为AI领域产品开发团队的必备能力。就像管理电脑内存对计算性能的影响一样,科学的上下文管理决定了AI产品的成败。未来,只有那些能够在动态信息整合、记忆管理及工具协调上做出创新和优化的团队,才会在激烈的市场竞争中脱颖而出,赢得用户的青睐与信任。