层次神经网络(Hierarchical Networks,简称H-Nets)作为深度学习领域一个重要的发展方向,近年来因其在长序列建模和多模态数据处理中展现出的巨大潜力而备受关注。本文将对H-Nets的诞生背景、技术核心、迭代演进以及未来可能的研究和应用方向进行全面而深入的探讨,力图帮助读者理解其革命性的意义和前沿突破。 层次结构的理念源远流长,几乎遍布于自然界和认知科学的各个层面。人类认知中的“分块”(Chunking)效应揭示了大脑如何将海量信息进行有序抽象与分类,形成词语、短语、句子甚至更高层次的语义单位。类似地,层次神经网络便试图通过构建分层的数据处理框架,模拟这种由低级到高级的抽象机制,从而改善序列数据的长程依赖建模问题。 H-Nets项目的创始人之一,Albert Gu博士,在深度学习和序列模型研究方面颇有建树。

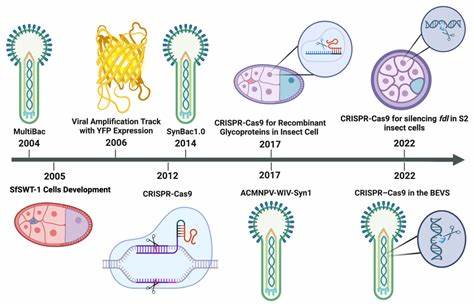

早在攻读博士阶段,他便致力于探究层次化建模如何提升RNN(循环神经网络)的表现,尤其关注通过隐式层次结构来增强长距离信息的捕捉能力。此后,凭借对状态空间模型(State Space Models,SSMs)和连续时间序列的深刻理解,他在S4模型的开发中引入了层次结构思想,并验证了其在图像和音频数据中的优越效果。 H-Nets的重要突破在于试图将层次划分和动态分块机制引入端到端的训练体系。传统的分块策略多依赖固定大小的窗口或者预先设计的分割规则,往往难以充分适应语言等复杂离散数据的非均匀性质。H-Nets通过借鉴混合专家机制(Mixture-of-Experts,MoE)思想,实现了一种可微分的选择器(Router),能够根据当前上下文动态分配信息流,进而产生灵活且内容相关的块边界。该机制不仅带来了更加自然的数据抽象,还为模型的可扩展性和稳健性提供了助力。

在实践中,H-Nets应用了自回归U-Net结构,逐层抽象和聚合信息。U-Net本是一种在图像分割领域大放异彩的结构,通过对称的下采样和上采样路径,优化了空间信息的传播。然而,Gu团队发现这类结构在语言建模中表现不佳,主要因为语言的离散性和非均匀间隔不适合传统的定宽池化。然而,当应用于具有固定采样率的数据如音频时,H-Nets表现出极高的建模能力,成功压缩噪声成分并突出关键信息,实现了高质量的生成效果。 此外,信息量作为分块标准的理念在H-Nets设计中扮演了关键角色。通过训练网络估计每个时间步上的负对数似然,模型能够根据预测不确定性的变化识别可能的分块边界——例如词语的起始位置通常伴随着较高的信息熵,从而触发新块的开始。

这种信息驱动的分割方法使得模型对语言和信号中的内在结构有更深的感知,超越了传统的基于固定规则的划分方法。 在研发过程中,团队也面临了诸多挑战,如如何解决离散边界选择问题的可微分训练困境。此前相关研究如Hourglass Transformer和Dynamic Pooling Transformer曾尝试使用Gumbel-Softmax技巧进行软化离散判断,但存在训练不稳定和性能限制。H-Nets在此基础上融入了更多现代技术,如归一化策略、残差连接以及多阶段递归机制,逐步提升了训练效果和模型稳定性。 H-Nets与Byte Latent Transformer(BLT)等同期模型在定位端到端动态分块问题上存在异同。BLT采用基于熵的启发式分隔规则,能较好地实现分块,但不足以实现真正的端到端学习。

相比之下,H-Nets通过路由模块实现了动态且可学习的分块策略,更加适应复杂多变的数据结构。 从架构设计维度分析,H-Nets表现出了极高的复杂度和设计精妙性。层与层之间的规范化、线性投影、辅助稀疏损失等多种技术配合实现了平衡的压缩率和计算开销。同时,研发团队对不同子网络层的深度和宽度配置进行了大量实验,结合Transformer与Mamba层级混合,使模型在处理未分词原始字节输入时展现出特别优异的性能。 这一点尤为重要,因为传统Transformer模型在未分词的细粒度数据上表现欠佳,显示了其缺乏对信息压缩的原生能力。H-Nets通过引入状态空间模型的压缩机制,实现了更有效的表示学习,拓展了模型的适用性和泛化能力。

面向未来,H-Nets的研究工作还远未结束。尽管已经在数据规模和模型稳定性等方面取得了显著进展,但如何进一步简化架构、提升训练效率,以及扩展至更多模态如视频、多语种甚至跨模态任务,依然是重要课题。团队计划继续探索更优的层次递归方法和自适应分块策略,期待发现更多能够跨越传统Tokenization限制的突破点。 此外,H-Nets在抵御噪声和处理高复杂度序列上的潜力也值得关注。模型能够自动识别并压缩信息量低的噪声段,有望为现实应用中的鲁棒性提升提供有效支持。结合强化学习、对比学习等最新技术,未来的H-Nets版本或将具备更强的适应性和自主抽象能力。

总的来说,H-Nets作为层次神经网络研究中的一大里程碑,不仅为自然语言处理等领域提供了新思路,也对深度学习架构的未来发展产生深远影响。它从理论到实践,融合了认知科学的分块理念和现代神经网络的复杂设计,逐步揭示了如何在大规模、多样化数据中高效学习和抽象信息的秘密。 随着算法优化和硬件算力的提升,H-Nets很可能成为未来序列建模的关键技术之一,推动人工智能向更具人类般认知水平的方向迈进。研究者和工程师应关注其不断演进,积极探索在实际场景中的创新应用,从而实现模型性能和应用价值的双重飞跃。