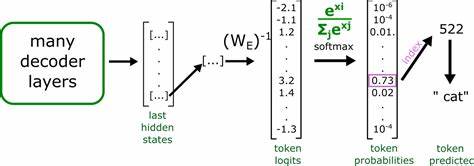

在自然语言处理领域,Transformer模型的引入彻底改变了文本表示和理解的方式。作为Transformer的核心,词元向量扮演着至关重要的角色。传统上,大多数人习惯将词向量视作嵌入空间中的点,这种简单的几何想象帮助理解词汇之间的相似度和关系。然而,最新的研究和理论表明,Transformer中的词元向量远非单纯意义上的空间点,它们更复杂且动态,与空间中的固定点有很大区别。理解这一点对构建更高效、更准确的语言模型具有重要意义。首先,需要明确什么是词元向量和嵌入空间。

在传统的词嵌入中,每个单词被映射成高维空间中的一个固定向量,该向量代表了该单词的语义信息,这种方法帮助模型捕捉词与词之间的相似性及相关性。然而,在Transformer模型中,词元向量并非简单的静态嵌入,它们随着上下文的变化而变化,形成动态的表示。这种动态性挑战了"词向量是空间中点"的传统观念。Transformer的自注意力机制(Self-Attention Mechanism)使得每个词元向量不仅仅依赖于单独的词,还结合了整个序列的信息,从而形成更加丰富的语义表达。具体来说,词元的嵌入向量会随着输入文本的不同而调整,导致同一词汇在不同上下文中拥有不同的向量表示。换言之,词元向量不再是孤立的"点",而成为一种条件依赖、上下文敏感的向量集合。

其次,Transformer中的词元向量不仅仅是简单的点的集合,更像是紧密关联且实时调整的向量场。通过多头注意力机制,自注意力将输入序列中的每个词元映射到一个高维空间,该空间中的向量随着上下文的流动不断改变。这个向量空间不是静态的几何空间,而是大脑神经元网络中的动态激活模式,词元向量反映了复杂的语义和句法信息交互。理解向量的这种动态性质,可以看出词元向量实际上是嵌入空间中随着模型处理而演变的向量阵列,而非固定的点。基于此,词元向量的"点"性质被重新定义为"区间"或"轨迹",它们在向量空间中不仅有位置,还有运动和变化。这种观点启示我们,在设计模型和解释其行为时,不能仅从静态几何学视角出发,而需考虑词元向量的生成机制和变化规律。

进一步来看,Transformer词元向量的非点性质对下游应用产生深远影响。例如,词义消歧(WSD)任务得益于动态词元向量,模型能根据不同上下文对同一词语产生不同的向量表示,从而更准确区分词义。又如,情感分析和机器翻译中,动态调整的词元向量帮助模型捕捉微妙的语义变化和句子结构,使结果更加贴近人类语言理解。此外,这种动态嵌入机制使得传统基于固定词典的向量空间模型面临挑战。在传统方法中,词向量维度和表示相对固定,易于理解和可视化,但在Transformer中,向量不仅随文本不同而多样,更嵌入了整句乃至整个段落的语义信息。研究者们正在探索如何准确刻画这种复杂的嵌入空间,包括利用张量表示、流形学习和非线性投影等高阶数学工具,以揭示其内在结构。

理解Transformer词元向量的动态和非点性质也促使机器学习社区重新审视经典的向量距离和相似度度量方法。传统的欧氏距离、余弦相似度在这种动态向量场中不再总是有效,必须开发新的度量标准来捕捉上下文敏感下的语义关系。部分研究尝试引入动态距离测度,根据上下文调整相似度计算,有望提升语义搜索和知识检索的准确性。总的来说,Transformer词元向量不再是简单的嵌入空间点,而是复杂、动态且高度依赖上下文的信息载体。它们代表了现代深度学习模型在理解和生成自然语言方面的巨大进步。这种认识不仅深化了我们对语言模型内部机制的理解,也为未来的模型设计、优化和应用提供了新的视角。

未来,围绕词元向量的研究将持续推进,包括如何有效地利用其动态性,实现更高效的语义表达和信息整合。随着技术发展,理解词元向量在嵌入空间中非点性质的重要性将愈发凸显,它是连接语言理解与机器智能的重要桥梁。 。