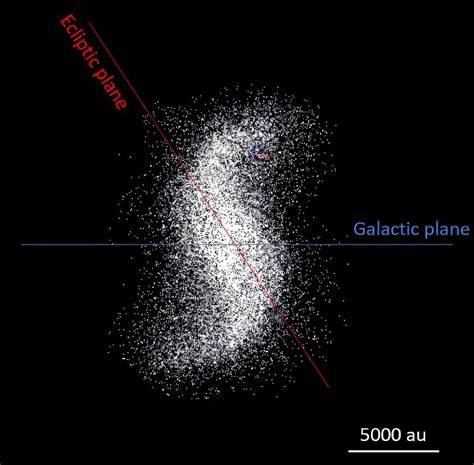

在数字化浪潮中,人工智能(AI)正逐渐成为推动创新和变革的关键力量。无论是在医疗健康、金融服务,还是在网络安全领域,AI的应用不断拓展。然而,伴随AI技术的广泛部署,一个核心问题逐渐显现:如何让用户和企业信任这些智能系统。尤其是在网络安全这一高度敏感和动态变化的领域,信任的建立不仅关系到技术的应用成效,更直接影响组织的安全防护能力和业务连续性。 信任是AI系统成功应用的基石,但构建这种信任绝非易事。人们在日常生活中多次目睹AI因“幻觉”或错误信息而导致的误判,比如AI虚构法律先例或错误解读天文数据等现象。

这些问题极大地削弱了用户对AI决策的信心,产生了广泛的质疑和抵触情绪。在网络安全领域,类似的挑战也不鲜见。曾经被过度宣传的早期安全AI解决方案承诺能消除误报,捕获所有威胁,但事实证明AI模型同样存在误报和漏报的问题,且往往缺乏必要的透明度,让安全团队难以理解其决策依据,进而影响信任度。 值得注意的是,建立信任是一个持续的过程,需要依靠多方面因素的共同作用。透明度是构筑信任的基石。AI系统应当清晰说明自身使用了哪些数据,如何分析和推理出结论,这样才能让用户感知背后的逻辑。

以网络安全中的自动化警报调查为例,系统需要明确展示为何某一警报被认定为误报或真实威胁。通过将调查流程拆解成一系列可验证的调查步骤(例如Embed安全平台采用的iSteps™方法),每一步骤均基于可获取的证据和衍生问题,形成完整的问答链,协助安全分析师独立确认AI的推断结果。这样的设计不仅增强了系统的透明度,也能更好地与分析师的直觉和判断保持一致,促进双方的协作。 透明度的同时,准确性则是信任的最终检验标准。AI系统若能够稳定提供正确的结论,用户便更易建立起信心。尽管任何安防系统都难以实现绝对完美,但通过不断优化算法和数据质量,减少误报的次数,AI能够大幅降低安全分析师的负担,让他们能够专注于真正关键的安全事件。

准确的自动化调查不仅节约了时间,还能在一定程度上提升整体安全响应的效率。例如,多数安全团队每天面对大量警报,人工逐一排查既费时又容易出错,传统的优先级排序机制如厂商严重等级、攻击生命周期阶段或检测规则名称往往过于片面,无法真实体现威胁的严重程度。随着用户对透明且准确调查结果的信任增强,越来越多团队愿意依赖AI的自动判断,从而减少对人工审查的依赖。 建立信任之后,如何保持和维护这种信任则是另一大挑战。网络安全环境瞬息万变,攻击技术不断进化,防御能力也在持续提升。AI系统必须具备适应这种变化的能力,时刻紧跟最新的攻击手法和策略。

如果安全团队对AI的信任变得过于依赖,减少了对系统输出的监督和验证,很可能在威胁态势发生变化时陷入盲区,错失有效响应的时机。针对这一风险,Embed安全强调持续的监测和主动沟通,向用户展示系统如何应对新的攻击类型,如何调整调查思路。通过提供可视化的威胁趋势和AI推断演变,安全团队可以及时感知系统内部的状态变化,从而合理安排关注重点和复核流程,避免盲目“设定后忘记”。这种持续透明的反馈机制,不仅有助于及时发现潜在偏差,还增强了用户对AI系统的掌控感,进一步巩固了长期信任。 AI信任的构建过程还需注重用户体验和实际效用。Embed的案例显示,随着用户逐渐接受并依赖他们的自动化调查平台,安全团队的工作效率显著提升,警报处理速度加快,同时误判减少,整体安全态势感知更加清晰。

实际场景中的成功应用反馈成为信任积累的重要推动力,帮助更多组织从观望转为积极拥抱AI解决方案。简而言之,透明解释、准确功能与动态适应形成了信任的三驾马车,缺一不可。 展望未来,AI在网络安全及更广泛领域的应用将持续深入。信任的建立需要以事实为基础,通过技术手段提供真实可靠的解释和成果,而非仅靠夸大宣传和花哨的营销语言。行业内的从业者和开发者需要践行“信任但验证”的原则,持续完善AI模型的透明度和准确性,加强对环境变化的响应能力,并与用户保持积极的沟通。唯有如此,才能真正释放AI潜能,使其成为助力安全防护的利器,推动数字经济的健康发展。

如今,企业在选择AI安全解决方案时,应高度关注产品的透明度机制,是否能够充分展现调查过程与依据;准确率是否通过真实环境验证,能否真正降低误报和漏报;是否具备持续学习和适应新威胁的功能,保持前瞻性和灵活性。上述这些要点不仅关系到技术层面,亦是构建深度信任的核心要素。 总体来看,人工智能信任的构建是一段漫长且持续进化的旅程。它攸关技术的应用成效,影响着用户的采纳意愿和安全管理的整体水平。聚焦透明性、准确性及适应性三大支柱,推动AI系统不断完善和自我进化,将是未来各方共同努力的方向。只有建立起稳固的信任基础,AI才能在网络安全乃至更多领域,实现其引领变革和守护安全的使命,为数字时代的繁荣提供可靠保障。

。