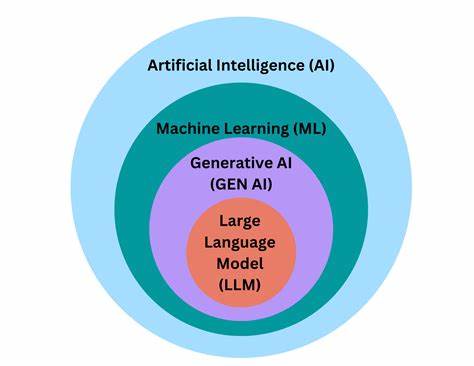

在人工智能和自然语言处理领域,大型语言模型(LLMs)的兴起引起了广泛关注。这些模型如GPT系列,凭借其强大的语言理解与生成能力,推动了自动翻译、智能客服、内容创作等多方面的革新。然而,理解这些模型背后的数学基础与统计性质,对研究者和应用者而言尤为重要。尤其是,深入探讨大型语言模型的贝叶斯特性,对提升模型设计、优化推断过程以及推动理论研究具有重要意义。本文旨在详细阐述为什么LLMs从数学期望角度看具有贝叶斯性质,但在实际实现和生成过程中往往并不完全体现这一特性。首先,需要明确贝叶斯方法的核心理念。

贝叶斯统计依赖于贝叶斯定理,通过结合先验分布与观测数据的似然函数,更新对未知参数的后验概率分布,从而实现不确定性的量化和推理。在自然语言处理中,贝叶斯方法为风险评估、模型选择和语义理解提供了理论基础。传统的贝叶斯语言模型会计算词语或者句子在给定语境下的概率分布,然后基于后验概率做出预测。相比之下,现代大型语言模型通常建立在深度学习架构之上,特别是基于变换器(Transformer)的结构。这些模型通过大规模数据训练,学习语言的统计规律和上下文关联,形成复杂的参数空间。尽管表面看似非贝叶斯,实则在数学期望角度,LLMs生成的分布符合某种形式的后验概率分布,即在理论上满足贝叶斯推断的期望性质。

这意味着从全局统计角度观察,LLM可以被视为贝叶斯推断过程的近似。然而,实际推断和文本生成环节,LLMs的行为与纯贝叶斯模型存在差异。首先,LLMs通常使用最大似然估计(MLE)进行训练,优化的是预测目标而非显式的后验概率。因此,训练过程缺少传统贝叶斯框架中的先验知识引入和不确定性建模,这导致模型在面对未见样本或罕见事件时表现出过度自信或偏差。其次,实际生成过程中涉及到采样策略,如贪婪搜索、温度采样和束搜索等,这些方法在提高生成效率和多样性的同时,也可能偏离最优贝叶斯解,导致生成文本的概率分布与理论后验有所不同。此外,模型规模和参数数量的庞大使得对后验分布的明确解析和可视化变得不切实际。

由于参数空间极其高维且非凸,模型训练只是在海量数据上找到局部最优解或近似解,而非真正解决贝叶斯后验分布的全局问题。另一方面,贝叶斯神经网络(Bayesian Neural Networks)试图将贝叶斯思想严格应用于深度模型中,通过给网络权重赋予概率分布,直接建模不确定性。尽管理论优越,实践中这类网络因计算资源和推断复杂度较高,尚未大规模应用于主流语言模型训练。回到大型语言模型,理解它们"期望中的贝叶斯性"有助于对结果概率分布的解释和调整。通过集成多个模型输出或引入贝叶斯近似推断方法,可以增强模型鲁棒性和预测准确性。例如,应用蒙特卡洛采样估计模型不确定性,或结合变分推断方法改进参数后验近似,有望缩小理论与实际之间的差距。

此外,认识到LLMs在实现中不完全体现贝叶斯特性,有助于指导模型训练策略和采样方法的改进。引入先验正则化、置信度调整以及多样性控制,能够更好地模拟真实语言的概率分布特征,提升生成文本的自然度和合理性。总之,大型语言模型作为现代人工智能的核心技术之一,其在理论上呈现出了贝叶斯特性,即在数学期望层面可以理解为贝叶斯推断的近似实现。然而,训练方法、生成策略及模型复杂性等因素使得其在实际应用中并不完全符合传统贝叶斯模型的行为。这种认识不仅深化了我们对LLMs本质的理解,也为未来模型设计和优化提供了理论支撑。人工智能领域的持续发展中,融合贝叶斯统计的深度学习技术将极大推动模型的解释性、可靠性和泛化能力,为语言理解和生成开辟新的可能性。

。