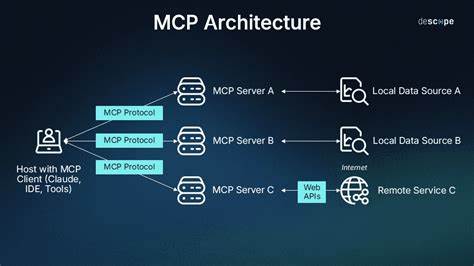

随着人工智能技术的蓬勃发展,模型上下文协议(Model Context Protocol,简称MCP)因其能有效桥接本地数据与大型语言模型(LLM)而备受关注。然而,随着数据隐私和安全问题日益突出,MCP的连接模式也面临诸多挑战。本文将剖析MCP连接的安全隐患,回顾其发展历程,并介绍基于Tailscale的创新性安全连接方案,为读者提供兼顾便捷与隐私的数据交互思路。 人工智能融入日常生活和工作已成大势所趋,尤其是大型语言模型的应用覆盖面广泛。MCP旨在将用户本地的独特、非公开信息导入到LLM中,以实现更为精准和个性化的分析和处理。初期MCP设计考虑到主要的使用场景集中在本地,通过标准输入输出流(stdio)的方式运行MCP服务器,确保数据不会随网络暴露,从而降低外泄风险。

但随着需求的增长,远程访问MCP服务器愈加重要,如何在确保传输安全的同时维持连接的便利性成为关键难题。 早期MCP连接机制多依赖本地标准io方式,适合单机或局域网环境。用户通过JSON格式的指令驱动MCP客户端与服务器的通信,这对于具备一定技术基础的人较为直观,但对于普通用户而言,如何合理配置这些“神秘指令”成了门槛。此时,MCP主要通过局域网或本机访问,数据风险相对可控。然而,在实践中,许多用户和企业希望能够将MCP服务器部署到云端或远程服务器,提升数据处理效率与协同能力,这就引发了如何实现安全远程访问的课题。 为了满足远程调用的需求,MCP协议演变出了支持Server Sent Events(SSE)的版本,这允许服务器通过持续推送事件流的方式与客户端通信。

尽管SSE带来了技术上的便利,但未充分考虑网络攻击手段——特别是DNS重绑定攻击。若服务器未有效验证来源头信息或配置错误绑定地址,攻击者可能绕过防御,通过恶意网站远程访问本地MCP服务,造成隐私重大泄露。 在SSE技术尚未成熟的阶段,出现了代理工具以桥接本地客户端与远程SSE服务器。这些代理工具虽然一定程度上缓解了连接限制,但其安全模型的构建仍显不足,往往依赖于传统的认证协议如OAuth。而OAuth本身因配置复杂易出错,且授权机制缺乏细粒度访问控制,使得MCP服务的安全保障并不理想。此外,OAuth常将服务暴露在公共互联网,敏感数据存在更大风险。

流式HTTP作为SSE的升级替代方案在近几个月内迅速兴起,其通信效率和兼容性都有所提升,但官方规范至今未明确引入严格的认证流程。这种缺失引发对协议安全性的担忧,尤其是在处理敏感信息时,用户无从保证远端服务的安全合作伙伴身份。面对这一尴尬局面,技术社区对如何构建更为安全且友好的MCP连接模型提出了诸多探索方向。 Tailscale作为基于WireGuard协议的零配置VPN解决方案,因其安全可靠、部署简便逐渐被大量团队和个人采用。Tailscale的私有网络模型及其应用感知功能为MCP的安全远程访问提供了新思路。利用Tailscale网络,用户可以将远程MCP服务器部署在数字海洋等云平台且不必暴露公网IP,通过Tailscale自动生成的安全隧道实现加密通信。

这不仅避免了公网上的直接暴露,更提供了身份验证与访问权限的细粒度管理。 开发者针对MCP与Tailscale结合,设计了专门的代理服务,能够在本地作为MCP客户端与远程MCP服务器之间的桥梁工作。该代理利用Tailscale的头信息(例如X-Tailscale-User)实现身份识别与权限校验,远端MCP服务器可根据Tailscale的ACL(访问控制列表)规则判断请求者能调用哪些工具和访问哪些资源。这种模型实现了真正意义上的“零信任”访问保障,让用户的数据只在受信任的私有网络内部传递,极大增强了数据安全性和隐私保护。 为了搭建该环境,用户需要在本地和远端机器均安装并运行Tailscale客户端,设置好相应的访问授权。远程MCP服务器多采用Go语言开发,以利用Tailscale提供的tsnet库,这是因为tsnet目前在Go生态内支持度较高,而绝大多数传统MCP服务器以Typescript或Python实现,暂时未广泛适配类似方案。

Tailscale官方也在探索和推广C语言库的实现,使得更多主流语言环境能够集成此种连接模式。 部署实践中,用户只需简单修改MCP客户端配置,指向本地的MCP代理,并在代理参数中填写远程MCP服务器的Tailscale地址和端口。通过此配置,所有MCP请求均通过加密的Tailscale网络转发,且由代理携带认证信息转达服务器。服务器端则根据用户的Tailscale权限决定是否授权执行特定操作,实现透明且安全的权限管理。 尽管Tailscale基于应用感知的权限模型具有显著优势,但仍有一些现实限制。首先,目前tsnet库主要支持在Go语言环境下的应用开发,对于其他语言用户仍需等待官方支持或社区贡献。

其次,该方案目前要求客户端必须部署本地代理,暂不支持完全无客户端的云端直连,这意味着用户端需要安装Tailscale环境,增加了使用门槛。未来若能与大型AI服务商如Anthropic合作,实现原生支持Tailnet私有网络访问,将大幅提升这一模型的普适性与便利性。 安全角度来看,将MCP服务部署在公共互联网且仅依赖OAuth进行鉴权的做法存在诸多风险,OAuth错配或凭证泄露均可能导致数据外泄。相比之下,基于Tailscale的私有网络部署降低了潜在攻击面,且借助Tailscale的身份和访问控制体系,更科学地划分了权限范围,避免了过度授权。此外,私有网络模式也解决了数据在传输过程中的中间人攻击风险,为敏感且独特的数据提供了更有力的保护屏障。 从长期发展角度来看,MCP作为新兴协议,亟需制定更加完善的安全规范和最佳实践,结合现代VPN技术、身份认证机制以及权限治理,为大规模安全数据传输和AI辅助决策奠定基础。

Tailscale方案在这一链条中提供了宝贵的思路,证明了网络私密性与方便性可以兼得,同时也促使协议设计者和技术开发者重新思考数据安全的优先级和实施路径。 最后,虽然有声音担心引入Tailscale会破坏“开源开放标准”的中立性,但从实际效果看,优先保障用户数据隐私和操作便捷性是当务之急。与其坐等标准理想逐步完善,不如积极实践成熟安全方案,避免数据被无节制地暴露在未知网络环境。正如许多技术领袖所言,参与塑造新技术的发展,才是推动行业健康前进的正道。 未来MCP连接的发展值得期待。我们希望看到更多跨语言、跨平台的高安全性连接方案出现,推动LLM与本地数据的无缝、安全融合。

伴随着Tailscale及类似技术的普及,安全简洁的MCP连接终将成为保障用户隐私和提升人工智能应用体验的坚实基石。