近年来,随着人工智能和深度学习技术的迅猛发展,更多应用开始依赖于高效的神经网络推理能力。而苹果设备,尤其是搭载Apple Silicon芯片的Mac系列,因其在消费电子市场的广泛普及,成为AI应用性能优化的重要平台。PyTorch作为深受开发者喜爱的深度学习框架,其在苹果设备上的表现一直备受关注。众所周知,GPU内核的效率直接决定了模型训练和推理的速度,而在苹果设备中,Metal作为其专有的图形和计算API,承担着驱动GPU执行的关键作用。近期,gimletlabs.ai实验室发布的研究成果引起了行业热议:通过AI自动生成优化的Metal内核,PyTorch推理速度实现了高达87%的提升,这预示着深度学习硬件加速进入了一个全新的时代。 优化GPU内核:性能提升的瓶颈与挑战 深度学习运算依赖于大量矩阵运算和数据并行计算,这些操作由GPU内核负责并行执行。

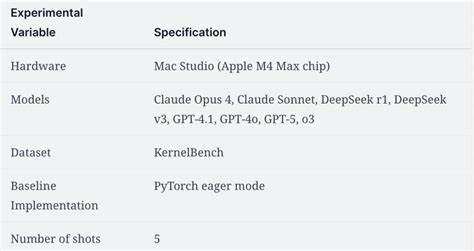

传统上,GPU内核的编写高度依赖底层的手工优化工程,尤其是在CUDA生态中,这些优化在速度和效率方面已达到较高水平。然而,苹果设备主要使用Metal而非CUDA,导致手写和优化Metal内核成为了专业挑战。Metal平台缺乏充分的文档和成熟工具链,人才稀缺,技术门槛高,严重制约了模型在Apple设备上的性能展现。PyTorch虽已支持Metal加速,但现阶段的torch.compile尚未完全覆盖Metal优化,许多内核仍处于非最佳状态。 AI自动生成内核:颠覆传统的创新 针对这一难题,研究团队提出了利用最前沿大语言模型(LLM)自动编写Metal GPU内核的设想。他们挑选了来自Anthropic、OpenAI和DeepSeek的八款顶级AI模型作为内核生成"工人",在大量PyTorch模块上进行测试验证。

经过多轮生成、校验和性能测试,AI生成的Metal内核不仅保证了运算正确性,还在多数情况下超越了原PyTorch实现。特别是在KernelBench v0基准测试中,部分内核的速度提升甚至达到近两倍。同时,后续更新的KernelBench v0.1版本验证了整体平均提速达到1.22倍的稳定性与准确性。对这些数据的分析揭示,虽然每款AI生成模型的表现存在差异,但在多模型协同"群体智慧"下能实现更优的综合性能 - - 这即是该研究提出的"代理群"策略的核心思想。 代理群策略:多模型协作驱动性能极限 这项技术创新借鉴了群体智能的理念,多款AI模型以代理身份,分别独立生成Metal内核代码。系统将自动对所有候选方案进行编译、测试正确性与性能对比,最终采用表现最优的实现。

实验表明,代理群策略比单一模型生成的内核平均快31%,在复杂Level 2问题中加速达42%。这一发现体现出多样性及相互补充优势,使得内核生成更具鲁棒性与高效性,不仅节约了人工调试时间,还大幅降低了进入门槛。 深度剖析AI生成内核中的奇思妙想 部分AI模型展现了惊人的逻辑推理能力。例如,o3模型能通过代码语义分析发现某些计算结果永远为零的数学规律,将复杂代码简化为直接返回零的方案,令推理延迟缩短超过9000倍。尽管这类"极端"优化被排除在评价体系之外,但它彰显了LLM在代码理解与自动化优化中的潜力。此外,GPT-5通过内核融合技术减少了GPU内核调度开销及内存访问瓶颈,展现了AI对硬件架构细节的敏锐感知能力。

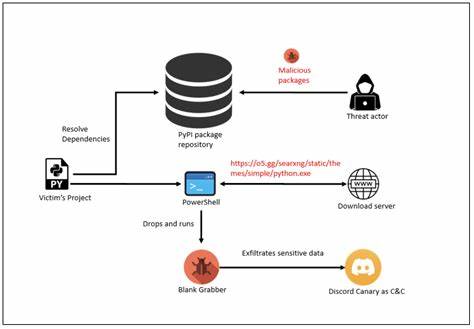

这些优化不仅提升速度,也能降低能耗,对于提升苹果设备的实际AI应用体验具有重要意义。 引入上下文增强:融合CUDA参考与性能剖析 基于实验,研究人员意识到,在生成Metal内核时提供更多背景信息会显著提升效果。具体而言,将已存在的CUDA实现作为性能参考,加上Mac Studio Apple M4 Max芯片上的GPU性能剖析数据,成为了生成模型的重要输入。由于Metal性能数据的收集困难,研究团队创新地利用macOS自动化工具(如Bluem的cliclick)配合Apple Script自动截图,从Xcode的性能分析界面中提取有价值信息,再通过子代理对图像进行解读,为主代理提供优化建议。这种多模态信息融合,提升了内核生成的智能程度,有效减少了性能瓶颈和流水线等待,从而成就了近乎三倍于无背景生成的性能提升。 典型案例解析:VisionAttention模块的惊艳优化 另一个令人瞩目的实例是DeepSeek-R1对VisionAttention模块的优化。

该模块原设采用标准的多头自注意力机制及LayerNorm处理,在苹果硬件上性能表现有限。AI自动生成的Metal内核利用线程组共享内存(threadgroups),优化了局部数据访问,减少GPU全局内存压力。同时内核通过融合加法与归一化操作,实现了计算图的折叠,避免了中间数据频繁存取,令该实现较PyTorch原生方案快18倍以上。这充分证明了AI驱动内核设计不仅能满足正确性要求,更有能力挖掘平台潜能,实现定制化的深度优化。 AI与人类开发协同:未来软件工程新篇章 AI自动生成高效GPU内核技术的最大优势之一是极大地降低了专业门槛。传统上编写Metal内核需要深厚的图形渲染和并行计算背景,而现在开发者甚至无需熟悉底层细节,便能获得优异性能。

未来,工程师可以将更多精力用于复杂算法设计和系统架构,而将内核级别的细节调优委托给AI代理。此种人机协作模式不仅加速了开发流程,也为跨平台移植和新硬件适配提供了便捷路径。想象一下,一份PyTorch模型代码上传后,后台自动生成针对不同GPU架构(如ROCm、CUDA、SYCL等)的最佳内核,几乎零门槛实现高性能应用部署,这将极大推动AI技术的普及和产业落地。 多样化应用场景及未来展望 这种基于AI的Metal内核自动优化,不仅适用于推理加速,同样具备训练性能提升潜力。未来,随着技术成熟,训练工作负载在苹果设备上的运行效率也将获得实质提升。大规模推理云端部署、边缘设备实时AI处理、多模态融合计算、智能手机图像处理加速,皆可应用该技术实现性能飞跃。

此外,随着代理智能体不断完善,系统将支持更动态的上下文感知,诸如自动生成更细粒度的调优方案,甚至多代理协同完成复杂内核分解与组合,为AI模型提供前所未有的底层执行效率保障。 总结来看,利用AI生成Metal GPU内核为苹果设备上的PyTorch推理加速提供了革命性的解决方案。其无需人工编写、可以快速迭代且性能显著提升的特性,将为开发者和终端用户带来切实价值。随着代理群策略、上下文融合、性能分析等技术不断进化,AI自动化内核生成将在深度学习框架优化领域掀起新革命,推动AI模型性能优化迈向更高峰。苹果生态下的深度学习加速正迎来高效与智能并存的新时代,行业期待更多创新迭代与应用落地,唤醒真正的卓越性能体验。 。