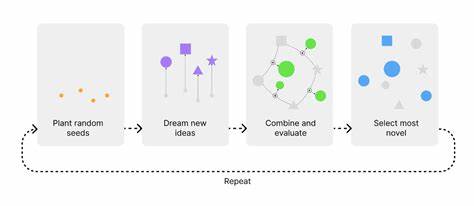

随着人工智能技术的飞速发展,尤其是在大型语言模型(LLM)领域的突破,诸如OpenAI的GPT系列和Anthropic的Claude等模型已广泛应用于文本生成、问答系统、内容创作等多种场景。然而,随着应用的深化,一个难以忽视的问题也逐渐暴露——LLM“幻觉”现象,即模型生成了与事实不符或误导性的内容,严重影响了模型的可信度和实际应用价值。为此,幻觉检测技术成为确保AI输出质量的关键环节。近年来,一款名为“LLM幻觉检测器”的工具脱颖而出,其独特之处在于兼容多种模型平台,包括GPT、Claude和本地部署模型,实现了框架无关、语言无关、高效精准的幻觉识别,为AI可靠性提升提供了有力保障。 LLM幻觉检测器的设计理念基于多维度的文本分析,结合语言模式、事实密度、上下文一致性、矛盾检测等多个层面,构成了一个综合评价体系。首先,检测器会分析语言中的信心模式,识别文本中频繁出现的不确定词汇和过度自信表达。

典型的不确定用语包括“我认为”“可能”“或许”等,而过度自信的语言则可能出现“绝对”“一定”“从不”等极端词汇。通过这一分析,检测器能捕捉模型在回答时的态度倾向,判断是否存在不合理的自信或犹疑,从而预警潜在的幻觉风险。 事实密度评分是另一项核心技术。检测器通过识别文本中的时间、数字、货币金额、百分比等具体事实性信息,评估文本中客观数据的丰度与准确性。过量且未经验证的具体信息可能是幻觉的重要标志,因为模型倾向于“编造”细节以填补知识空白。通过调控事实密度,检测器能在一定程度上判定文本是否过于“丰盛”,从而提示用户注意真实性问题。

在文本结构和逻辑层面,检测器通过一致性分析和重复性检测,进一步衡量回答的合理性。逻辑连贯性检查帮助识别跳跃式思维、断裂的论证过程或不符语境的内容,重复性检测则捕捉过度冗余或循环论证的表达,这些均是幻觉内容的潜在特征。 上下文一致性校验则进一步提升了检测的精准度。检测器将生成文本与用户的原始提问或上下文信息进行语义对比,确保输出内容与输入意图相符,减少偏题和内容失实的风险。矛盾检测功能则专门针对文本内部存在的自我冲突和事实矛盾展开扫描,如一句话中出现的“总是”与“从不”等直接对立的断言,会被标记为潜在的幻觉点。 值得注意的是,LLM幻觉检测器并非仅限于单一编程语言实现,而是融合了Python、Rust和C++等多种语言技术优势,提供了灵活的使用方式。

Python版本方便快速集成,适合数据科学家和工程师的实验环境。Rust版本则侧重于高性能、低延迟的生产应用,特别适合实时分析场景。C++的事实图引擎采用有向无环图结构,支持复杂事实验证,是对传统模式检测的有力补充。这种跨语言、多架构的设计保证了工具的广泛适用性与未来可扩展性。 在具体使用中,检测器提供了简单易用的接口和便利函数,开发者无需复杂的依赖环境即可快速上手。例如,使用单行函数即可对文本进行快速的幻觉概率检测,也支持传入上下文以提高识别准确率。

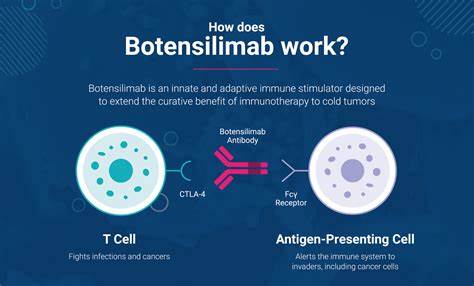

此外,检测器能够输出详细的分析报告,包括幻觉概率分数、发现的问题类型及对应的改进建议,帮助用户全面了解模型输出的风险点。 更进一步,对于追求极致性能的用户,检测器的Rust MVP(最小可行产品)版本提供了基于神经网络的幻觉检测、支持多语言分析、实时流式数据检测以及交互式网页仪表盘等多种高级功能。结合WebSocket和RESTful API接口,使得该工具不仅适合单次文本分析,也可无缝集成到复杂的生产环境,实现实时监控和批量处理。 值得关注的是该工具还兼容不同来源的模型,无论是云端的OpenAI GPT、Anthropic Claude,还是本地部署的Transformers模型都能无缝接入。对于企业或者研究团队而言,这种跨平台支持极大地降低了幻觉检测的技术门槛和部署复杂度,同时也减少了依赖单一平台的风险。 实际应用中,LLM幻觉检测器能有效辅助多种场景中的质量保障任务。

内容生产系统通过该工具过滤虚假或不准确的信息,保障文章和报告的质量。客户服务机器人可以实时筛查并剔除误导性回复,提高用户满意度和信任度。教育平台利用该检测提升教材准确性和答疑质量,避免误导学生。开发人员借助丰富的检测反馈快速定位模型不足,优化提示词设计和模型训练,推动整体AI能力提升。 此外,幻觉检测工具的开放源码和灵活的扩展接口也为研究人员提供了宝贵资源。用户可以基于现有框架自定义特定领域的检测规则,如医学、金融等高风险行业,进一步强化模型输出的严谨性和专业性。

其强大的分析性能和详尽的检测维度,助力学术界深入理解和监控大型语言模型的生成行为。 未来,LLM幻觉检测器计划引入更先进的神经网络架构,结合Transformer模型优势,提升检测精准度和响应速度。企业级功能也在规划中,包括单点登录(SSO)集成、全面的分析报表以及移动端应用支持等,努力打造一站式的AI输出可信管理平台。同时,实时协作和多用户管理功能的开发将进一步满足团队协作和大规模部署需求。 总的来看,随着人工智能在各行各业的渗透,保障生成内容的真实性和可靠性变得尤为重要。LLM幻觉检测器凭借多方法、多架构的检测策略,有效覆盖了语言表达、事实核查、逻辑一致性等关键风险点,为开发者和用户构建了一道稳固的防线。

其兼容性强、性能优越且不断完善的特性,使其成为当前乃至未来AI内容质量监测领域的重要利器。通过合理使用此类工具,我们有望在保持创新速度的同时,最大限度减少AI误导风险,实现更安全、更可信的智能应用体验。