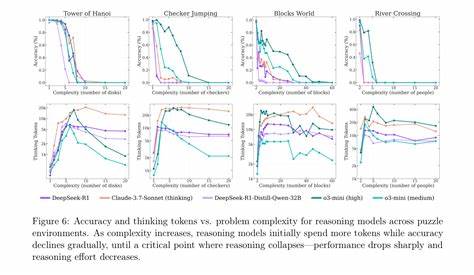

近年来,大型语言模型(LLM)以其强大的自然语言处理能力迅速成为人工智能领域的焦点。无论是文本生成、代码编写,还是辅助决策,LLM都展示了令人惊叹的潜力,激发了学术界、工业界乃至大众的广泛关注。然而,伴随着这些光鲜的成果,关于它们在“推理”与“逻辑思维”方面的不足也逐渐显露。最新来自苹果公司的一篇研究论文,进一步揭示了LLM在处理超出训练数据分布范围的问题时,尤其是在经典思维游戏如汉诺塔问题(Tower of Hanoi)上的表现,暴露出其根本性的局限。该研究不仅对当前神经网络、深度学习驱动的语言模型提出了严峻挑战,也引发了对AGI(通用人工智能)实现路径的深刻反思。 苹果的研究团队在论文中指出,即使是最新的高性能推理模型,依然无法稳定解决类似汉诺塔这样看似简单的算法性问题,准确率停留在令人失望的水平。

汉诺塔问题作为经典的计算机科学与人工智能教学案例,早在1957年就被“人工智能之父”赫伯特·西蒙(Herb Simon)利用传统算法成功求解。相比之下,大型语言模型在解决该问题时频频失误,甚至连所谓的“推理链”机制(chain of thought reasoning)和“推理模型”也难以弥补这种能力差距。 该发现让人不得不思考:如今被誉为“智能革命”的LLM,真的具备通用推理与逻辑思维的能力吗?抑或它们仅仅是基于大量数据拟合的概率语言生成器?从1998年Gary Marcus等专家便开始质疑神经网络的泛化能力,到近年来对推理链和推理模型的批判,现有技术始终面临着一个核心难题——超出训练分布的数据,模型往往表现低下,可靠性不足。 不仅如此,亚利桑那州立大学计算机科学家Subbarao Kambhampati通过一系列论文揭示了LLM推理链“表面合理、实则漏洞频出”的问题。他指出用户在解释LLM推理过程时,容易陷入“赋予模型类人思考”的误区,实际的内在机制远没有人类思维那般严密与理性。Kambhampati的研究成果得到了苹果新论文的有力支持,进一步证明即便是进行复杂推理尝试的模型,也不能稳定、系统地实现可靠的算法应用。

苹果团队在实验中甚至尝试了“交给模型现成的解决方案”环节,然而模型依然无法完美执行,仅靠已有算法步骤指导也难以提升其表现,这种现象令人震惊也令人深思。它暴露了LLM在理解和执行明确规则方面的根本缺陷,说明目前的模型并不具备真正的逻辑推理能力,它们更像是基于语言统计的复杂记忆和模仿机器。 这与人类认知的特点形成鲜明对比。尽管普通人类在面对复杂任务时也会犯错,比如在多盘汉诺塔的解法上,超出一定复杂度后容易失误;但人类的优势在于拥有多系统协同工作的大脑结构,不仅可通过逻辑和演绎推理应对新情况,还能利用长期记忆和经验不断修正自我。大脑的“预 frontal 皮层”及其他认知模块均参与问题求解,人类的思维模式远比目前LLM的单一统计学习机制复杂和灵活。 更重要的是,人类发明了计算机和算法这一便捷工具,来弥补自身在记忆容量和计算稳定性上的不足。

与此相比,LLM尽管具备海量参数和大规模记忆资源,却仍无法完美执行规则明确的任务,尤为讽刺。因为一台具备稳定算法执行能力的传统计算机,早已可以轻松解决汉诺塔这样的问题,甚至于它是传统AI教学的入门课题。 这也提醒我们,当前的AGI愿景不应仅仅盯着机械复制人类思维的语言表现力,更应强调“结合人类的创造力与适应性,辅以计算机的高速和精准”这一混合智能路径。理想的AGI应当超越人类局限,体现出真正的推理、学习和灵活应变能力,而非仅仅停留在对语言数据的深度拟合和表象“思考”演绎。 在商业和社会应用层面,这同样意味着目前基于LLM的系统,无法单凭其自身承担复杂任务的全部责任。尽管它们在代码生成、文案创作和头脑风暴等领域表现亮眼,但面对需要高度可靠性和逻辑严密性的场景,如复杂规划、科学计算或安全相关决策,仍需谨慎。

在某些案例中,LLM甚至可能因为过度自信生成错误答案,给用户带来潜在风险。 同时,苹果论文也让人们重新审视深度学习及神经网络的未来。虽然当前LLM展现了极高的工程成就,但它们在本质上属于统计学习方法的延伸,未来或需搭配符号推理、神经符号混合等新范式,突破现有的瓶颈。深度学习并非被否定,而是需要更高层次的创新和融合,才可能实现真正智能的新时代。 对AGI研究人员来说,这些发现是警钟:单纯依靠扩大模型规模和训练数据,寄希望于推理链增强推理能力,可能难以抵达目标。反而需要深入理解人类高阶认知原理,以及打造具备抽象推理、演绎逻辑和因果推断能力的系统。

借鉴心理学中的双系统理论,结合直觉与系统化推理,或许是未来突破口之一。 此外,社区讨论中也出现了对LLM能力差异的争论。有人提到有些模型通过精心设计的提示可以完成多个盘数的汉诺塔问题,甚至能生成动画或代码。这说明,模型的表现不仅与基础结构有关,也与训练策略、推理机制和输入设计紧密联系。为此,逐步优化和增强模型的自检、自我修正能力,可能成为延缓或缓解上述核心问题的重要途径。 随着时间推移,LLM将继续在辅助创作、编程和内容生成领域发挥重要的实际价值。

在未来十年,结合符号计算和更加严密的推理模块的多模态系统,或许可以开辟通向更高级智能的新路径。而非盲目吹捧其“通用智能”,社会各界应理性看待LLM的利弊,最大限度地发挥其优势,同时警惕其固有的局限性。 总的来说,苹果最新研究向业界和公众发出了清晰的信号:当前大型语言模型并非万能,面对超出既定数据分布、需要深度逻辑推理的挑战时仍难以胜任。实现真正的通用人工智能,仍然需要更为创新和多维度的技术突破。对AI未来的期待,不能脱离现实的科学基础和实践验证,而应是在批判中前行。 当前阶段,LLM更多是智能工具而非智能主体。

它们擅长模拟人类语言,但尚未具备消化知识、理解内涵、进行严密推理的综合能力。在人类的监督与辅助下,结合传统算法与神经网络的优势,AI技术仍有望为科学研究、产业升级和社会发展注入新的活力。科技界需要更加开放和多元的视角,借鉴跨学科成果,实现AI与人类认知能力的共生共进,才能真正迈向智能未来。