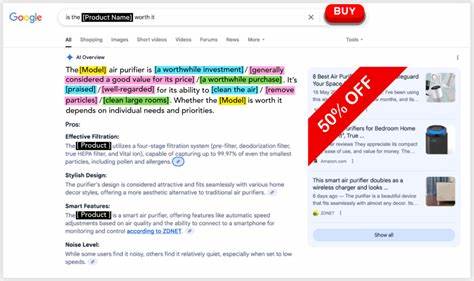

近年来,人工智能技术飞速发展,尤其是基于大型语言模型(LLM)的聊天机器人在各类场景中得到广泛应用。作为代表性的AI产品,ChatGPT为用户提供便捷的问答服务,但其实在实际使用过程中也暴露出一系列问题,尤其是在生成大型企业官方网站URL时的准确性问题。根据Netcraft公司的最新研究报告,ChatGPT在回答用户关于大型企业登录网址查询时,只有大约66%的回答能准确提供真实有效的网址,其余则包含不活动、临时无法访问或完全与请求品牌无关的链接,这不仅影响用户体验,更带来严重的安全风险。用户对AI技术的信任度随着错误信息频发而有所动摇,尤其当错误的链接可能成为网络钓鱼攻击的源头,带来的后果不容忽视。研究显示,部分传递的错误网址甚至曾作为钓鱼攻击载体被不法分子利用。钓鱼攻击者利用ChatGPT给出的错误或空闲域名,通过注册域名并对页面进行精心伪装,吸引用户误入钓鱼陷阱,窃取账户信息、个人隐私或进行诈骗活动。

这种攻击手段更隐蔽,绕过传统搜索引擎的防护,直接利用用户对AI生成信息的信任,极具破坏力。导致ChatGPT生成错误URL的根本原因主要源于模型的工作机制。语言模型本质上基于大规模文本数据训练,并更倾向于语义匹配而非事实验证。换言之,模型通过识别关键词和上下文关联生成回答,但无法自行判断链接的真实有效性、是否为正规网站或是否存在钓鱼风险。这种“知识”基于训练数据的时间截点,且缺少网络实时验证机制,导致模型容易生成过时、不准确或误导性的URL。事实上,训练数据中可能含有钓鱼网站相关内容或虚假链接,加剧了风险。

利用AI模型生成错误信息造成的安全风险,早已预示着未来网络安全面临新的挑战。攻击者正逐渐改变策略,不再依赖传统搜索引擎优化(SEO)手段,而是针对AI问答输出进行创新攻击。正如Netcraft研究团队提及的区块链Solana区块链API攻击案例,钓鱼者通过伪造API接口、发布假教程和文档,成功诱导开发者使用恶意代码,展现了AI袭击的递进式复杂性。面对AI技术带来的安全隐患,用户、企业与AI开发者均需采取积极措施。用户在依赖ChatGPT或其他语言模型获取企业官网链接时,应当保持警惕,尽量通过官方网站或知名搜索引擎核实链接真伪。增强网络安全意识,避免盲目信任来自人工智能的单一反馈。

企业方面,应加强自身官方网站的安全建设,注册相关域名防止被恶意夺取。同时,借助安全监测和网络钓鱼防护工具,阻止潜在钓鱼网站传播。AI产品开发者则亟需在模型设计阶段引入事实核验和权威数据源接入,避免单纯依赖语言模型生成内容。提升模型对链接有效性验证的能力,或者在输出官网链接时自动提供官方推荐网址列表和可信度信息,减少误导。行业监管机构也应关注AI生成内容的潜在安全威胁,推动建立规范标准,促进技术与安全并重的健康生态发展。随着AI技术进一步融入日常生活,如何保障用户在信息获取过程中的真实性与安全性成为关键课题。

ChatGPT错误URL事件揭示了AI发展中不可忽视的问题,也为相关技术完善提供了借鉴意义。未来,人工智能不应仅仅追求语言生成的流畅与丰富,更需在真实性、权威性和安全性上同步提升。唯有如此,人工智能才能更好地服务于人类社会,真正实现智能与责任并行。