随着人工智能技术的飞速发展,大型语言模型(Large Language Models,简称LLM)在自然语言处理、代码生成和智能对话等领域展现出巨大的潜力。将LLM与交互式编程环境(REPL,Read-Eval-Print Loop)结合,不仅能够极大地提升开发者的工作效率,还能为最终用户带来更加智能和直观的操作体验。本文将详细探讨如何在程序中内置LLM REPL,助力软件创新和提升用户满意度。 交互式编程环境REPL自诞生以来,一直是程序员日常开发的重要工具。它允许开发者在代码执行的阶段实时阅读、评估并打印结果,极大地简化了调试和代码验证过程。传统的REPL通常面向特定编程语言,局限于语法和运行时环境中。

而当REPL与LLM结合时,便开辟出无限可能。基于LLM的REPL不仅能够解释代码,还能理解自然语言指令,智能地帮助手写或生成代码片段,提出优化建议,甚至从模糊的需求描述中推测开发者意图。 将LLM REPL集成到程序中,可以带来很多实际价值。首先,开发者无需频繁切换环境即可快速尝试代码,节省时间成本。其次,对于复杂业务逻辑和算法,LLM能辅助分析语义,帮助定位潜在错误或性能瓶颈。再次,内置REPL还能提升新手的学习效率,让他们以对话形式询问问题,获得即时解答和示范代码,从而降低入门门槛。

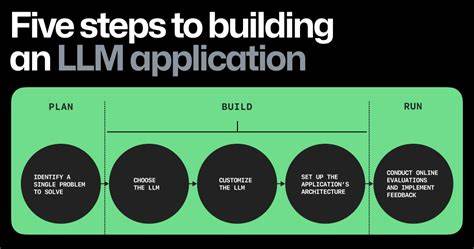

此外,针对最终用户,应用内置智能REPL能使他们通过自然语言与程序交互,完成定制化操作或自动化任务,极大提升用户粘性和产品差异化竞争力。 要成功构建内置LLM REPL,首先需要选择合适的模型和服务。当前市场上主流的LLM如OpenAI的GPT系列、Google的PaLM和开源的LLaMA等各具优势。根据应用场景确定模型规模和接口性能是关键。通常,为兼顾响应速度和效果,可采用微调后的专用模型,或者使用模型裁剪和知识蒸馏技术,以便在本地部署或边缘设备上运行。 然后,需要设计直观且高效的交互界面。

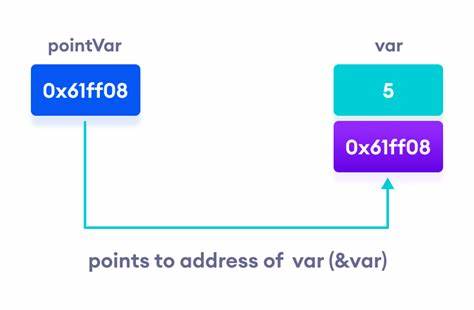

开发者版REPL界面应支持代码高亮、自动补全、语法提示和错误反馈,提升交互体验。对于终端用户版,界面应侧重于自然语言输入,具备上下文记忆和对话管理功能,使交互更自然流畅。同时,需要确保环境的安全性,防止恶意代码执行和数据泄露。对REPL的访问权限控制和输入输出的安全过滤不可忽视。 技术架构上,内置LLM REPL通常采用客户端与服务端分离的设计。客户端负责界面渲染和用户交互,服务端部署LLM推理引擎,处理自然语言输入并返回代码或文字结果。

通过WebSocket或HTTP长连接保持会话状态,确保多轮交互连续性。此外,可以结合容器化和微服务架构,实现灵活扩展和高可用性。 在性能优化方面,低延迟响应是关键。可以采用缓存机制保存常用查询和代码片段,减少模型推理次数。增量计算和并行执行策略也能提升交互效率。针对特定领域和任务,设计定制化指令集和上下文管理逻辑,帮助模型更精准地理解需求。

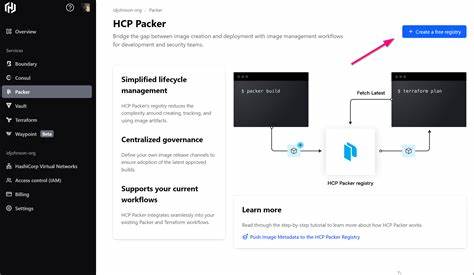

持续监控与反馈机制则确保系统稳定运行并根据用户行为不断优化。 实践中,许多知名开发平台和工具已开始尝试集成LLM REPL。例如,微软的Visual Studio Code因集成GitHub Copilot,实现了基于OpenAI技术的全自动代码补全和智能提示功能。JetBrains系列产品也在探索基于AI的智能助手,提供代码解释、重构建议等。对于企业内部的软件系统,定制化LLM REPL能够实现敏捷开发和业务流程快速迭代,帮助团队更好地协作和创新。 未来,随着LLM技术继续演进,内置REPL的应用场景将不断拓宽。

跨语言、多模态融合的交互环境将成为趋势,用户不仅可以使用文字,还能通过语音、图像与程序交流,极大丰富交互方式。此外,结合知识图谱和因果推理,LLM REPL将在复杂决策支持、自动化测试和智能运维领域发挥更大作用。 在实际应用时,企业和开发者还需关注伦理和合规问题。确保模型输出内容的合法合规,避免歧视和偏见,维护用户隐私,是构建负责任AI系统的基础。开放透明的反馈通道和内容审查机制,有助于长期优化用户体验和品牌声誉。 综上所述,将大型语言模型REPL内置于程序中,是提高开发效率、提升用户交互体验、推动智能软件创新的重要路径。

通过合理选择模型、设计交互界面、搭建稳健架构以及持续优化性能,开发者可以将复杂的AI能力转化为简单实用的工具,为软件注入新的活力。面对未来,拥抱LLM REPL,不仅是技术革新,也是数字时代软件开发的必然选择。