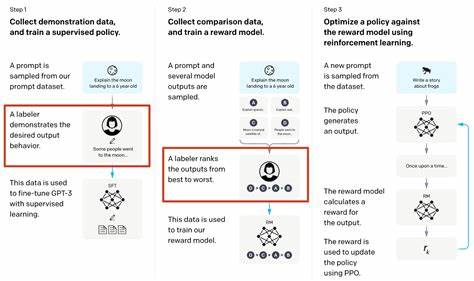

近年来,随着人工智能技术的飞速发展,大型语言模型(LLMs)在自然语言处理、文本生成以及复杂推理等领域中展现出强大的能力。其中,数学推理作为人工智能理解和应用的核心挑战之一,吸引了大量研究者的关注。然而,提升大型语言模型在数学推理任务中的表现,传统方法往往依赖大量标注数据和复杂的训练过程,成本高昂且效率低下。最新研究突破传统局限,提出了利用强化学习结合单一训练样本实现模型推理能力大幅跃升的新范式,为深度学习领域注入了新的活力。 强化学习作为机器学习的重要分支,强调通过智能体在环境中的试错和反馈机制,逐步学习最优策略。在大型语言模型中引入强化学习,不仅可以通过反馈奖励机制优化模型决策路径,还能促使模型自我反思和改进。

尤为令人瞩目的是,研究人员采用了仅使用一个可验证奖励的训练样本,成功激励模型提升数学推理能力。这种一例强化学习奖励机制(1-shot RLVR)极大地降低了训练所需的数据规模,且在数学推理基准测试中取得了显著成绩提升。 具体来看,研究团队基于Qwen2.5-Math-1.5B的基础模型,选取了一个特殊的数学推理样本,通过强化学习训练后,模型在MATH500数据集上的准确率由36.0%跃升至73.6%,同样在六个数学推理常用基准的平均表现也从17.6%提升到了35.7%。这一结果令人惊叹地接近利用包含1200个训练样本的DeepScaleR子集所获得的性能表现,证实了单样本强化学习奖励在提升模型推理能力上的巨大潜力。此外,不同模型架构如Qwen2.5-Math-7B、Llama3.2-3B-Instruct、DeepSeek-R1-Distill-Qwen-1.5B也展示了类似的性能跃升,充分说明该方法具有良好的泛化性。 强化学习算法的选择同样成为提升效果的关键因素。

研究中所采用的GRPO和PPO算法各有优势,但均在一例强化学习奖励框架下表现出色。此类算法通过政策梯度优化,使模型策略不断趋向于高质量答案生成路径,从而达到训练目标。特别值得关注的是,研究发现此增强效果主要来自政策梯度损失,而非传统的“grokking”现象,从机制上进一步验证了方法的科学性与创新性。 在训练过程中,研究团队意外观察到几个有趣现象。首先,模型产生了跨领域的泛化能力,能够将单一数学样本的学习经验迁移到其他未见过的任务和领域。其次,模型表现出更频繁的自我反思行为,即在生成答案时主动检查与修正,提高推理的准确性和合理性。

最后,训练准确率达到饱和后,模型仍然持续提升测试集上的表现,这种被称为“后饱和泛化”的现象为强化学习的训练动态提供了新的视角,揭示了数据与模型互动过程中的复杂性。 另一个创新点在于通过增加熵损失促进探索,增强模型搜索不同解答路径的能力。熵损失的引入防止模型过早收敛于次优策略,提升多样性,使得训练过程更加稳健和高效。令人惊讶的是,即使仅应用熵损失而不结合明确奖励,也能使Qwen2.5-Math-1.5B模型在MATH500上性能提升高达27.4%,这表明探索机制本身对模型学习具有深远影响。 这一研究成果不仅为数学推理领域带来突破,也为强化学习与大型语言模型的结合提供了有力证据和技术基础。以极少量训练样本实现大幅提升,极大节省了数据准备的时间和资源投入,推动人工智能向更高效、更智能的方向发展。

此外,模型表现出的跨领域适用性和持续泛化能力为未来多任务学习和跨模态融合任务提供了宝贵经验。 未来,强化学习单样本训练方法有望在更多复杂推理任务中发挥作用,如法律推理、科学发现、医疗诊断等领域。伴随着算法优化和算力提升,其应用范围将进一步扩大。与此同时,研究者们也将更加深入探究模型训练中的后饱和现象、自我反思机制和探索策略,以打破当前性能瓶颈,不断接近甚至超越人类推理能力。 总体而言,强化学习结合单样本训练为大型语言模型在数学推理领域的表现带来了质的飞跃。通过科学的训练设计和创新算法,模型不仅能获得更高准确率,还能展现出强大的泛化和自我完善能力。

这一框架不仅推动了人工智能基础研究进展,也为实际应用场景注入了新活力。相信随着相关技术的不断成熟,强化学习在语言模型中的广泛应用必将引领智能时代的下一次革命。