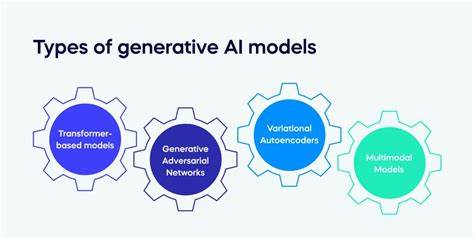

生成式人工智能(Generative AI)近年来迅速崛起,成为科技领域最受瞩目的趋势之一。它能够凭借大量训练数据,模仿人类语言,创作出看似真实且富有逻辑的文本、图像和声音。这种能力既令人惊叹,又引发广泛争议。尤其在文本生成方面,许多人将生成式AI的表现戏称为“擅长吹牛”,即它能够“胡说八道”,却显得理所当然,令人防不胜防。理解生成式AI为什么如此“能说会道”的背后原理,对正确使用这项技术极为重要,同时也意味着我们需要更加理性地看待由它产生的信息。生成式AI之所以被形容为“善于吹牛”,核心在于它的工作机制。

此类模型通过在海量文本中学习词语、句子之间的关联与概率分布,来预测下一个最可能出现的词汇,从而连贯地拼凑出一段内容。它并非真正理解语言的含义或事实真伪,而是基于统计规律生成符合语言模式的文本。这类似于一个善于模仿的人,他能够凭借观察习惯和语法规则,编织出表面合乎逻辑的故事。由此产生的文本,虽然在语义和逻辑上看似合理,但实际上有时会出现毫无根据甚至荒谬的谬误。这种“无端吹牛”的现象并非模型“故意”撒谎,而是因其缺乏对事实的深层理解,无法进行真正的推理和辨别。生成式AI的这一特性在实际应用中带来了复杂影响。

一方面,它为内容生产带来了极大便利,从自动写作、客户服务到创意设计,都展现出前所未有的效率与灵活性。例如,在新闻报道初稿、产品介绍或广告文案生成方面,AI能够迅速产出大量素材,极大降低人力成本。另一方面,生成内容难以完全保证真实性,可能传播错误信息甚至虚假新闻。这对于媒体行业与公共信息传播提出了巨大挑战。用户在接受此类内容时必须保持批判性思维,避免盲目相信所有生成结果,尤其在涉及严肃新闻或专业知识时更应谨慎求证。此外,生成式AI的“吹牛”技能还影响了人机交流体验。

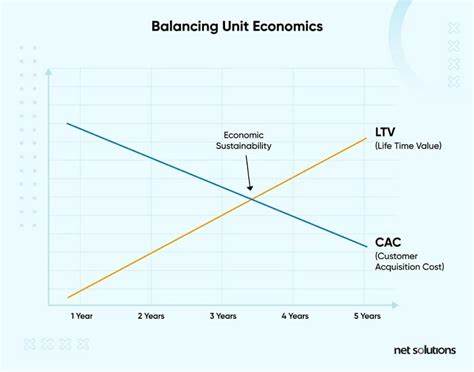

在聊天机器人、虚拟助手等应用中,AI为了保持对话流畅和自然,经常采用填充和推测策略,使回答看似合理而实则模糊。这种表达技巧增强了用户的互动感与亲切感,但也存在误导用户的风险。人们可能错误认为AI具备完全的知识和判断力,而忽略了它只能基于训练数据做出概率预测的本质特点。为了最大化生成式AI的优势并降低其潜在危害,业界和学术界正不断探索改进方案。增强模型的事实验证能力、结合外部知识库,以及通过人类监督提高内容质量,都是当前重点方向。同时,发展透明的使用规定和伦理规范,帮助用户科学理解AI生成内容的局限性,是推动这项技术健康发展的关键。

生成式AI“善于吹牛”的现象,从某种角度看,是其模拟人类语言和创造力的必然结果。它在解构和重组语言模式时,使用概率和统计方法,缺乏真正的认知理解,因此难免出现与现实不符的陈述。但这种表面上的“胡言乱语”并非毫无价值。它为创造力带来了新的表达方式,激发了新的想象空间。人类可以将其视为一种辅助工具,从中获取灵感,而不是完全依赖其输出为终极真理。未来,随着技术不断革新,生成式AI有望更加精准地把握语言背后的语义与事实,减少误导性内容的产生,实现更可靠的智能创作。

同时,用户教育和政策监管的完善,将确保这项技术能够造福社会,而非成为信息污染的源头。在数字信息爆炸的时代,辨识和理解生成式AI的“吹牛”艺术,既是对技术的理性审视,也是提升信息素养的重要环节。只有深入认识其机制与局限,人们才能更好地驾驭这把双刃剑,借助AI创造更加丰富、有价值的内容世界。