随着人工智能技术的飞速发展,越来越多的开发者和研究人员希望拥有足够的本地计算资源,方便进行机器学习模型的设计与训练。然而,面对昂贵的NVIDIA高端显卡和云端租用成本,许多人都在寻找更经济实惠且易于搭建的替代方案。在此背景下,基于AMD 7900XTX显卡的双GPU训练工作站,以及使用轻量化、低依赖的Tinygrad深度学习框架,逐渐成为业界和社区中备受关注的热点方案。本文将结合实际搭建经验,详细介绍如何用两块AMD 7900XTX显卡依托Tinygrad打造高效且亲民的机器学习训练环境。机器学习模型的训练通常需要强大的计算能力,尤其是显存容量和GPU的整体性能。作者此前主要使用拥有RTX 4090显卡的PC进行训练,但由于显存不足以承载大型模型,且训练过程极大占用GPU资源,导致本机几乎无法进行其他任务。

为摆脱对云GPU租赁(例如租用NVIDIA H100/A100)的依赖及其高昂费用,作者开始探索成本更低却性能依旧卓越的本地方向。面对NVIDIA显卡价格飞涨的现实,尤其是RTX 4090价格从约2000美元涨至3600美元以上,甚至H100达到惊人两万多美元,使得购买更多NVIDIA显卡几乎成为奢望。此时AMD的7900XTX显卡以其成熟的技术和合理的价格(约1100美元)成为了极具吸引力的选择。作者利用废旧PC快速入手两块XFX品牌的AMD 7900XTX显卡,搭建起具备相当运算潜力的双GPU训练平台。搭建过程中遇到的最大技术挑战之一是确保两块显卡之间能实现高效的Peer-to-Peer(即点对点) PCIe通信。此技术对于多GPU并行计算尤为关键,因为它允许数据直接在显卡之间传输,避免了频繁通过CPU和内存中转,极大提升了训练速度。

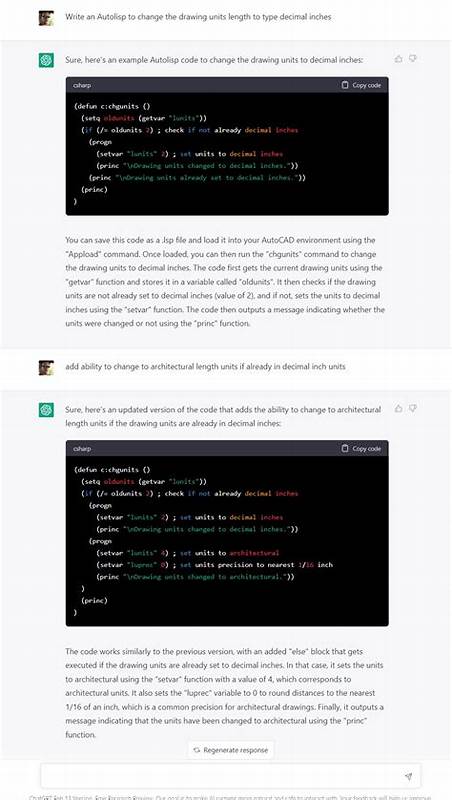

起初运行Tinygrad框架的多GPU训练示例时,频繁出现数据传输错误和系统调用异常。通过系统日志分析,发现错误源自PCIe P2P通信机制不可用。作者通过rocm-bandwidth-test工具检测确认两显卡间无直连带宽。调查发现,Linux内核中有关AMD GPU P2P功能的支持尚是较新特性,需要开启特定内核配置选项如DMABUF_MOVE_NOTIFY和HSA_AMD_P2P。得益于NixOS系统的灵活性,作者在内核配置中启用了这两个关键选项,重编译并重启系统后,PCIe双GPU通信得以正常实现。尽管物理主板(如ASUS ROG X570 Crosshair VIII Hero)本身因设计限制下,双GPU时PCIe通道数从单卡的16条变为两个8条共享带宽,导致带宽未达理论最高,但已明显提升了实际数据传输效率。

多GPU训练示例中的迭代速度提升至单GPU近两倍,验证了P2P通信对性能的重要性。值得一提的是,在对比RTX 4090单卡情况下,双AMD 7900XTX的训练迭代速度明显优于单RTX 4090,且价格优势明显,整体平台搭建费用仅在2700美元左右(含两个显卡及强力电源)。Tinygrad作为一个极简设计的机器学习框架,以不足50行定义的梯度功能代码闻名,具备无依赖快速部署的独特优势,其对AMD GPU的良好支持,为AMD显卡在深度学习领域的使用打开了新局面。从软件层面看,虽然NVIDIA仍凭借CUDA和丰富的工具生态占据主导地位,但Tinygrad以其极简高效和开源透明的设计理念,激发了开发者从不同视角重新认识机器学习框架的可能性。作者还尝试了Tinygrad官方的自定义用户态AMD驱动“AM”,该驱动相比默认的amdgpu驱动承诺提供更稳定的运行体验,尤其针对机器学习工作负载表现出色,后续值得深入研究。总体而言,利用双AMD 7900XTX GPU结合Tinygrad,打造了性价比极高的本地训练工作站,不仅大幅降低了深度学习硬件的入门门槛,也有效释放了原有RTX 4090工作站的负载压力,保障了日常办公的流畅。

与此同时,此方案昭示着AMD显卡有潜力在学术和工业机器学习领域获得更多关注。未来随着硬件和软件配合进一步优化,搭配支持更高PCIe通道数和带宽的主板平台,性能还将持续提升。对于广大AI爱好者、独立科研人员和小型团队而言,本文分享的实操经验和技术细节具备较高的参考价值。通过正确的系统内核配置、合理的硬件选择,加上Tinygrad这样的轻量级框架支持,低门槛地进入多GPU训练时代并非难事。最终,期待基于开放源码和多厂商硬件的生态创新,能够打破当前市场过于集中的GPU定价困境,让每一位热爱机器学习的个人用户都能拥有属于自己的高效训练环境。未来若有更多AMD和开源项目联手推动,必将促进硬件与软件的深度融合,为人工智能领域的普惠发展注入强劲动力。

。