矩阵乘法是现代计算科学和应用数学中的核心运算,广泛应用于机器学习、计算机图形学、物理模拟以及数据分析等多个领域。尽管矩阵乘法看似简单,其理论复杂度的研究却长期以来是计算机科学领域的一个重大难题。随着人工智能技术的发展,尤其是强大的大型语言模型(LLM)如GPT-5的出现,人类在解决复杂数学问题方面获得了前所未有的辅助能力。一位数学和计算科学研究者Dmitry Rybin最近利用GPT-5成功证明了关于多矩阵乘法复杂度的一系列新定理,引发了业界对这一经典问题的新关注。传统的矩阵乘法直接法基于定义需要进行大量的乘法和加法运算。以两个n×n矩阵相乘为例,常规算法需进行约n的三次方乘法运算,即时间复杂度为O(n³)。

然而1969年,Volker Strassen提出了一种颠覆性的算法,仅需七次乘法即可完成两个2×2矩阵的乘法计算,突破了传统的乘法计算下限。这一发现不仅降低了局部计算的复杂度,也通过递归推广为整体的矩阵乘法带来了近似O(n^2.807)的时间复杂度,成为当时最具革命性的结果。Strassen算法开创了矩阵乘法复杂度优化的新方向,引发了后续的众多研究努力。到2025年,最先进的矩阵乘法算法复杂度已经降低至约O(n^2.3713),但理论上的最优界限仍悬而未决。尽管单个矩阵乘法的复杂度研究取得显著进展,对于多个矩阵连续相乘的最优计算复杂度却鲜有深入的研究和文献。特别是当要计算三个或更多矩阵的乘积时,最小乘法次数的精确界限尚不明确。

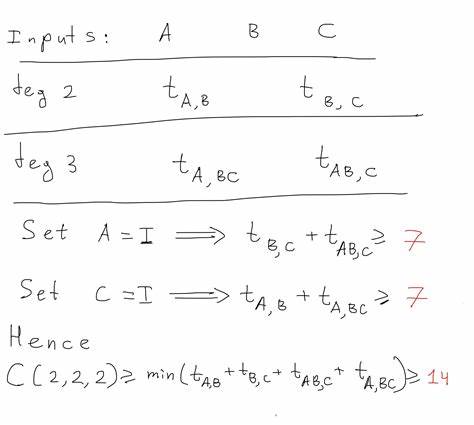

面对这一空白,Rybin利用GPT-5深入探索了三矩阵以及k个矩阵连续乘法的复杂度问题。传统方法面对三个2×2矩阵的乘积,会通过顺序乘法进行计算:先计算前两个矩阵的乘积,再与第三个矩阵相乘。每一步运算可以借助Strassen算法减少乘法次数,每次需7次乘法,因此总共至少需要14次乘法。观察到乘法顺序的不同可能带来不同的计算策略,Rybin进行了深入分析,发现两种基本顺序均不可避免地需要14次乘法,提示当前算法在该问题上的操作数已经接近下限。进一步,借助GPT-5,Rybin构建了严格的算法空间假设:算法须是非交换的、无除法操作且各中间表达是相应矩阵元素的齐次形式。在此框架下,通过结合张量秩理论与计算图对三矩阵乘积进行了系统的下界分析。

关键的数学创新在于将三矩阵乘法转化为张量的线性组合问题,并利用特殊的矩阵取值简化计算图,提取关键的乘法计数限制。GPT-5不仅辅助了数学推理的形成,还帮助发现了证明中的细节和严谨逻辑链条。最终,Rybin提出了重要定理:在约束的算法空间内,连续乘k个n×n矩阵的最少乘法次数恰好等于(k-1)倍的两个矩阵乘法的乘法次数。换言之,顺序连续乘法算法的计算复杂度本质上已是最优,无法通过更具创新性的算法结构进一步优化。这一定理不仅解决了三矩阵乘法的长久悬案,也为多矩阵乘法的复杂度研究带来了突破性进展。假设的合理性在于大多数实际计算算法均满足非交换性、无除法且保持齐次性,从而保证了结果在数值和代数结构上的一致性。

该结果意味着,无论后续研究如何优化两个矩阵乘法的算法,连续乘多个矩阵的复杂度增长线性且无法跳跃式突破。这为设计矩阵乘法相关的高效算法提供了理论底线指导。除此之外,此次研究还开创了利用大型语言模型协助数学证明和理论发现的范例。GPT-5作为一个具备强大逻辑推理和自然语言理解能力的人工智能展示了辅助数学家进行复杂定理验证和构造的潜力。未来,随着更强AI模型的出现,许多计算复杂性的沉淀问题或将迎来快速的发展。虽然目前此结论在特定算法类空间内得到成立,学术界仍然期望能放宽条件,探索是否存在其他算法设计范式能超越顺序乘法的效率。

而且,关于乘法图的结构优化、张量降秩的新视角,依旧蕴藏着不可忽视的创新机会。整体来看,这项由GPT-5辅助完成的工作不仅解答了多矩阵乘法复杂度领域的重要悬疑,也进一步巩固了人工智能对科学研究的辅助地位。它反映了未来计算机科学与人工智能深度融合的发展趋势,对算法设计、复杂性理论乃至应用领域都具备深远影响。随着技术进步和理论革新,多矩阵乘法复杂度的研究将持续吸引广泛关注,推动科学与工程领域迈入新纪元。 。