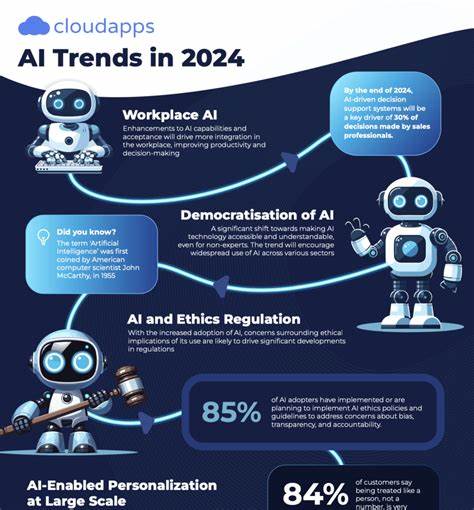

随着人工智能技术的飞速发展,尤其是大语言模型(LLM)应用的广泛普及,AI供应链的安全风险日益引发业界关注。人工智能系统并非凭空产生,而是由模型、插件、训练数据及适配器等多种组件拼接而成,这些元素来自全球各地的开发者和第三方,为AI赋能的同时也带来了复杂的安全隐患。OWASP,作为业界权威的应用安全组织,认识到AI供应链中潜藏的巨大风险,将其列为影响LLM应用的十大关键威胁之一,进而提出了一套切实可行的安全防护方案,旨在打造一个透明、可追溯且可信赖的AI开发生态。首先,OWASP推荐构建实时更新的人工智能材料清单(AI Bill of Materials,简称AI-BOM),这是一份涵盖所有模型、插件、适配器、训练文件及第三方依赖的详细库存。将AI-BOM视为关键基础设施,确保其经过数字签名、安全存储并遵循统一标准(如CycloneDX格式),可极大提高对组件来源及状态的可见性。只有在清晰了解AI产品构成后,企业才能对其进行有效的安全管理。

其次,养成良好的基础设施卫生习惯至关重要。OWASP借鉴传统软件开发中的持续集成与持续部署(CI/CD)流程,建议组织定期对机器学习开发堆栈进行漏洞扫描,及时修补过期或存在安全隐患的组件。忽视更新意味着黑客能够借机利用已知漏洞发起攻击,从而在产品投产之前便埋下安全隐患。第三,模型溯源问题同样不可忽视。在开源社区和公共平台托管的模型及其权重文件,常缺乏加密验证或明确的作者认证,使得恶意篡改或身份冒用成为可能。OWASP强调文件签名、哈希校验及发布者身份验证的重要性,以确保存储和分发的AI模型内容真实可靠。

下载时应优先选择经过验证的组织或开发者维护的仓库,避免使用未经验证的个人分支或缺乏足够元数据的“神秘上传”文件,即使它们获得了社区的好评,也存在较大风险。特别值得注意的是,OWASP对LoRA适配器的安全风险给予高度关注。作为轻量化的模块化微调文件,LoRA适配器能快速定制通用基础模型以完成特定任务,因其小巧且易于合并的特性被广泛采用。然而,这也意味着如果来源不明或未经严格审查,这类文件极易成为攻击载体。对此,OWASP建议对LoRA适配器进行异常检测、对抗性测试,并优先使用具备文件签名机制的安全注册中心。业界正进一步研究自动化红队测试,通过模拟攻击者手段持续监测模型行为是否出现异常漂移,从而及时发现潜在的恶意注入。

为了堵住供应链中的“漏洞”,OWASP强调从研发环节开始全面扫描各类文件和配置。在GitHub等协作开发环境中,推行构建时扫描和拉取请求验证相当于设置一道安全屏障,确保只有经过安全检查的组件能被合并进入主分支。诸如SF_Convertbot扫描器等专业工具可以准确检测safetensors格式的文件是否被篡改。相较于传统的PyTorch pickle文件,这种静态安全格式避免了恶意代码执行的风险。此类安全措施虽会引入一定流程延迟,却有效阻挠恶意贡献者,保护团队免遭潜伏威胁。部署环节同样不可掉以轻心。

随着大量LLM被嵌入移动设备、物联网甚至个人自带设备(BYOD)中,OWASP提醒开发者密切关注端点的安全防护。通过加密存储模型、验证固件签名及在检测到未经授权的修改时立即终止程序执行,能够有效阻止恶意篡改,确保模型在受信硬件环境下安全运行。供应链安全还涵盖与第三方供应商的合作风险,涉及适配器、插件、训练服务和托管基础设施等。自动化工具能帮助企业持续追踪开源许可条款的变化及访问政策更新,避免因供应商变更带来的业务中断和安全泄露。现实中,诸如PoisonGPT污染模型、ShadowRay入侵AI编排工具以及LeftoverLocals利用GPU内存泄露窃取会话等事件,均验证了供应链薄弱环节带来的真实威胁。这些攻击未依赖于复杂的提示注入或“越狱”技术,而是通过供应链安全缺陷实现。

OWASP明确表示,不求完美,但求责任。从构建详尽的AI-BOM、对所有适配器进行签名,到严格审查拉取请求,这些步骤虽显微小,却带来了可见性、可跟踪性及安全信心的极大提升。保障AI供应链安全是所有AI构建者的共同使命,技术工具已准备就绪,路线图也已绘制完毕,接下来需要从业者发挥主动性,将安全规范融入开发流程。只有这样,才能打破供应链中的安全瓶颈,为人工智能带来更加稳健和可信的未来。