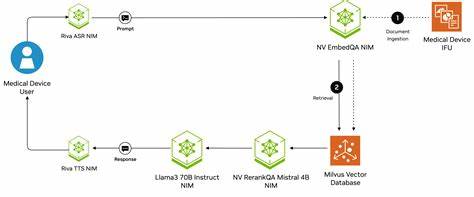

随着人工智能技术的不断发展,智能助手已成为提升工作效率的重要工具之一。在众多AI助手中,Niffler凭借其独特的基于Nim语言的设计理念和创新的多智能体系统,正迅速引起业内的广泛关注。作为一款具备分布式架构、内置工具系统和多模型支持的AI助手,Niffler不仅为开发者提供了强大且灵活的交互体验,还赋能了多场景协同办公和自动化应用。本文将全面剖析Niffler的核心技术亮点、系统架构和实际应用,探索它如何在AI助手领域掀起新一轮革命。 Niffler最初灵感来源于Claude Code,但其设计与实现具有独特的创新性,尤其是在多智能体分布式系统架构上的突破。Niffler将不同的智能体(agent)作为独立进程运行,各智能体由专门的职能划分,比如编码、研究和Shell操作,每个智能体具备独立的权限控制和工具集。

这种结构让系统实现了高度的模块化和扩展性,智能体之间通过NATS消息队列进行交互,形成立体化的"聊天室"协同模式。 在分布式多智能体设计中,Niffler采用Master-Worker模式,由主控进程协调各智能体的任务分配和消息转发。每个智能体进程运行于独立的终端环境,具备独立的内存空间和线程安全机制,保证同时处理API请求、用户界面操作和工具执行的高效性。此设计不仅提高了系统的鲁棒性,也为多任务处理提供了有力保障。此外,Niffler还借助MySQL兼容的TiDB数据库,实现了对会话历史、智能体状态及使用记录的持久化存储,确保对话的连续性和上下文一致性。 Niffler的多模型支持优势显著,允许用户无缝切换包括OpenAI的GPT系列、Anthropic模型以及兼容的第三方API接口。

系统内置了计划/编码模式,可针对不同任务自动切换相应的系统提示和交互逻辑,进一步提升智能体在特定场景的响应准确度和效率。值得一提的是,Niffler支持动态系统提示的注入,能够根据当前工作空间、Git状态及项目细节自动调整上下文信息,从而实现更加个性化和上下文相关的AI交互体验。 在工具系统方面,Niffler内置了多种核心实用工具,如Shell命令执行、文件读取与编辑、目录列表及网络内容抓取等。这些工具经过严格权限管理和路径安全过滤,保障了AI助手操作环境的安全稳定。同时,Niffler还支持通过模型上下文协议(MCP)进行扩展,用户可以配置外部MCP服务器,自动发现额外的工具功能,如文件系统操作、GitHub集成及版本控制管理,极大增强了系统的灵活性和丰富度。 Token计数与成本追踪是Niffler的另一大亮点。

该系统采用启发式算法结合动态学习机制,无需重量级分词器,就能实现对不同语言模型的高精度token估算。通过持续和实际API响应数据比对,系统能自我调整修正因子,提高费用估算的准确性和优化策略,为用户提供更具成本效益的AI调用体验。 Niffler的安装和使用过程相对简便。依赖Nim 2.2.4以上版本及NATS消息队列服务器,后者可通过Docker、二进制包或操作系统包管理器等多种方式部署。系统默认开启JetStream持久化数据支持,确保消息传输的可靠性。用户通过简单的配置文件管理AI模型和工具权限,即可启动Master进程和多智能体进程,实现分布式多任务协同。

使用者可在交互式命令行中轻松调用指定智能体完成任务,也可利用任务模式实现自动化脚本操作,满足多样化使用场景需求。 Niffler不仅注重功能强大,也赋予用户高度的自定义能力。通过编辑配置文件中的NIFFLER.md,用户能够灵活修改系统提示、调整模型参数及定制交互流程。同时,丰富的日志级别和调试选项提供了完善的系统监控和故障排查支持,方便开发和维护。官方文档涵盖了从架构设计、工具开发、MCP集成到多智能体任务流程的详尽指导,满足开发者深入探索和二次开发的需求。 作为一个开源项目,Niffler以MIT许可协议发布,鼓励社区贡献代码、报告问题和提出改进建议。

其采用Nim语言的选择不仅带来了卓越的执行性能和跨平台兼容性,也彰显了Nim在构建高性能系统软件领域的潜力。二十余个贡献者的联合参与和持续迭代,确保Niffler具备良好的稳定性和功能持续演进能力。 总结来看,Niffler作为新一代AI助手,集成了分布式多智能体架构、多模型兼容、灵活安全的工具系统以及智能化成本控制机制,提供了极具竞争力的开发与使用体验。它不仅适合个人开发者进行代码辅助和知识检索,也能够满足企业级多角色协同场景的复杂需求。随着AI技术的不断深化和Nim生态的逐步壮大,Niffler有望引领未来AI助手的发展潮流,为智能助理领域带来更多创新可能。未来的更新中,进一步优化可视化交互界面和跨平台适配将成为重要方向,持续丰富MCP生态和工具插件体系也会进一步释放Niffler的强大潜力。

用户和开发者都值得密切关注这一充满活力的项目,以便第一时间享受其带来的高效生产力革新。 。